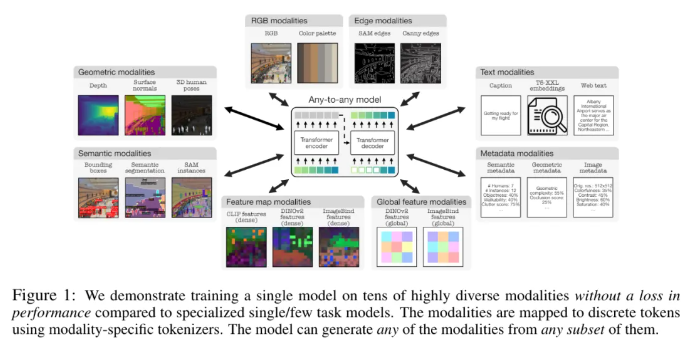

A Apple e a Ecole Polytechnique Fédérale de Lausanne (EPFL) na Suíça colaboraram para desenvolver um modelo multimodal inovador, 4M-21. O modelo pode ser treinado em 21 modalidades diferentes, seu desempenho é significativamente melhor do que os modelos existentes e realiza múltiplas funções, como recuperação intermodal e geração controlável. Esta pesquisa melhorou muito o desempenho e a adaptabilidade do modelo, expandindo o modelo e o tamanho do conjunto de dados, aumentando o tipo e o número de modalidades de treinamento e adotando uma estratégia de treinamento conjunta. O modelo 4M-21 adota uma arquitetura codificadora-decodificadora baseada em Transformer e adiciona incorporações modais adicionais para se adaptar a novas modalidades. Seu processo de treinamento considera totalmente as características de diferentes modalidades e utiliza método de tokenização específico para modais.

Este estudo adotou uma solução de pré-treinamento 4M, que pode melhorar o desempenho e a adaptabilidade do modelo, expandindo o tamanho do modelo e dos conjuntos de dados, aumentando o tipo e o número de modalidades envolvidas no treinamento do modelo e conduzindo treinamento conjunto em múltiplos conjuntos de dados. Os pesquisadores usam diferentes métodos de tokenização para discretizar modalidades com diferentes recursos, como incorporações de imagens globais, poses humanas e instâncias semânticas. Em termos de seleção de arquitetura, este estudo adota a arquitetura codificador-decodificador 4M baseada no Transformer e adiciona incorporações modais adicionais para se adaptar a novas modalidades.

Este modelo pode não apenas executar uma série de tarefas de visão comuns prontas para uso, como estimativa de normal e profundidade de superfície DIODE, semântica COCO e segmentação de instância, estimativa de pose humana 3DPW3D, etc., mas também pode gerar modalidades de treinamento arbitrárias e suportar vários A geração refinada e multimodal é executada, e imagens RGB ou outras modalidades podem ser recuperadas usando outras modalidades como consultas. Além disso, os pesquisadores também conduziram experimentos de transmissão multimodal em NYUv2, segmentação semântica Hypersim e ARKitScenes.

Seus importantes recursos funcionais incluem:

Modalidades qualquer-para-qualquer: Aumento de 7 modalidades do melhor modelo qualquer-para-qualquer existente para 21 modalidades diferentes, permitindo recuperação intermodal, geração controlável e poderoso desempenho pronto para uso.

Suporte à diversidade: adicione suporte para dados mais estruturados, como poses humanas, instâncias SAM, metadados e muito mais.

Tokenização: Estude a tokenização discreta para diferentes modalidades usando métodos específicos de modalidade, como incorporações de imagens globais, poses humanas e instâncias semânticas.

Dimensionamento: expanda o tamanho do modelo para parâmetros de 3B e o conjunto de dados para amostras de 0,5B.

Treinamento colaborativo: treinamento colaborativo sobre visão e linguagem ao mesmo tempo.

Endereço do artigo: https://arxiv.org/pdf/2406.09406

Destaques:

- Pesquisadores da Apple e da Ecole Polytechnique Fédérale de Lausanne (EPFL), na Suíça, desenvolveram em conjunto um modelo único de modalidade qualquer para qualquer que pode ser treinado em 21 modalidades diferentes.

- O modelo pode realizar uma série de tarefas de visão comuns prontas para uso e também é capaz de gerar modalidades de treinamento arbitrárias, suportando vários métodos para realizar geração refinada e multimodal.

- Os pesquisadores também conduziram experimentos de transmissão multimodal em NYUv2, segmentação semântica Hypersim e ARKitScenes.

Em suma, o modelo 4M-21 registou progressos significativos no domínio da investigação multimodal. O seu poderoso desempenho e as amplas perspectivas de aplicação proporcionam uma nova direcção para o desenvolvimento futuro da inteligência artificial multimodal. Vale a pena aguardar o código aberto e as aplicações futuras deste modelo.