Equipes de pesquisa da Universidade de Nanjing, da Universidade Fudan e do Laboratório Arca de Noé da Huawei fizeram grandes avanços no campo dos humanos digitais 3D, resolvendo os problemas de consistência multivisão insuficiente e expressividade emocional nos métodos existentes. Eles desenvolveram um novo método que permite a síntese de avatares falantes em 3D com emoções controláveis e alcança melhorias significativas na sincronização labial e na qualidade da renderização. Os resultados da pesquisa são baseados no conjunto de dados EmoTalk3D recém-construído, que contém vídeos calibrados de visualização múltipla, anotações emocionais e informações geométricas 3D quadro a quadro, e foi tornado público para uso em pesquisas não comerciais. Através da estrutura de mapeamento "da fala à geometria e à aparência", este método captura com precisão expressões faciais sutis e alcança renderização de alta fidelidade sob ângulos de visão livres.

Entrada do produto: https://nju-3dv.github.io/projects/EmoTalk3D/

Eles coletaram o conjunto de dados EmoTalk3D com vídeos calibrados de visualização múltipla, anotações de emoções e geometria 3D quadro a quadro. E é proposto um novo método para sintetizar avatares falantes em 3D com emoções controláveis, com melhorias significativas na sincronização labial e na qualidade de renderização.

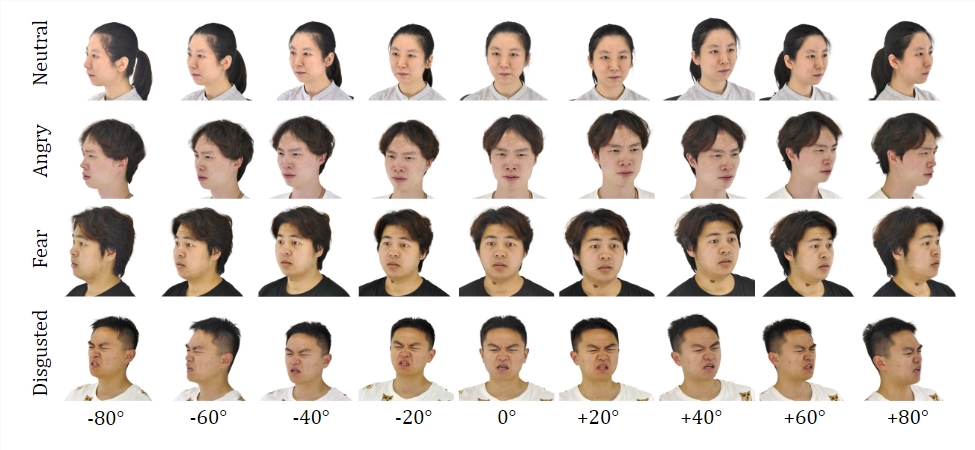

Conjunto de dados:

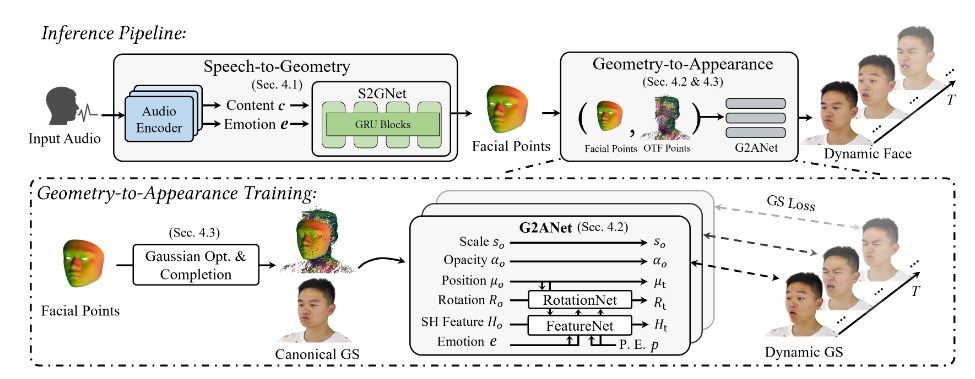

Ao treinar no conjunto de dados EmoTalk3D, a equipe de pesquisa construiu uma estrutura de mapeamento “da fala à geometria e à aparência”. Uma sequência geométrica 3D realista é primeiro prevista a partir de recursos de áudio e, em seguida, a aparência de uma cabeça falante 3D representada por um Gaussiano 4D é sintetizada com base na geometria prevista. As aparências são ainda decompostas em gaussianas padrão e dinâmicas, aprendidas em vídeos de visualização múltipla e fundidas para renderizar animações de cabeças falantes de visualização livre.

O modelo permite emoções controláveis em avatares falantes gerados e os renderiza em uma ampla gama de ângulos de visão. Demonstrou melhor qualidade de renderização e estabilidade na geração de movimentos labiais enquanto captura detalhes faciais dinâmicos, como rugas e expressões sutis. No exemplo dos resultados gerados, as expressões de felicidade, raiva e frustração do humano digital 3D são exibidas com precisão.

Seu processo geral contém cinco módulos:

O primeiro é um codificador de decomposição de conteúdo emocional, que analisa o conteúdo e os recursos emocionais da fala de entrada; o segundo é uma rede de fala para geometria, que prevê nuvens de pontos 3D dinâmicas a partir de recursos; o terceiro é um módulo de otimização e conclusão gaussiana para estabelecer; uma aparência padrão; a quarta é a geometria para a aparência. A rede sintetiza a aparência facial com base na nuvem de pontos 3D dinâmica;

Além disso, eles construíram o conjunto de dados EmoTalk3D, um conjunto de dados de cabeças falantes multivisualização com anotações emocionais e formas faciais 3D quadro a quadro, que será disponibilizado ao público para fins de pesquisa não comercial.

Destaque:

Propor um novo método para sintetizar humanos digitais com emoções controláveis.

Construa uma estrutura de mapeamento “da fala à geometria e à aparência”.

O conjunto de dados EmoTalk3D está estabelecido e pronto para ser aberto.

Esta pesquisa fornece uma nova direção para o desenvolvimento da tecnologia humana digital 3D. Os métodos e conjuntos de dados propostos fornecerão recursos valiosos para pesquisas futuras e promoverão o desenvolvimento de tecnologia humana digital 3D que seja mais realista e emocionalmente expressiva. A abertura do conjunto de dados EmoTalk3D também promove a cooperação e o intercâmbio na comunidade acadêmica.