A Adobe, como gigante na área de software criativo, causou grande polêmica ao atualizar seus termos de serviço. Esta atualização permite que a Adobe acesse os trabalhos dos usuários para melhorar seu modelo de IA Firefly, uma medida que tem sido amplamente criticada como uma “cláusula overlord” que viola os direitos autorais e a privacidade dos usuários. Este artigo irá fornecer uma análise aprofundada da polêmica causada pela atualização dos termos de serviço da Adobe, explorar as razões por trás disso e a relação cada vez mais tensa entre empresas de tecnologia e usuários.

Adobe, um nome bem conhecido nas indústrias criativas, é conhecido como “Copyright Guardian” por sua postura em relação à proteção de direitos autorais. Mas recentemente, a empresa foi pega no vórtice da opinião pública por causa de termos de serviço atualizados discretamente.

Em fevereiro deste ano, a Adobe atualizou discretamente os termos de serviço de seus produtos, adicionando uma adição atraente: os usuários devem concordar que a Adobe pode acessar seus trabalhos por meios automatizados e manuais, incluindo aqueles protegidos por acordos de confidencialidade. A Adobe usará esses trabalhos para melhorar seus serviços e software por meio de tecnologias como aprendizado de máquina. Se os usuários não concordarem com estes novos termos, não poderão usar o software da Adobe.

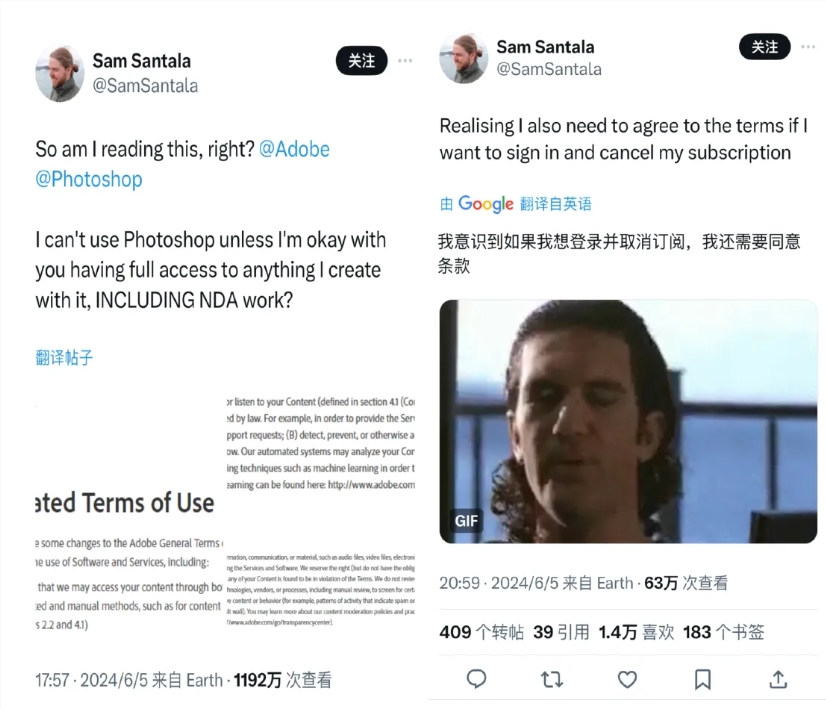

A mudança foi revelada recentemente, provocando uma reação negativa dos principais usuários da Adobe, incluindo criativos, artistas digitais e designers. Eles acreditam que esta é uma autorização obrigatória, essencialmente uma “cláusula overlord”, e seu verdadeiro objetivo é treinar o modelo de IA generativo “Firefly” da Adobe. Um blogger chamado Sam Santala questionou esta disposição no Twitter, e o seu tweet recebeu dezenas de milhões de visualizações.

Muitos usuários expressaram preocupações sobre sua privacidade e direitos autorais e optaram por parar de usar os produtos da Adobe. Ao mesmo tempo, a Meta tomou medidas semelhantes e atualizou a sua política de privacidade para permitir a utilização de informações partilhadas pelos utilizadores nos produtos e serviços Meta para treinar IA. Se os usuários não concordarem com a nova política de privacidade, deverão considerar parar de usar produtos de mídia social, como Facebook e Instagram.

Com o rápido desenvolvimento da tecnologia de IA, a batalha entre empresas de tecnologia e usuários pela privacidade de dados, propriedade e controle de conteúdo tornou-se cada vez mais acirrada. A Adobe afirma que os dados de treinamento para seu modelo Firefly vêm de centenas de milhões de imagens na biblioteca de imagens da Adobe, algumas imagens licenciadas publicamente e imagens públicas cuja proteção de direitos autorais expirou. No entanto, outras ferramentas de geração de imagens de IA, como Stable Diffusion da Stability AI, Dall-E2 e Midjourney da OpenAI, têm sido controversas devido a questões de direitos autorais.

A Adobe está tentando adotar um posicionamento de mercado diferenciado nesta área e se tornar um “cavaleiro branco” na corrida armamentista de IA, enfatizando a legitimidade de seus dados de treinamento de modelo e prometendo pagar reclamações em disputas de direitos autorais causadas pelo uso de imagens geradas por Adobe Firefly. Mas a estratégia não acalmou as preocupações de todos os utilizadores. Alguns usuários, como o designer sênior Ajie, se autodenominam brincando de "vítimas genuínas da Adobe" e acreditam que a Adobe usa seu enorme ecossistema criativo para treinar IA. Embora seja uma estratégia de negócios inteligente, para os usuários, a plataforma e a criação A distribuição de interesses entre. os usuários e o direito do usuário de saber estão faltando.

Além disso, as disputas de direitos autorais com a Adobe foram repetidamente expostas no exterior, fazendo com que os usuários questionassem se a Adobe realmente respeita os direitos autorais dos criadores. Por exemplo, o artista Brian Kesinger descobriu que imagens geradas por IA semelhantes ao seu trabalho estavam sendo vendidas em seu nome na biblioteca de imagens da Adobe sem o seu consentimento. O espólio do fotógrafo Ansel Adams também acusou publicamente a Adobe de supostamente vender imitações de IA generativas do trabalho do falecido fotógrafo.

Sob pressão da opinião pública, a Adobe revisou seus termos de serviço em 19 de junho, deixando claro que não utilizará conteúdo de usuário armazenado localmente ou na nuvem para treinar modelos de IA. Mas o esclarecimento não acalmou totalmente as preocupações dos criadores. Alguns blogueiros conhecidos no círculo internacional de IA apontaram que os termos de serviço revisados da Adobe ainda permitem o uso de dados de nuvem privada dos usuários para treinar modelos de aprendizado de máquina de ferramentas de IA não generativas. Embora os usuários possam optar por não participar da “análise de conteúdo”, a complicada operação de cancelamento muitas vezes afasta muitos usuários.

Diferentes países e regiões têm regulamentações diferentes sobre a proteção de dados dos utilizadores, o que também afeta as estratégias das plataformas de redes sociais na formulação dos termos de serviço dos utilizadores. Por exemplo, ao abrigo do Regulamento Geral de Proteção de Dados (GDPR), os utilizadores no Reino Unido e na UE têm o “direito de oposição” e podem optar explicitamente por não permitir que os seus dados pessoais sejam utilizados para treinar os modelos de inteligência artificial da Meta. No entanto, os usuários dos EUA não têm o mesmo direito de saber. De acordo com a política de compartilhamento de dados existente da Meta, o conteúdo postado por usuários dos EUA nos produtos de mídia social da Meta pode ter sido usado para treinar IA sem consentimento explícito.

Os dados têm sido aclamados como o “novo petróleo” na era da IA, mas ainda existem muitas áreas cinzentas na “exploração” de recursos. Algumas empresas tecnológicas adoptaram uma abordagem vaga na obtenção de dados dos utilizadores, o que desencadeou um duplo dilema dos direitos de informação pessoal dos utilizadores: propriedade de direitos de autor digitais e questões de privacidade de dados, prejudicando gravemente a confiança dos utilizadores na plataforma.

Atualmente, a plataforma ainda apresenta grandes deficiências para garantir que a IA generativa não infringe os direitos dos criadores, e também carece de supervisão adequada. Alguns desenvolvedores e criadores tomaram medidas e lançaram uma série de ferramentas "anti-IA", desde a ferramenta de proteção de trabalho Glaze até a ferramenta de envenenamento de dados de IA Nightshade, até a comunidade anti-IA Cara, que se tornou popular em face de uso não autorizado de usuários/criadores por empresas de tecnologia Com o consentimento do autor, dados relevantes são capturados para treinar o modelo de IA, e a raiva das pessoas se intensificou.

Hoje, com o rápido desenvolvimento da tecnologia de IA, como equilibrar a inovação tecnológica e a segurança da privacidade do utilizador e proteger os direitos e interesses dos criadores ainda aguarda um maior desenvolvimento da indústria e a melhoria contínua das medidas regulamentares legais. Ao mesmo tempo, os utilizadores precisam de estar mais vigilantes, compreender os seus direitos sobre os dados e tomar medidas quando necessário para proteger as suas criações e privacidade.

O incidente da Adobe é apenas a ponta do iceberg das questões de compensação de dados na era da IA. No futuro, como encontrar um equilíbrio entre o progresso tecnológico e os direitos do usuário se tornará uma questão importante para todas as empresas de tecnologia e agências reguladoras. . Somente fortalecendo a supervisão e clarificando as regras de utilização de dados poderemos construir um ambiente ecológico de IA mais saudável e sustentável.