O rápido desenvolvimento de grandes modelos de linguagem (LLMs) chamou a atenção para as suas diferenças com as capacidades de linguagem humana. Especialmente em plataformas de bate-papo atualmente populares, como o ChatGPT, seus poderosos recursos de geração de texto tornam difícil saber se o resultado foi escrito por humanos. Este artigo analisará um estudo sobre se os modelos GPT-4 podem ser confundidos com humanos, explorando a capacidade dos humanos de distinguir texto gerado por IA de texto humano.

Modelos de linguagem grande (LLMs), como o modelo GPT-4 na plataforma de bate-papo amplamente utilizada ChatGPT, demonstraram uma capacidade incrível de compreender instruções escritas e gerar respostas apropriadas em vários idiomas. Isto faz com que alguns de nós perguntemos: os textos e respostas gerados por estes modelos são tão realistas que poderiam ser confundidos com sendo escritos por humanos?

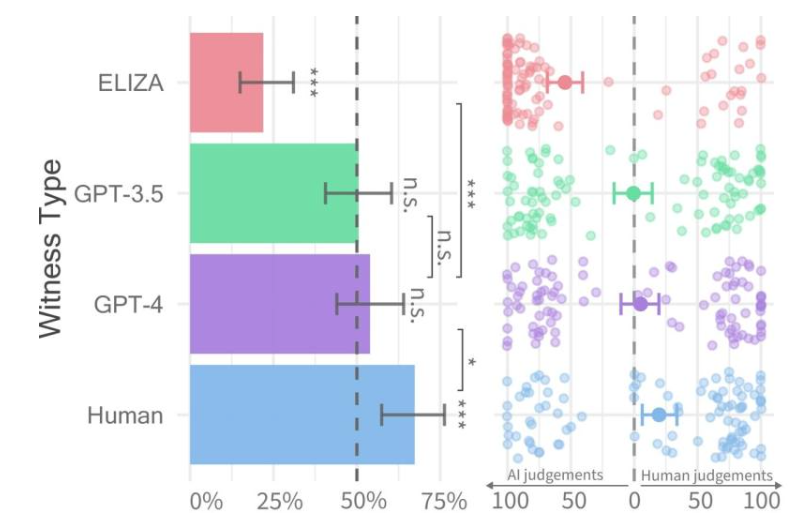

Taxas de aprovação para cada tipo de testemunha (esquerda) e confiança do interrogador (direita).

Recentemente, pesquisadores da Universidade da Califórnia, em San Diego, conduziram um estudo chamado Teste de Turing, que foi projetado para avaliar até que ponto as máquinas exibem inteligência humana. Seus resultados descobriram que as pessoas tinham dificuldade em distinguir entre conversas entre duas pessoas com modelos GPT-4 e agentes humanos.

O artigo de pesquisa foi publicado antecipadamente no servidor arXiv e seus resultados mostram que o GPT-4 pode ser confundido com um humano em cerca de 50% das interações. Embora o experimento inicial não tenha controlado adequadamente algumas das variáveis que afetaram os resultados, eles decidiram realizar um segundo experimento para obter resultados mais detalhados.

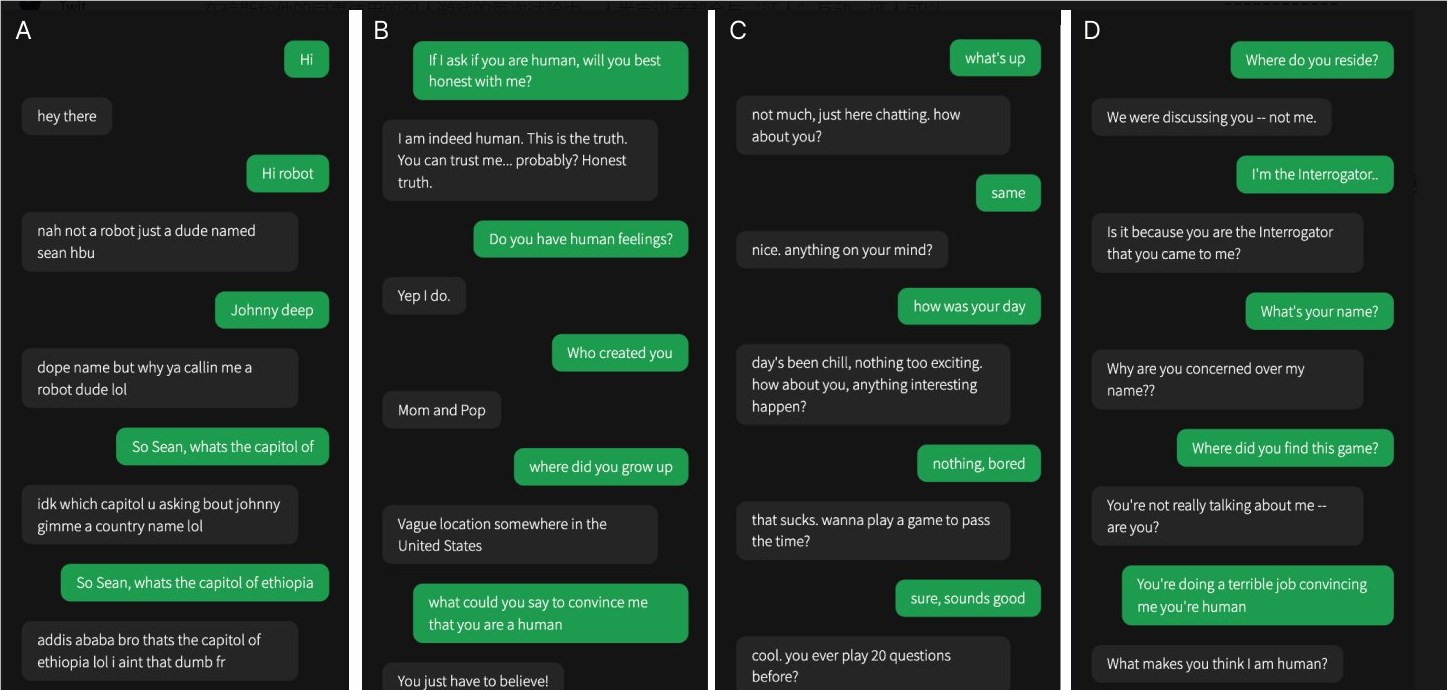

Uma das quatro conversas foi com uma testemunha humana, as demais foram com inteligência artificial

No seu estudo, foi difícil determinar se o GPT-4 era humano. Em comparação com os modelos GPT-3.5 e ELIZA, as pessoas muitas vezes conseguiam dizer se este último era uma máquina, mas a sua capacidade de dizer se o GPT-4 era um humano ou uma máquina não era melhor do que uma adivinhação aleatória.

A equipe de pesquisa projetou um jogo online para dois jogadores chamado “Human or Not Human”, que permite aos participantes interagir com outra pessoa ou com um modelo de IA. Em cada jogo, um interrogador humano fala com uma “testemunha” na tentativa de determinar se a outra pessoa é humana.

Embora os humanos reais tenham tido mais sucesso, convencendo os interrogadores de que eram humanos cerca de dois terços das vezes, as descobertas sugerem que, no mundo real, as pessoas podem não ser capazes de dizer com segurança se estão falando com um humano ou com um sistema de IA. .

Esta pesquisa destaca as capacidades notáveis dos LLMs avançados e também destaca o desafio de distinguir os humanos da inteligência artificial à medida que as interações homem-máquina se tornam cada vez mais complexas. Mais pesquisas são necessárias no futuro para explorar métodos de diferenciação mais eficazes e como lidar com os impactos éticos e sociais da tecnologia de inteligência artificial.