Com o rápido desenvolvimento de modelos multimodais de grandes línguas (MLLM), a integração eficaz das modalidades visuais, linguísticas e de fala tornou-se um ponto importante de pesquisa. No entanto, os desafios trazidos pelas diferenças essenciais nos diferentes dados modais, como a informação espacial da visão e a informação da série temporal da fala, dificultam a interação multimodal eficiente. Os métodos existentes geralmente dependem de módulos ASR e TTS independentes, o que aumenta a latência e reduz a suavidade da interação. Este artigo apresenta o VITA-1.5, um modelo de linguagem multimodal em grande escala que integra visão, linguagem e fala, com o objetivo de resolver esses problemas.

Recentemente, progressos significativos foram feitos em modelos multimodais de grandes linguagens (MLLM), especialmente na integração de modalidades visuais e textuais. No entanto, com a crescente popularidade da interação humano-computador, a importância das modalidades de fala tornou-se cada vez mais proeminente, especialmente em sistemas de diálogo multimodais. A voz não é apenas um meio fundamental para a transmissão de informações, mas também melhora significativamente a naturalidade e a conveniência das interações.

No entanto, devido às diferenças essenciais entre dados visuais e de fala, integrá-los ao MLLM não é trivial. Por exemplo, os dados visuais transmitem informações espaciais, enquanto os dados de fala transmitem mudanças dinâmicas em séries temporais. Estas diferenças fundamentais trazem desafios à otimização simultânea das duas modalidades, muitas vezes levando a conflitos durante o processo de formação. Além disso, os sistemas tradicionais de conversão de fala dependem de módulos separados de reconhecimento automático de fala (ASR) e de conversão de texto em fala (TTS), o que aumenta a latência e reduz a coerência, limitando sua utilidade em aplicações em tempo real.

Para enfrentar estes desafios, os investigadores lançaram o VITA-1.5, um modelo de linguagem multimodal em grande escala que integra visão, linguagem e fala. VITA-1.5 usa um método de treinamento de três estágios cuidadosamente projetado para introduzir gradualmente dados visuais e de fala para aliviar conflitos modais, mantendo ao mesmo tempo um forte desempenho multimodal.

No primeiro estágio, o modelo se concentra no treinamento linguístico visual, construindo fortes capacidades visuais por meio do treinamento de adaptadores visuais e do ajuste fino do modelo usando legendas descritivas e dados visuais de perguntas e respostas.

O segundo estágio introduz o processamento de entrada de áudio, treinando o codificador de áudio usando dados pareados de transcrição de fala e, em seguida, ajustando-o usando dados de perguntas e respostas de fala, para que o modelo possa compreender e responder efetivamente à entrada de áudio. Finalmente, no terceiro estágio, o decodificador de áudio é treinado para obter saída de voz de ponta a ponta sem a necessidade de módulos TTS externos, permitindo assim que o VITA-1.5 gere respostas de fala suaves e melhore a naturalidade e a interatividade do diálogo multimodal. sistemas.

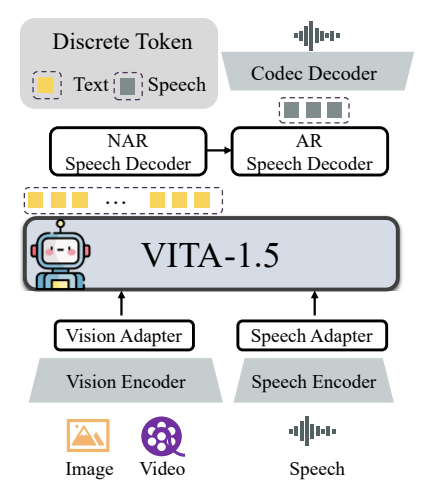

A arquitetura geral do VITA-1.5 inclui codificadores visuais e de áudio e adaptadores para conexão com modelos de linguagem grandes. A saída possui um módulo de geração de fala ponta a ponta em vez de usar um modelo TTS externo como a versão original VITA-1.0. O codificador visual usa InternViT-300M, o tamanho da imagem de entrada é 448×448 pixels e cada imagem gera 256 tokens visuais.

Para imagens de alta resolução, o VITA-1.5 adota uma estratégia de correção dinâmica para capturar detalhes locais. O vídeo é tratado como um tipo especial de entrada de múltiplas imagens, com quadros amostrados com base na duração do vídeo. O módulo de codificação de áudio consiste em múltiplas camadas convolucionais de redução da resolução e 24 blocos Transformer, com uma taxa de quadros de saída de 12,5 Hz. O adaptador de áudio consiste em múltiplas camadas convolucionais com redução de resolução de 2x. O TiCodec é usado como modelo de codec, que codifica um sinal de fala contínuo em tokens de fala discretos com uma frequência de 40 Hz e é capaz de decodificá-los de volta em um sinal de fala com uma taxa de amostragem de 24.000 Hz. Para permitir que o modelo produza tokens de fala, dois decodificadores de fala são adicionados após os tokens de texto: um decodificador de fala não autorregressivo (NAR) e um decodificador de fala autorregressivo (AR).

Os dados de treinamento do VITA-1.5 abrangem uma ampla gama de categorias, como dados de legendas e dados de perguntas e respostas, incluindo chinês e inglês. Em diferentes estágios de treinamento, subconjuntos de todo o conjunto de dados são amostrados seletivamente para atender a objetivos diferentes. A estratégia de treinamento é realizada em três etapas:

A primeira etapa: treinamento visual-linguístico, incluindo alinhamento visual, compreensão visual e ajuste visual supervisionado, visa preencher a lacuna entre visão e linguagem e permitir que o modelo compreenda o conteúdo da imagem e responda a questões visuais.

Fase 2: O ajuste da entrada de áudio, incluindo alinhamento de áudio e ajuste fino supervisionado de áudio, é projetado para permitir que o modelo entenda a entrada de áudio e interaja por meio de perguntas de voz e respostas de texto.

O terceiro estágio: ajuste de saída de áudio, incluindo treinamento de codec e treinamento de decodificador NAR + AR, é projetado para permitir que o modelo gere saída de fala e obtenha interação de voz ponta a ponta.

Os pesquisadores conduziram uma avaliação extensa em vários benchmarks para compreensão de imagem, vídeo e fala e compararam os resultados com modelos proprietários e de código aberto. Os resultados mostram que o VITA-1.5 exibe capacidades de percepção e raciocínio comparáveis às do líder MLLM em tarefas de imagem e vídeo, e alcança melhorias significativas nas capacidades de fala. Por exemplo, no benchmark de compreensão de imagem, o VITA-1.5 tem um desempenho equivalente aos modelos de código aberto de última geração e até mesmo excede alguns modelos de código fechado. Em termos de compreensão de vídeo, o VITA-1.5 tem um desempenho equivalente aos principais modelos de código aberto. Além disso, o VITA-1.5 alcançou precisão líder em tarefas ASR em chinês e inglês, superando os modelos de fala profissionais.

No geral, o VITA-1.5 integra com sucesso visão e fala por meio de uma estratégia de treinamento de três estágios cuidadosamente projetada, alcançando fortes capacidades de compreensão visual e de fala, permitindo interação eficiente de fala para fala sem depender de módulo ASR ou TTS separado. Espera-se que esta pesquisa promova o avanço de modelos de código aberto no campo da interação multimodal em tempo real.

Endereço do projeto: https://github.com/VITA-MLLM/VITA

O surgimento do VITA-1.5 marca uma nova etapa no desenvolvimento de modelos de linguagem multimodais em grande escala. Suas capacidades de geração de fala de ponta a ponta e excelente desempenho em tarefas de compreensão de imagem, vídeo e fala criarão um ambiente mais natural e suave. modelo de linguagem multimodal para o futuro Os sistemas interativos dinâmicos oferecem novas possibilidades. Este resultado de pesquisa merece atenção e espera-se que desempenhe um papel importante em aplicações práticas.