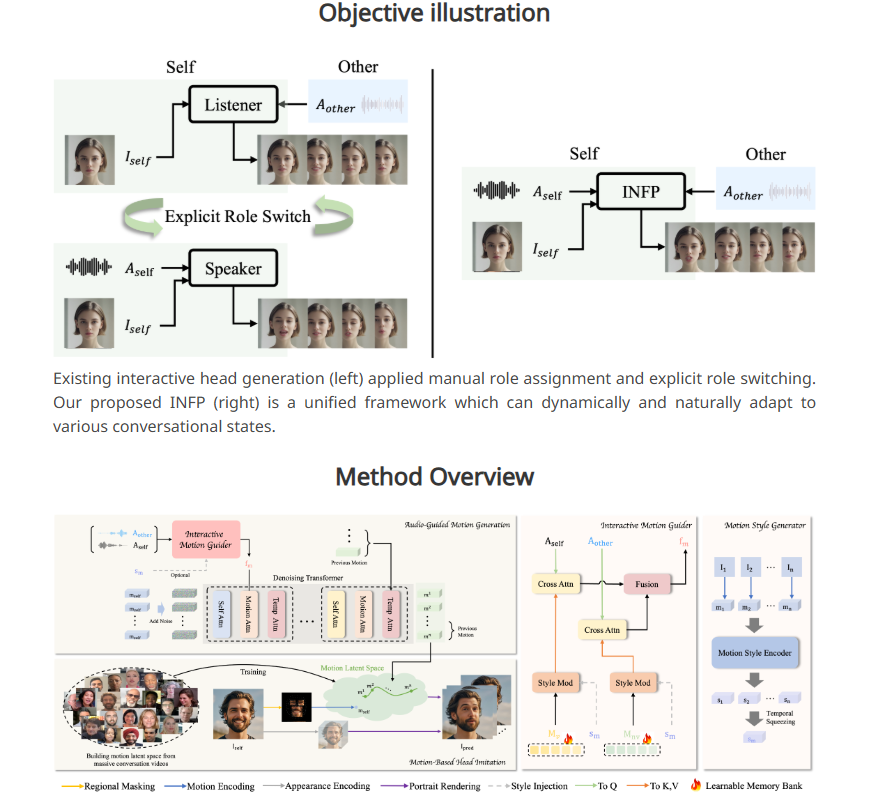

ByteDance lançou um novo sistema de IA, INFP, que permite que fotos estáticas de retratos “falem” e reajam por meio de entrada de áudio. Ao contrário da tecnologia tradicional, o INFP não precisa especificar funções manualmente. O sistema pode julgar automaticamente com base na conversa, o que melhora muito a eficiência e a conveniência. Sua tecnologia principal reside nas duas etapas de "imitação de cabeça baseada em movimento" e "geração de movimento guiada por áudio". Ao analisar expressões faciais, movimentos de cabeça e entrada de áudio em conversas, ele gera padrões de movimento naturais e suaves para gerar imagens estáticas. para a vida. Para treinar o INFP, a ByteDance também construiu um conjunto de dados DyConv contendo mais de 200 horas de vídeos de conversas reais para garantir a saída de alta qualidade do sistema.

Existem duas etapas principais no fluxo de trabalho do INFP. Na primeira etapa, chamada de “mimetismo de cabeça baseado em movimento”, o sistema extrai detalhes do vídeo analisando as expressões faciais e os movimentos da cabeça das pessoas durante as conversas. Esses dados de movimento são convertidos em um formato que pode ser usado em animações subsequentes, permitindo que as fotos correspondam ao movimento do personagem original.

A segunda etapa é a “geração de movimento guiada por áudio”, onde o sistema gera padrões de movimento naturais com base na entrada de áudio. A equipe de pesquisa desenvolveu um “guia de movimento” que analisa o áudio de ambas as partes em uma conversa para criar padrões de movimento para falar e ouvir. Um componente de IA chamado Diffusion Transformer otimiza progressivamente esses padrões, resultando em movimentos suaves e realistas que combinam perfeitamente com o conteúdo de áudio.

Para treinar efetivamente o sistema, a equipe de pesquisa também estabeleceu um conjunto de dados de diálogo chamado DyConv, que coleta mais de 200 horas de vídeos de diálogo reais. Comparado com bancos de dados de conversação existentes, como ViCo e RealTalk, o DyConv tem vantagens únicas em expressão emocional e qualidade de vídeo.

ByteDance afirma que o INFP supera as ferramentas existentes em diversas áreas importantes, particularmente na correspondência dos movimentos dos lábios com a fala, na preservação de características faciais individuais e na criação de diversos movimentos naturais. Além disso, o sistema teve um desempenho igualmente bom na geração de vídeos em que apenas o interlocutor era ouvido.

Embora o INFP atualmente suporte apenas entrada de áudio, a equipe de pesquisa está explorando a possibilidade de estender o sistema para imagens e texto. O objetivo futuro é ser capaz de criar animações realistas de todo o corpo do personagem. No entanto, considerando que este tipo de tecnologia pode ser usada para criar vídeos falsos e espalhar desinformação, a equipa de investigação planeia restringir o uso da tecnologia principal a instituições de investigação, semelhante à gestão da Microsoft do seu sistema avançado de clonagem de voz.

Esta tecnologia faz parte da estratégia mais ampla de IA da ByteDance. Contando com seus aplicativos populares TikTok e CapCut, a ByteDance possui uma ampla plataforma de aplicativos inovadores de IA.

Entrada do projeto: https://grisoon.github.io/INFP/

Destaques:

O INFP pode permitir que retratos estáticos “falem” através do áudio e determinem automaticamente a função do diálogo.

O sistema funciona em duas etapas: primeiro, extrai detalhes de movimento em conversas humanas e, segundo, converte o áudio em padrões naturais de movimento.

O conjunto de dados DyConv da ByteDance contém mais de 200 horas de vídeos de conversas de alta qualidade para ajudar a melhorar o desempenho do sistema.

O lançamento do sistema INFP demonstra a força inovadora da ByteDance no campo da inteligência artificial. O seu potencial de desenvolvimento futuro é enorme, mas os potenciais riscos éticos também precisam de ser tratados com cuidado. O avanço da tecnologia deve ser sempre orientado para os interesses sociais e garantir que ela seja utilizada em benefício da humanidade.