A mais recente estrutura de sincronização labial LatentSync lançada pela ByteDance usa o modelo de difusão latente condicional de áudio baseado em Difusão Estável para obter um efeito de sincronização labial mais preciso e eficiente. Diferente dos métodos anteriores, o LatentSync adota uma abordagem ponta a ponta para modelar diretamente a complexa relação entre áudio e visão sem exigir representação intermediária de movimento, melhorando significativamente a eficiência do processamento e a precisão da sincronização. Esta estrutura usa habilmente o Whisper para incorporação de áudio e o combina com o mecanismo TREPA para melhorar a consistência temporal, garantindo que o vídeo de saída mantenha a coerência temporal enquanto mantém a precisão da sincronização labial.

Recentemente, a ByteDance lançou uma nova estrutura de sincronização labial chamada LatentSync, que visa usar o modelo de difusão latente de condição de áudio para obter uma sincronização labial mais precisa. A estrutura é baseada em Difusão Estável e é otimizada para consistência temporal.

Ao contrário dos métodos anteriores baseados na difusão espacial de pixels ou geração em dois estágios, o LatentSync adota uma abordagem ponta a ponta sem a necessidade de representação intermediária de movimento e pode modelar diretamente relações audiovisuais complexas.

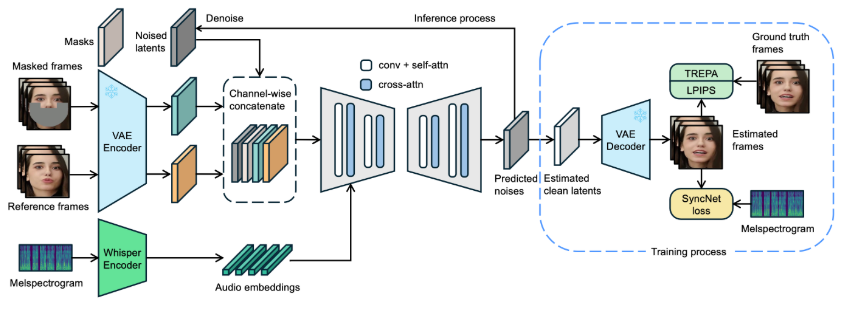

Na estrutura do LatentSync, o Whisper é usado pela primeira vez para converter espectrogramas de áudio em incorporações de áudio e integrado ao modelo U-Net por meio de camadas de atenção cruzada. A estrutura realiza concatenação em nível de canal de quadros de referência e quadros de máscara com variáveis latentes de ruído como entrada para U-Net.

Durante o treinamento, uma abordagem de uma etapa é usada para estimar variáveis latentes limpas a partir do ruído de predição e, em seguida, decodificar para gerar quadros limpos. Ao mesmo tempo, o modelo introduz o mecanismo Temporal REPresentation Alignment (TREPA) para melhorar a consistência temporal e garantir que o vídeo gerado possa manter a coerência temporal enquanto mantém a precisão da sincronização labial.

Para demonstrar a eficácia desta tecnologia, o projeto disponibiliza uma série de vídeos de amostra, mostrando o vídeo original e o vídeo sincronizado labial. Através de exemplos, os usuários podem sentir intuitivamente o progresso significativo do LatentSync na sincronização labial de vídeo.

Vídeo original:

Vídeo de saída:

Além disso, o projeto também planeja abrir o código de inferência e os pontos de verificação para facilitar o treinamento e o teste dos usuários. Para usuários que desejam tentar a inferência, basta baixar os arquivos de peso do modelo necessários e você estará pronto para começar. Um processo completo de processamento de dados também foi projetado, abrangendo todas as etapas, desde o processamento do arquivo de vídeo até o alinhamento facial, garantindo que os usuários possam começar facilmente.

Entrada do projeto modelo: https://github.com/bytedance/LatentSync

Destaques:

LatentSync é uma estrutura de sincronização ponta a porta baseada no modelo de difusão latente condicional de áudio sem a necessidade de representações de movimento intermediárias.

A estrutura utiliza o Whisper para converter espectrogramas de áudio em incorporações, o que aumenta a precisão e a consistência temporal do modelo durante a sincronização labial.

O projeto fornece uma série de vídeos de amostra e planeja abrir códigos relevantes e processos de processamento de dados para facilitar o uso e o treinamento do usuário.

O código aberto e a facilidade de uso do LatentSync promoverão o desenvolvimento e a aplicação da tecnologia de sincronização labial, trazendo novas possibilidades para as áreas de edição de vídeo e criação de conteúdo. Aguardamos ansiosamente as atualizações subsequentes deste projeto, que trarão mais surpresas.