Nos últimos anos, tem havido uma procura crescente por modelos leves de IA, especialmente em plataformas com recursos limitados, como dispositivos móveis e computadores pessoais. Como reduzir o tamanho do modelo e o custo computacional e ao mesmo tempo garantir o desempenho tornou-se uma importante direção de pesquisa. Este artigo apresentará o SmolVLM lançado recentemente pela Hugging Face, um modelo de linguagem visual de parâmetro 2B projetado especificamente para inferência no lado do dispositivo. Ele fez avanços significativos em velocidade e eficiência e fornece soluções para a aplicação de tarefas de linguagem visual em recursos de baixo custo. dispositivos. Novas possibilidades.

Nos últimos anos, tem havido uma procura crescente pela aplicação de modelos de aprendizagem automática em tarefas de visão e linguagem, mas a maioria dos modelos requer enormes recursos computacionais e não pode funcionar eficientemente em dispositivos pessoais. Especialmente os dispositivos pequenos, como laptops, GPUs de consumo e dispositivos móveis, enfrentam enormes desafios ao processar tarefas de linguagem visual.

Tomando como exemplo o Qwen2-VL, embora tenha excelente desempenho, possui altos requisitos de hardware, o que limita sua usabilidade em aplicações em tempo real. Portanto, desenvolver modelos leves para rodar com menos recursos tornou-se uma necessidade importante.

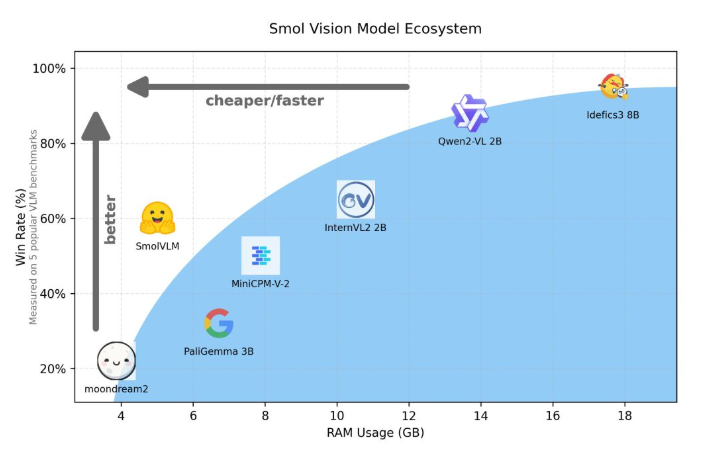

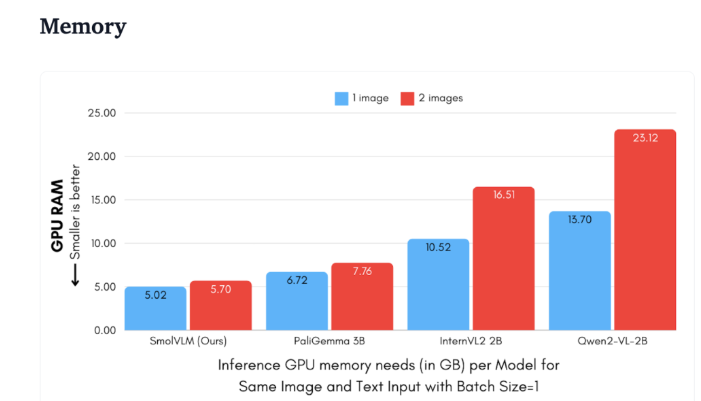

Hugging Face lançou recentemente o SmolVLM, um modelo de linguagem visual com parâmetros 2B especialmente projetado para raciocínio do lado do dispositivo. SmolVLM supera outros modelos semelhantes em termos de uso de memória GPU e velocidade de geração de token. Sua principal característica é a capacidade de funcionar com eficiência em dispositivos menores, como laptops ou GPUs de consumo, sem sacrificar o desempenho. O SmolVLM encontra um equilíbrio ideal entre desempenho e eficiência, resolvendo problemas que eram difíceis de superar em modelos anteriores semelhantes.

Comparado com Qwen2-VL2B, o SmolVLM gera tokens 7,5 a 16 vezes mais rápido, graças à sua arquitetura otimizada, que torna possível uma inferência leve. Essa eficiência não só traz benefícios práticos para os usuários finais, mas também melhora muito a experiência do usuário.

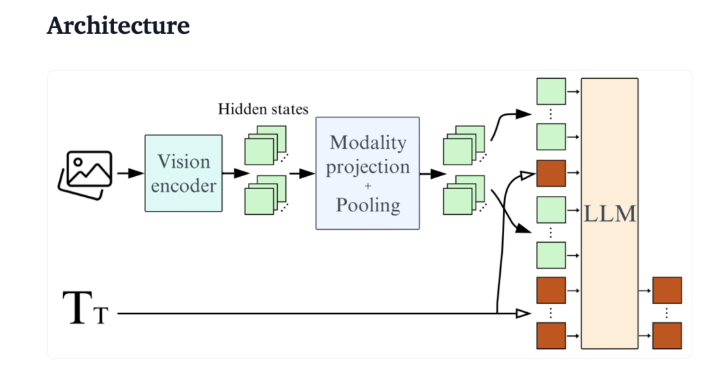

Do ponto de vista técnico, o SmolVLM possui uma arquitetura otimizada que suporta inferência eficiente no lado do dispositivo. Os usuários podem até mesmo fazer ajustes finos no Google Colab, reduzindo bastante o limite para experimentação e desenvolvimento.

Devido ao seu pequeno consumo de memória, o SmolVLM é capaz de funcionar sem problemas em dispositivos que anteriormente não conseguiam hospedar modelos semelhantes. Ao testar um vídeo de 50 quadros do YouTube, o SmolVLM teve um bom desempenho, marcando 27,14%, e superou os dois modelos que mais consomem recursos em termos de consumo de recursos, demonstrando sua forte adaptabilidade e flexibilidade.

SmolVLM é um marco importante no campo de modelos de linguagem visual. Seu lançamento permite que tarefas complexas de linguagem visual sejam executadas em dispositivos do dia a dia, preenchendo uma lacuna importante nas ferramentas atuais de IA.

O SmolVLM não apenas se destaca em velocidade e eficiência, mas também fornece aos desenvolvedores e pesquisadores uma ferramenta poderosa para facilitar o processamento de linguagem visual sem despesas caras de hardware. À medida que a tecnologia de IA continua a se tornar mais popular, modelos como o SmolVLM tornarão os poderosos recursos de aprendizado de máquina mais acessíveis.

demonstração: https://huggingface.co/spaces/HuggingFaceTB/SmolVLM

https://huggingface.co/spaces/HuggingFaceTB/SmolVLM

Destaque:

SmolVLM é um modelo de linguagem visual de parâmetros 2B lançado pela Hugging Face, projetado especificamente para raciocínio do lado do dispositivo. Ele funciona com eficiência e não requer hardware de última geração.

Sua velocidade de geração de tokens é de 7,5 a 16 vezes maior que a de modelos semelhantes, melhorando muito a experiência do usuário e a eficiência do aplicativo.

No teste, o SmolVLM demonstrou forte adaptabilidade e foi capaz de obter boas pontuações mesmo sem treinamento com dados de vídeo.

O surgimento do SmolVLM marca um avanço importante no desenvolvimento leve de modelos de linguagem visual. Ele não apenas melhora a experiência do usuário, mas também fornece aos desenvolvedores e pesquisadores ferramentas mais convenientes. No futuro, modelos eficientes e leves como o SmolVLM desempenharão um papel em mais cenários e promoverão uma aplicação mais ampla da tecnologia de inteligência artificial.