Ai2, uma organização sem fins lucrativos de pesquisa em inteligência artificial, lançou seu novo modelo de linguagem aberta da série OLMo2. Este é o produto de segunda geração da série OLMo. Seus recursos de código-fonte totalmente aberto representam o mais recente progresso no campo da IA de código-fonte aberto. OLMo2 adere estritamente à definição da Iniciativa de Código Aberto, e todos os dados, ferramentas e códigos de treinamento estão disponíveis publicamente, o que contrasta fortemente com outros modelos de linguagem que afirmam ser "abertos", mas não são completamente de código aberto. A ação da Ai2 visa promover a inovação e o desenvolvimento da comunidade de código aberto e fornecer aos desenvolvedores globais suporte técnico poderoso e plataforma de compartilhamento de recursos.

Ao contrário de outros modelos de linguagem "aberta" atualmente no mercado, como a série Llama da Meta, o OLMo2 atende à definição estrita da Open Source Initiative, o que significa que os dados de treinamento, ferramentas e códigos utilizados para o seu desenvolvimento são públicos e acessíveis a qualquer pessoa e. usar. Conforme definido pela Open Source Initiative, o OLMo2 atende aos requisitos da organização para um padrão de “IA de código aberto”, que foi finalizado em outubro deste ano.

Ai2 mencionou em seu blog que durante o processo de desenvolvimento do OLMo2, todos os dados de treinamento, códigos, planos de treinamento, métodos de avaliação e pontos de verificação intermediários foram totalmente abertos, visando promover inovação e descoberta na comunidade de código aberto por meio de recursos compartilhados. “Ao compartilhar abertamente nossos dados, soluções e descobertas, esperamos fornecer à comunidade de código aberto os recursos para descobrir novos métodos e tecnologias inovadoras”, disse Ai2.

A série OLMo2 inclui duas versões: uma é OLMo7B com 7 bilhões de parâmetros e a outra é OLMo13B com 13 bilhões de parâmetros. O número de parâmetros afeta diretamente o desempenho do modelo, e versões com mais parâmetros geralmente podem lidar com tarefas mais complexas. OLMo2 teve um bom desempenho em tarefas de texto comuns, sendo capaz de completar tarefas como responder perguntas, resumir documentos e escrever código.

Para treinar o OLMo2, o Ai2 usou um conjunto de dados contendo cinco trilhões de tokens. Token é a menor unidade no modelo de linguagem. 1 milhão de tokens equivale aproximadamente a 750.000 palavras. Os dados de treinamento incluem conteúdo de sites de alta qualidade, artigos acadêmicos, fóruns de discussão de perguntas e respostas e livros de exercícios de matemática sintética, e são cuidadosamente selecionados para garantir a eficiência e a precisão do modelo.

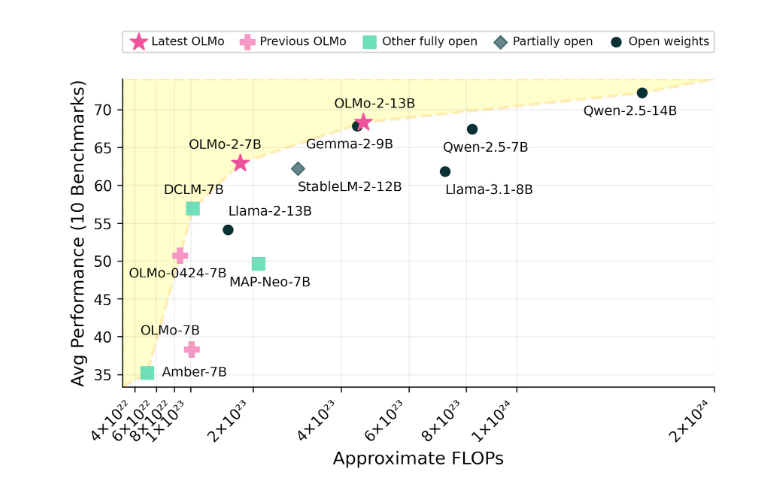

Ai2 está confiante no desempenho do OLMo2, alegando que ele competiu em desempenho com modelos de código aberto, como o Llama3.1 da Meta. Ai2 destacou que o desempenho do OLMo27B superou até mesmo o Llama3.18B e se tornou um dos modelos de linguagem totalmente aberta mais fortes atualmente. Todos os modelos OLMo2 e seus componentes podem ser baixados gratuitamente através do site oficial do Ai2 e seguem a licença Apache2.0, o que significa que esses modelos podem ser utilizados não apenas para pesquisa, mas também para aplicações comerciais.

Os recursos de código aberto do OLMo2 e seu excelente desempenho trouxeram novas possibilidades para o desenvolvimento do campo da inteligência artificial e injetaram nova vitalidade na comunidade de código aberto. Vale a pena olhar com expectativa para o seu desenvolvimento e aplicações futuras.