O modelo de inferência Marco-o1 lançado recentemente pela Alibaba International AI Team mostra um potencial significativo na resolução de problemas abertos. Rompe as limitações dos modelos tradicionais que se limitam a áreas de resposta padrão e está empenhada em explorar aplicações em áreas que são difíceis de quantificar e que carecem de recompensas claras. A principal característica deste modelo reside em seu método de treinamento exclusivo e estratégia de expansão do espaço de solução, que lhe permite lidar com tarefas mais complexas e mais difíceis, como tradução de frases longas e difíceis, e demonstra forte capacidade de raciocínio para desmantelar problemas gradualmente e, finalmente, Dê respostas precisas. O código aberto do Marco-o1 também fornece recursos valiosos para a comunidade de pesquisa em IA.

A equipe internacional de IA do Alibaba lançou recentemente um novo modelo de raciocínio chamado Marco-o1, que presta atenção especial à solução de problemas abertos e não se limita a áreas temáticas com respostas padrão, como programação e matemática. A equipa de investigação está empenhada em explorar se tais modelos podem ser eficazmente generalizados para áreas que são difíceis de quantificar e que carecem de recompensas claras.

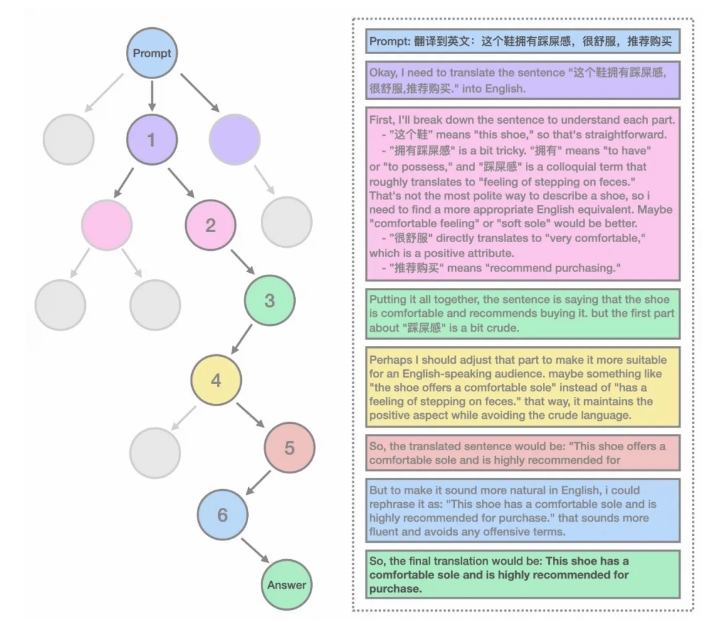

As características do modelo Marco-o1 incluem o uso de dados CoT ultralongos para ajuste fino, o uso de MCTS para expandir o espaço de soluções e a expansão refinada do espaço de soluções. O modelo usa self-play+MCTS para construir um lote de dados CoT ultralongos com a capacidade de refletir e corrigir, e é treinado junto com outros dados de código aberto. Além disso, a equipe de pesquisa também definiu uma mini-etapa para expandir ainda mais o espaço de soluções do modelo e orientar o modelo para produzir melhores respostas.

Na tarefa de tradução, o modelo Marco-o1 demonstrou sua capacidade de lidar com a tradução de frases longas e difíceis. Esta é a primeira vez que a extensão do tempo de inferência foi aplicada a tarefas de tradução automática. A equipe de pesquisa abriu o código-fonte de alguns dados CoT e dos melhores modelos atuais, e planeja abrir o código-fonte de mais dados e modelos no futuro.

O modelo pensará profundamente sobre a resposta ao raciocinar. Por exemplo, ao gerar o número de 'r's na palavra 'morango', o modelo irá desmontar gradualmente cada letra da palavra e compará-la, e finalmente produzirá o resultado corretamente. No campo da tradução automática, o modelo identifica corretamente os pontos difíceis por meio de links de inferência e os traduz palavra por palavra, melhorando a precisão geral da tradução.

A equipe de pesquisa também tentou isso em outras áreas, comprovando a capacidade do modelo de resolver outros problemas gerais do mundo real. A estrutura geral do Marco-o1 usa auto-reprodução + MCTS para construir um lote de dados CoT ultralongos com a capacidade de refletir e corrigir, e treiná-los junto com outros dados de código aberto. A equipe de pesquisa também incorporou alguns conjuntos de dados de conformidade de instruções da família MarcoPolo para melhorar as capacidades de conformidade de instruções do modelo.

Em termos de uso, a equipe de pesquisa fornece código de inferência e código de ajuste fino. Os usuários podem facilmente carregar o modelo e o tokenizador e começar a conversar ou ajustar o modelo. Além disso, o modelo também pode ser executado diretamente na versão GGUF no ModelScope, proporcionando uma maneira mais rápida de experimentá-lo.

O lançamento do modelo Marco-o1 marca um passo importante dado pela equipe internacional de IA do Alibaba na área de modelos de inferência, fornecendo novas ideias e ferramentas para resolver problemas abertos.

Escopo do modelo:

https://modelscope.cn/models/AIDC-AI/Marco-o1

Arxiv:

https://arxiv.org/abs/2411.14405

GitHub:

https://github.com/AIDC-AI/Marco-o1

Abraçando o rosto:

https://huggingface.co/AIDC-AI/Marco-o1

Em suma, o código aberto do modelo Marco-o1 traz novas possibilidades para a investigação e aplicações de IA, e vale a pena esperar pelos seus avanços na resolução de problemas abertos. Links relacionados facilitam aos usuários uma melhor compreensão e uso do modelo.