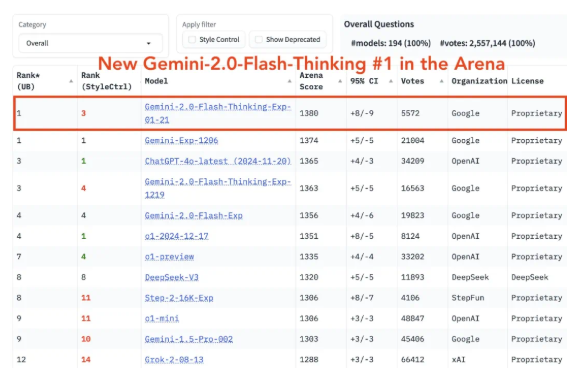

O Google lançou uma versão aprimorada do modelo de inferência Gemini 2.0 Flash Thinking em 22 de janeiro de 2025, que recuperou o primeiro lugar no Chatbot Arena. O núcleo desta atualização é melhorar significativamente as capacidades de processamento de contexto longo e suportar a entrada de até 1 milhão de tokens, permitindo uma análise mais aprofundada de textos longos. Gemini 2.0 Flash Thinking não apenas mantém as vantagens da versão original, mas também adiciona capacidades aprimoradas de raciocínio baseadas no pensamento e se concentra em melhorar a confiabilidade e consistência do modelo, reduzindo a contradição entre as ideias geradas pelo modelo e a resposta final .

O Google lançou oficialmente uma versão aprimorada de seu modelo de inferência Gemini2.0 Flash Thinking em 22 de janeiro de 2025, mais uma vez retomando o primeiro lugar no Chatbot Arena. A atualização desta versão concentra-se principalmente na capacidade de processamento de contexto longo, que pode suportar a entrada de até 1 milhão de tokens, fornecendo aos usuários recursos de análise mais aprofundados ao processar textos longos.

Jeff Dean, chefe do Google AI, disse na conferência de imprensa que esta atualização experimental visa melhorar a confiabilidade do modelo e reduzir a contradição entre as ideias geradas pelo modelo e a resposta final. Gemini2.0 Flash Thinking não apenas continua as vantagens da versão original, mas também adiciona uma nova função para aprimorar as capacidades de raciocínio baseadas em pensamentos, que funcionam bem.

No nível técnico, o Gemini2.0 Flash Thinking alcançou dois grandes avanços: primeiro, ele pode lidar com contextos longos de até 1 milhão de tokens, o que é crucial para conversas complexas e processos de raciocínio em várias rodadas; segundo, o modelo tem um desempenho significativo por conta própria; -correção , capaz de manter a coerência nas conversas e aplicar com flexibilidade as informações previamente acumuladas. Isso significa que os usuários podem experimentar um processo de conversação mais natural e consistente ao interagir com o modelo.

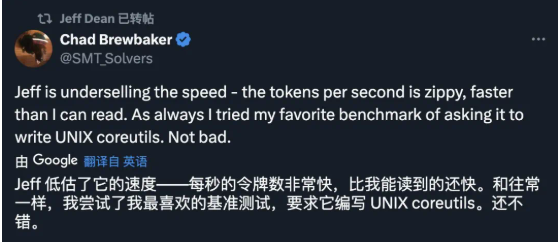

Em uma demonstração, Jeff Dean mostrou de forma impressionante como o modelo resolve problemas de física e explica o raciocínio. E os participantes relataram que o modelo mais recente foi ainda mais rápido na experiência do mundo real do que na demonstração.

Além dos recursos de processamento de contexto longo, o Gemini2.0 Flash Thinking também melhorou significativamente seu teste de habilidade matemática, teste de habilidade científica e capacidade de raciocínio multimodal, especialmente em matemática, que aumentou 54%. Esta série de excelentes desempenhos deixa as pessoas cheias de expectativas para o futuro deste modelo.

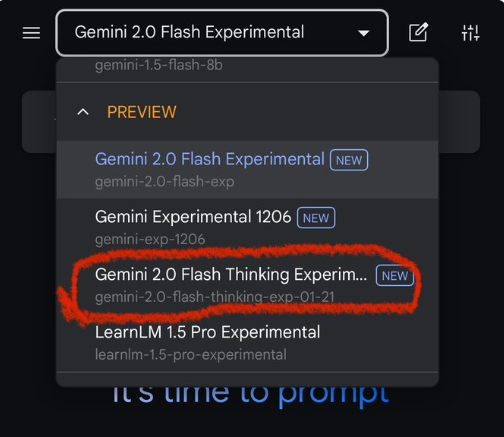

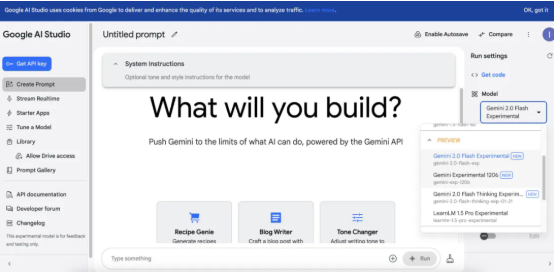

Ao entrar na interface interativa, os usuários podem obter funções de modelo abrangentes na plataforma "Google AI Studio", incluindo a criação de palavras de alerta, conversas em tempo real e desenvolvimento de aplicativos. Embora as funções da interface atual estejam relativamente dispersas, o Google planeja fornecer relatórios técnicos mais detalhados e orientações ao usuário após o lançamento oficial do modelo para melhorar a experiência do usuário.

Olhando para o futuro, a equipe de desenvolvimento do Google está explorando ativamente as capacidades de processamento de dados 3D, demonstrando a sua firme crença na inovação contínua. É previsível que o próximo avanço do Google no campo da IA esteja ao virar da esquina e mereça a nossa atenção contínua.

Link de teste: https://aistudio.google.com/prompts/new_chat

Em suma, a atualização do Gemini 2.0 Flash Thinking melhorou significativamente o processamento de textos longos, as capacidades de raciocínio e a confiabilidade, demonstrando os contínuos avanços tecnológicos do Google na área de grandes modelos de linguagem. Vale a pena aguardar seu excelente desempenho e direção de desenvolvimento futuro, e também traz novas possibilidades para o desenvolvimento futuro do campo de IA.