DeepSeek lançou seu primeiro modelo de inferência DeepSeek-R1 baseado em treinamento de aprendizagem por reforço em 20 de janeiro de 2025. O modelo mostrou desempenho comparável ou até melhor que OpenAI-o1-1217 em vários testes de benchmark. DeepSeek-R1 não é treinado diretamente, mas por meio de treinamento em vários estágios e dados de inicialização a frio. Baseado no modelo DeepSeek-V3-Base, ele supera os problemas causados pelo uso apenas do modelo de treinamento de aprendizagem por reforço (DeepSeek-R1-Zero). Problemas como baixa legibilidade e linguagens mistas resultaram em melhorias significativas de desempenho. O modelo é de código aberto e oferece preços competitivos para acesso à API, proporcionando aos usuários uma opção mais conveniente e econômica.

Em 20 de janeiro de 2025, DeepSeek anunciou o lançamento de seu primeiro modelo de inferência DeepSeek-R1 treinado por meio de aprendizagem por reforço (RL), que alcançou desempenho comparável ao OpenAI-o1-1217 em vários benchmarks de inferência. DeepSeek-R1 é baseado no modelo DeepSeek-V3-Base e usa treinamento em vários estágios e dados de inicialização a frio para melhorar os recursos de inferência.

Os pesquisadores do DeepSeek desenvolveram primeiro o DeepSeek-R1-Zero, um modelo treinado inteiramente por meio de aprendizado por reforço em larga escala, sem quaisquer etapas preparatórias para ajuste fino supervisionado. DeepSeek-R1-Zero demonstrou excelente desempenho em benchmarks de inferência. Por exemplo, no exame AIME2024, sua pontuação pass@1 aumentou de 15,6% para 71,0%. No entanto, o DeepSeek-R1-Zero também apresenta alguns problemas, como baixa legibilidade e linguagens mistas.

Para resolver esses problemas e melhorar ainda mais o desempenho da inferência, a equipe do DeepSeek desenvolveu o DeepSeek-R1. DeepSeek-R1 apresenta treinamento em vários estágios e dados de inicialização a frio antes do aprendizado por reforço. Especificamente, os pesquisadores primeiro coletaram milhares de dados de inicialização a frio para ajustar o modelo DeepSeek-V3-Base. Em seguida, eles realizaram aprendizado por reforço orientado por inferência enquanto treinavam o DeepSeek-R1-Zero. Quando o processo de aprendizagem por reforço estava próximo da convergência, eles criaram novos dados supervisionados de ajuste fino por amostragem de rejeição de pontos de verificação de aprendizagem por reforço, combinados com dados supervisionados do DeepSeek-V3 em áreas como escrita, resposta a fatos e autoconsciência, e então treinados novamente Modelo DeepSeek-V3-Base. Finalmente, o aprendizado por reforço adicional é realizado nos pontos de verificação ajustados usando dicas de todos os cenários.

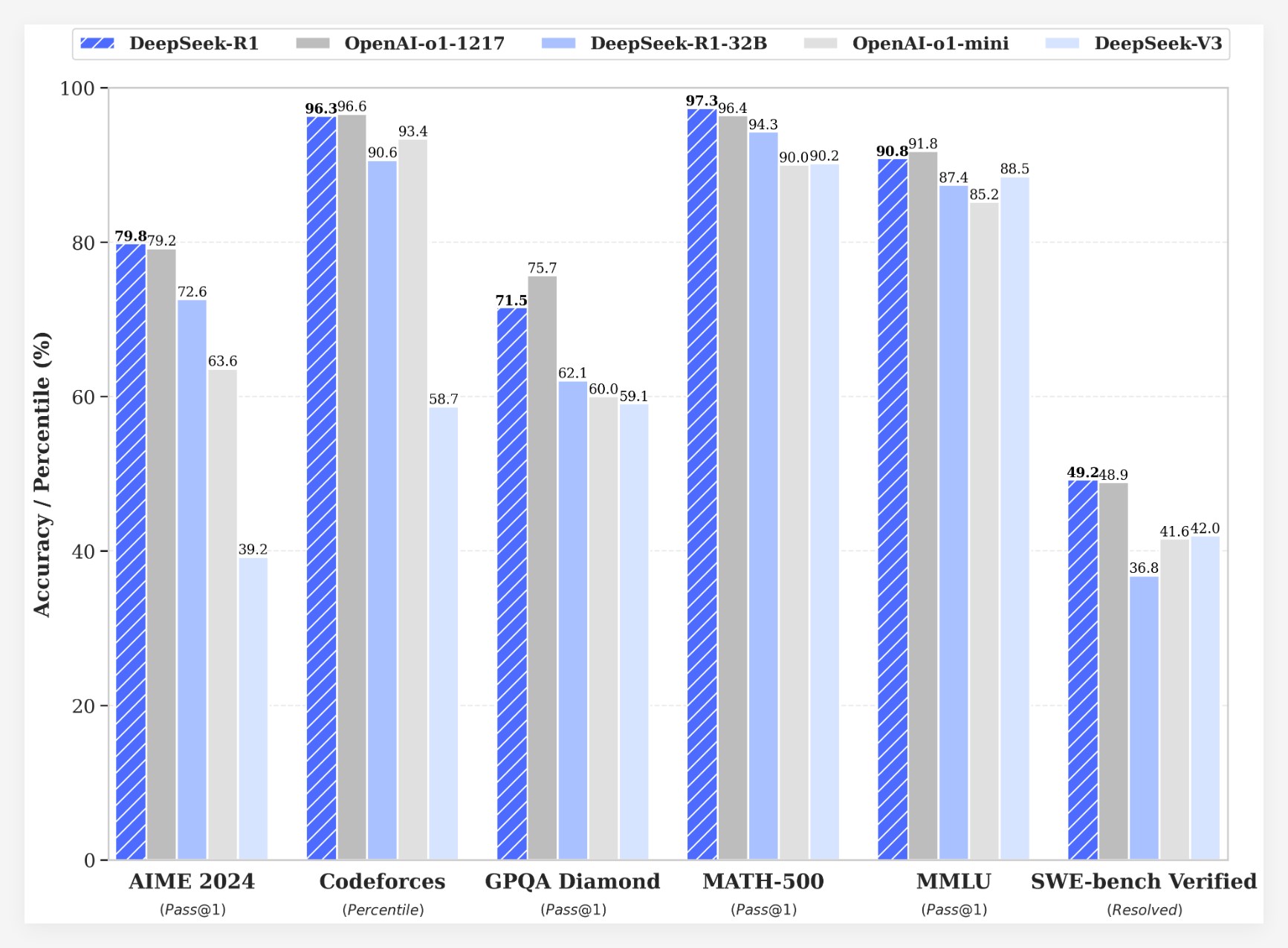

DeepSeek-R1 alcança resultados impressionantes em vários benchmarks:

•No exame AIME2024, a pontuação pass@1 do DeepSeek-R1 atingiu 79,8%, um pouco superior à do OpenAI-o1-1217.

•No exame MATH-500, a pontuação pass@1 do DeepSeek-R1 atingiu 97,3%, que é a mesma do OpenAI-o1-1217.

•Na tarefa de competição de código, DeepSeek-R1 alcançou uma classificação Elo de 2029 no Codeforces, ultrapassando 96,3% dos participantes humanos.

•Em benchmarks de conhecimento como MMLU, MMLU-Pro e GPQA Diamond, DeepSeek-R1 pontua 90,8%, 84,0% e 71,5% respectivamente, significativamente melhor que DeepSeek-V3.

•DeepSeek-R1 também funciona bem em outras tarefas, como redação criativa, perguntas e respostas gerais, edição, resumo, etc.

Além disso, o DeepSeek também explora a destilação dos recursos de inferência do DeepSeek-R1 em modelos menores. Verificou-se que a destilação diretamente do DeepSeek-R1 teve um desempenho melhor do que a aplicação de aprendizagem por reforço em um modelo pequeno. Isto sugere que os padrões de inferência descobertos por grandes modelos de base são críticos para melhorar as capacidades de inferência. DeepSeek possui código aberto DeepSeek-R1-Zero, DeepSeek-R1 e seis modelos densos (1,5B, 7B, 8B, 14B, 32B, 70B) destilados de DeepSeek-R1 baseado em Qwen e Llama. O lançamento do DeepSeek-R1 marca um progresso significativo na aprendizagem por reforço na melhoria das capacidades de raciocínio de grandes modelos de linguagem.

vantagem de custoEm termos de custo, DeepSeek-R1 oferece uma estratégia de preços muito competitiva. Seu preço de acesso à API é de US$ 0,14 (acerto de cache) e US$ 0,55 (acerto de cache) por milhão de tokens de entrada e US$ 2,19 por milhão de tokens de saída. Esta estratégia de preços é mais atraente do que outros produtos similares e foi descrita como uma “virada de jogo” pelos usuários. O site oficial e a API já estão online! Visite https://chat.deepseek.com para experimentar o DeepThink!

O lançamento do DeepSeek-R1 gerou discussões acaloradas na comunidade. Muitos usuários apreciam a natureza de código aberto e as vantagens de custo do modelo, acreditando que ele oferece aos desenvolvedores mais opções e liberdade. No entanto, alguns usuários levantaram questões sobre o tamanho da janela de contexto do modelo e esperam que versões futuras possam ser otimizadas ainda mais.

A equipe DeepSeek afirmou que continuará trabalhando para melhorar o desempenho e a experiência do usuário do modelo, e planeja lançar mais recursos no futuro, incluindo análise avançada de dados, para atender às expectativas dos usuários em relação à AGI (Inteligência Geral Artificial).

O lançamento do DeepSeek-R1 não apenas demonstra o grande potencial do aprendizado por reforço na melhoria das capacidades de raciocínio de grandes modelos de linguagem, mas também traz novos rumos e possibilidades para o desenvolvimento do campo de IA. Seus recursos de código aberto e estratégia de preços competitivos promoverão ainda mais a popularização e aplicação da tecnologia de IA.