A Universidade de Zhejiang e a Alibaba Damo Academy lançaram conjuntamente uma pesquisa inovadora: usar vídeos de ensino para construir um conjunto de dados de livros didáticos multimodais de alta qualidade. Esta pesquisa visa resolver os problemas de baixa densidade de conhecimento e fraca correlação imagem-texto dos dados de pré-treinamento de modelos de linguagem de grande escala (VLMs) existentes, fornecer melhores materiais de treinamento para VLMs e inovar no uso de recursos educacionais. A equipe de pesquisa coletou e processou vídeos didáticos massivos e, finalmente, construiu um conjunto de dados de alta qualidade abrangendo múltiplas disciplinas com uma duração total de mais de 22.000 horas, proporcionando novas possibilidades para a aplicação da inteligência artificial no campo da educação.

Recentemente, a Universidade de Zhejiang e a Academia Alibaba Damo lançaram em conjunto uma pesquisa atraente destinada a criar livros didáticos multimodais de alta qualidade por meio de vídeos didáticos. Este resultado de investigação inovador não só fornece novas ideias para a formação de modelos linguísticos de grande escala (VLMs), mas também pode mudar a forma como os recursos educativos são utilizados.

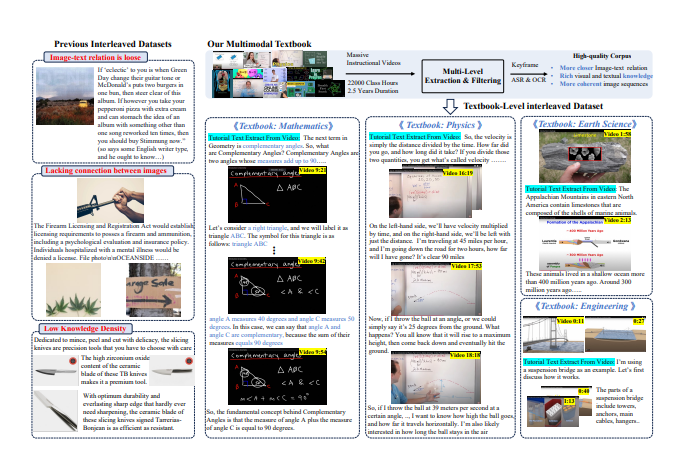

Com o rápido desenvolvimento da tecnologia de inteligência artificial, o corpus de pré-treinamento dos VLMs depende principalmente de dados de imagem-texto e de corpus entrelaçados de imagem-texto. No entanto, a maior parte dos dados atuais provém de páginas web, a correlação entre texto e imagens é fraca e a densidade de conhecimento é relativamente baixa, tornando-o incapaz de suportar eficazmente o raciocínio visual complexo.

Para enfrentar esse desafio, a equipe de pesquisa decidiu extrair um corpus de conhecimento de alta qualidade do grande número de vídeos didáticos na Internet. Eles coletaram mais de 159 mil vídeos didáticos e, após filtragem e processamento cuidadosos, finalmente retiveram 75 mil vídeos de alta qualidade, abrangendo diversos assuntos como matemática, física, química, etc., com uma duração total de mais de 22 mil horas.

Os pesquisadores projetaram um pipeline complexo de processamento de “vídeo para livro didático”. Primeiro, a tecnologia de reconhecimento automático de fala (ASR) é usada para transcrever o conteúdo explicativo do vídeo em texto e, em seguida, por meio de análise de imagem e correspondência de texto, os clipes que são altamente relevantes para os pontos de conhecimento são exibidos. Finalmente, esses quadros-chave processados, texto OCR e texto transcrito são intercalados e organizados para formar um livro multimodal com conteúdo rico e estrutura rigorosa.

Os resultados preliminares deste estudo mostram que, em comparação com conjuntos de dados anteriores centrados na web, o conjunto de dados de livros didáticos recém-gerado melhorou significativamente a densidade do conhecimento e a correlação de imagens, fornecendo uma base mais sólida para a aprendizagem de VLMs. Além disso, a investigação atraiu a atenção generalizada da comunidade académica, e os conjuntos de dados relevantes subiram rapidamente para o topo da lista popular da plataforma Hugging Face, com mais de 7.000 downloads em apenas duas semanas.

Através desta tentativa inovadora, os investigadores esperam não só promover o desenvolvimento de VLMs, mas também abrir novas possibilidades na integração e aplicação de recursos educativos.

Endereço do artigo: https://arxiv.org/pdf/2501.00958

O resultado desta investigação não é apenas de grande importância para o campo da inteligência artificial, mas também fornece uma nova direcção para a futura reforma do modelo educacional, indicando as amplas perspectivas de aplicação da tecnologia de inteligência artificial no campo da educação. O código aberto deste conjunto de dados também fornece recursos valiosos para investigadores de todo o mundo e promove a cooperação e o intercâmbio na comunidade académica.