Os modelos de linguagem visual (VLMs) desempenham um papel fundamental em tarefas multimodais, mas sofrem de deficiências significativas na compreensão da negação. Os modelos existentes muitas vezes têm dificuldade em distinguir entre sentenças positivas e negativas, o que é particularmente preocupante em aplicações que requerem compreensão semântica precisa, como diagnóstico médico e monitoramento de segurança. A causa raiz é um viés nos dados de pré-treinamento que faz com que o modelo confunda afirmações negativas com afirmações positivas. Este artigo apresentará um novo framework chamado NegBench, que visa resolver o problema da capacidade insuficiente dos VLMs para compreender a negação.

Os modelos de linguagem visual (VLMs) desempenham um papel crucial em tarefas multimodais, como recuperação de imagens, descrição de imagens e diagnóstico médico. O objetivo desses modelos é alinhar dados visuais com dados linguísticos para permitir um processamento de informações mais eficiente. No entanto, os VLMs atuais ainda enfrentam desafios significativos na compreensão da negação.

A negação é crucial em muitas aplicações, como na distinção entre uma “sala sem janelas” e uma “sala com janelas”. Apesar do progresso significativo nos VLMs, o desempenho dos modelos existentes cai significativamente quando se trata de declarações negativas. Esta limitação é particularmente importante em áreas de alto risco, como a vigilância de segurança e os cuidados de saúde.

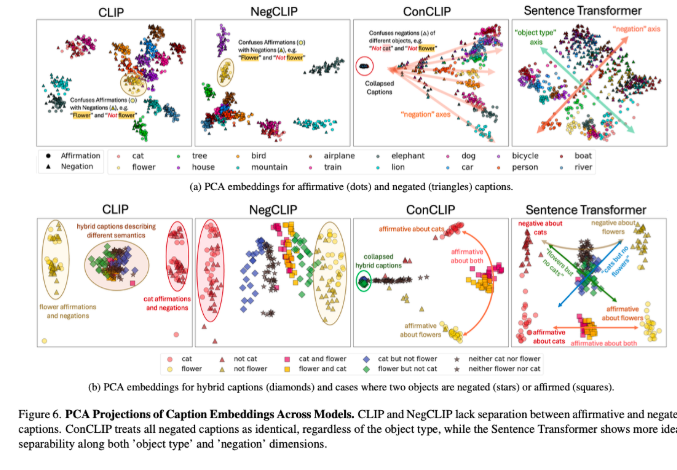

Os VLMs existentes, como o CLIP, empregam um espaço de incorporação compartilhado para alinhar representações visuais e textuais. Embora esses modelos tenham um bom desempenho em tarefas como recuperação intermodal e legendagem de imagens, eles falham ao lidar com sentenças negativas. A raiz deste problema é um viés nos dados de pré-treinamento, que consistem principalmente em exemplos positivos, fazendo com que o modelo trate afirmações negativas e positivas como sinônimos. Portanto, os benchmarks existentes, como CREPE e CC-Neg, empregam exemplos de modelos simples que não podem refletir verdadeiramente a riqueza e a profundidade da negação na linguagem natural. Isso faz com que os VLMs enfrentem enormes desafios ao executar aplicações precisas de compreensão de linguagem, como consultar condições complexas em bancos de dados de imagens médicas.

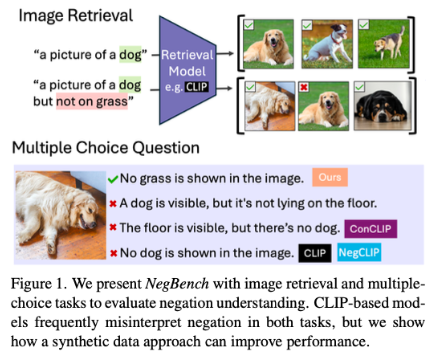

Para resolver essas questões, pesquisadores do MIT, Google DeepMind e da Universidade de Oxford propuseram a estrutura NegBench para avaliar e melhorar a capacidade dos VLMs de compreender a negação. O framework avalia duas tarefas básicas: Recuperação e Negação (Retrieval-Neg), que testa a capacidade do modelo de recuperar imagens com base em descrições positivas e negativas e Questões de Múltipla Escolha e Negação (MCQ-Neg), que avalia o desempenho do modelo em sutis; entendimento. O NegBench usa grandes conjuntos de dados sintéticos, como CC12M-NegCap e CC12M-NegMCQ, contendo milhões de títulos que cobrem cenários negativos ricos para melhorar o treinamento e avaliação do modelo.

Ao combinar conjuntos de dados reais e sintéticos, o NegBench supera efetivamente as limitações dos modelos existentes e melhora significativamente o desempenho e as capacidades de generalização do modelo. O modelo ajustado apresentou melhorias significativas nas tarefas de recuperação e compreensão, especialmente ao lidar com consultas negativas, onde a recuperação do modelo aumentou 10%. Em tarefas de múltipla escolha, a precisão melhorou em até 40%, mostrando uma capacidade bastante aprimorada de distinguir entre manchetes positivas e negativas sutis.

A proposta do NegBench preenche a lacuna fundamental dos VLMs na compreensão da negação e abre caminho para a construção de sistemas de inteligência artificial mais poderosos, o que é especialmente importante em campos-chave como diagnóstico médico e recuperação de conteúdo semântico.

Artigo: https://arxiv.org/abs/2501.09425

Código: https://github.com/m1k2zoo/negbench

Destaque:

Os pesquisadores revelam que as deficiências dos modelos de linguagem visual na compreensão da negação decorrem principalmente de preconceitos nos dados de treinamento.

A estrutura NegBench melhora significativamente o desempenho do modelo em tarefas de recuperação e compreensão, introduzindo exemplos negativos ricos.

Quando o modelo ajustado lida com consultas negativas, a precisão e as taxas de recall são significativamente melhoradas, promovendo o progresso dos sistemas de inteligência artificial.

O surgimento da estrutura NegBench fornece uma solução eficaz para o problema dos modelos de linguagem visual na compreensão da negação. É de grande importância para melhorar o desempenho do modelo e promover o desenvolvimento da inteligência artificial, e merece mais pesquisas e aplicações.