Este artigo apresenta o método LLM2Clip desenvolvido pela Microsoft em colaboração com a Universidade Tongji, que visa melhorar o desempenho do codificador visual do modelo de clipe e resolver suas limitações no lidar com descrições de texto longas e complexas. O LLM2Clip aprimora significativamente a capacidade do modelo de combinar imagens e texto, integrando os grandes modelos de idiomas (LLMS) e introduzindo a tecnologia "contraste de título de ajuste fino". Os resultados experimentais desse método em vários conjuntos de dados mostram que, nas tarefas de recuperação de imagem para texto e texto para imagem, especialmente tarefas de recuperação de texto longas e curtas, eles superam os modelos tradicionais de clipe e eva e mostram um poderoso processamento entre linguagem cruzada habilidade.

No campo Ciência e Tecnologia de hoje, o clipe (pré-treinamento de imagens de linguagem contrastiva) é um importante modelo básico multimodal. Ele combina sinais visuais e de texto em um espaço de recurso compartilhado usando perdas de aprendizado de contraste em pares de texto de imagem em larga escala.

Como pesquisador, o CLIP pode suportar várias tarefas, como classificação zero, detecção, segmentação e recuperação de texto. Enquanto isso, como extrator de recurso, ele domina quase todas as tarefas de representação cruzada, como compreensão de imagens, compreensão de vídeo e geração de texto para imagem ou vídeo. O que é poderoso no clipe é sua capacidade de conectar imagens à linguagem natural e capturar o conhecimento humano, graças ao seu treinamento em dados de rede em larga escala, que contêm descrições detalhadas de texto.

No entanto, o clipe tem certas limitações para lidar com descrições de texto longas e complexas. Para superar esse problema, pesquisadores da Microsoft e da Universidade Tongji propuseram o método LLM2Clip, com o objetivo de melhorar a aprendizagem da representação visual, integrando grandes modelos de idiomas (LLMS). Esse método substitui com ousadia o codificador de texto de clipe original e usa o rico conhecimento do LLMS para melhorar o desempenho do codificador visual do clipe. O estudo constatou que a integração diretamente do LLMS no clipe resulta em degradação do desempenho; portanto, esse desafio precisa ser abordado.

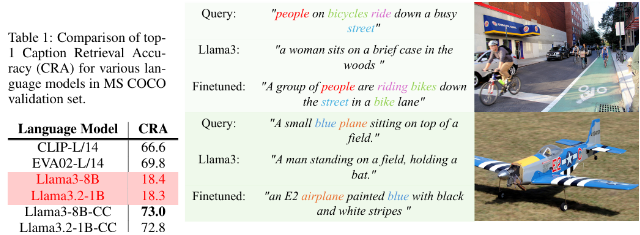

O método LLM2Clip melhora muito a capacidade da LLM de separar os títulos de imagens, introduzindo a tecnologia "Title Contrast Finening", alcançando assim uma melhoria significativa de desempenho.

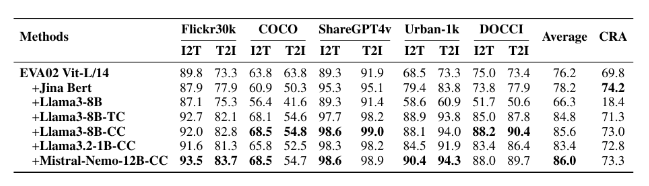

Os pesquisadores usaram conjuntos de dados de diferentes tamanhos para experimentos de ajuste fino, incluindo CC-3M pequenos, CC-3M médio e CC-12M, bem como CC-3M, CC-12M, YFCC-15M e recapção-1b. Os resultados mostram que o modelo treinado usando o LLM2Clip tem um desempenho melhor do que os modelos tradicionais de clipe e eVA nas tarefas de recuperação de imagem para texto e texto para imagem.

Ao combinar treinamento multimodal com modelos como o LLAVA 1.5, o LLM2Clip teve um bom desempenho em quase todos os benchmarks, especialmente ao lidar com tarefas de recuperação de texto longo e curto, melhorando o desempenho do modelo EVA02 anterior em 16,5%. Essa abordagem inovadora não apenas transforma o clipe de simplesmente processar dados em inglês em um poderoso modelo entre idiomas, mas também estabelece as bases para pesquisas futuras sobre treinamento de clipes.

Modelo: https://huggingface.co/collections/microsoft/llm2clip-672323a2666173cfa40b32d4c

Código: https://github.com/microsoft/llm2clip/

Papel: https://arxiv.org/abs/2411.04997

Pontos:

O LLM2Clip é uma abordagem inovadora proposta pela Microsoft e pela Universidade Tongji em colaboração com a Universidade Tongji, com o objetivo de melhorar o desempenho de seu codificador visual substituindo o codificador de texto do Clip.

Esse método aprimora significativamente a capacidade do modelo de combinar imagens com o texto através da técnica "Title Contrast Finesing", superando os modelos de última geração existentes.

Os experimentos da LLM2Clip em vários conjuntos de dados mostram que ele tem um desempenho melhor do que os modelos tradicionais em tarefas de recuperação de texto longo e curto, impulsionando o desenvolvimento de modelos de linguagem cruzada.

Em suma, o método LLM2Clip fornece novas idéias para a melhoria do modelo de clipe. Os links de recursos relacionados são convenientes para os leitores aprenderem e pesquisarem.