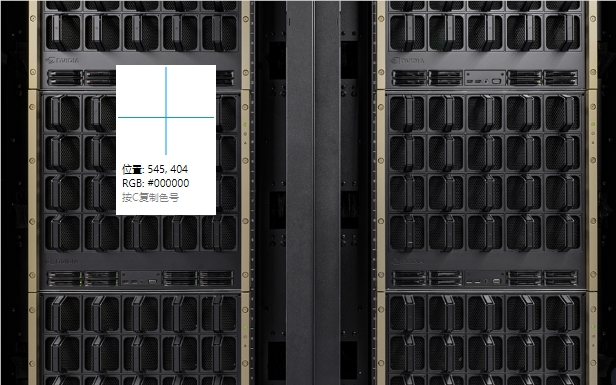

A NVIDIA lançou recentemente a nova plataforma Blackwell e mostrou melhorias impressionantes de desempenho na referência MLPerf Training 4.1. Comparado com as plataformas anteriores de tremonha, a Blackwell dobrou seu desempenho em várias tarefas de treinamento de IA, especialmente no treinamento de Modelo de Linguagem (LLM), e sua eficiência foi significativamente melhorada. Esse progresso inovador indica outro salto no poder de computação de IA e estabelece uma base sólida para a implementação generalizada dos aplicativos de IA no futuro. Este artigo conduzirá uma análise aprofundada do desempenho da plataforma Blackwell e discutirá sua inovação tecnológica e desenvolvimento futuro.

Recentemente, a Nvidia lançou sua nova plataforma Blackwell e demonstrou desempenho preliminar no referência MLPerf Training 4.1. De acordo com os resultados dos testes, o desempenho de Blackwell em alguns aspectos dobrou em comparação com a geração anterior de plataformas de tremonha, e essa conquista atraiu atenção generalizada do setor.

Na referência MLPERF Treination4.1, a plataforma Blackwell alcançou 2,2 vezes o desempenho de cada GPU na tarefa de ajuste fino LLAMA270B da referência LLM (Modelo de Linguagem Grande) e 2 vezes o desempenho de cada GPU no pré-treinamento de O GPT-3175B dobra a melhoria. Além disso, em outros benchmarks, como o treinamento estável de difusão V2, a nova geração de Blackwell também superou a geração anterior em 1,7 vezes.

Vale a pena notar que, embora Hopper continue mostrando melhorias, a Hopper também possui uma melhoria de desempenho de 1,3x no pré-treinamento do modelo de idioma em comparação com a rodada anterior de benchmarks de treinamento do MLPERF. Isso mostra que a tecnologia da Nvidia continua a melhorar. Na recente referência GPT-3175B, a Nvidia enviou 11.616 GPUs Hopper, estabelecendo um novo registro de expansão.

Em relação aos detalhes técnicos de Blackwell, a NVIDIA disse que a nova arquitetura usa núcleos otimizados de tensores e memória de largura de banda mais rápida. Isso faz com que apenas 64 GPUs executem o benchmark GPT-3175B, enquanto 256 GPUs para obter o mesmo desempenho usando a plataforma de tremonha.

A NVIDIA também enfatizou a melhoria do desempenho dos produtos de geração da Hopper em atualizações de software e rede na conferência de imprensa, e espera -se que Blackwell continue melhorando com futuros envios. Além disso, a NVIDIA planeja lançar a próxima geração de AI Accelerator Blackwell Ultra no próximo ano, que deve fornecer mais memória e poder de computação mais forte.

Blackwell também estreou em setembro passado na referência MLPERF Inferência v4.1 e, em termos de inferência de IA, alcança 4 vezes mais desempenho incrível por GPU do que o H100, especialmente com menor precisão de FP4 Essa nova tendência foi projetada para lidar com a crescente demanda por chatbots de baixa latência e computação inteligente, como o modelo O1 do OpenAI.

Pontos:

- ** NVIDIA Blackwell Platform dobra seu desempenho no treinamento de IA, quebrando os padrões da indústria! **

- ** Blackwell requer apenas 64 GPUs no benchmark GPT-3175B, melhorando significativamente a eficiência! **

- ** Blackwell Ultra será lançado no próximo ano, que deve fornecer maior memória e poder de computação! **

Em suma, o surgimento da plataforma Blackwell da NVIDIA marca um grande avanço no campo da computação de IA. Sua melhoria significativa de desempenho e o lançamento futuro da Blackwell Ultra promoverão ainda mais o desenvolvimento e a aplicação da tecnologia de IA e trarão mais possibilidades a todos os setores. Temos motivos para esperar que a plataforma Blackwell desempenhe um papel maior no futuro.