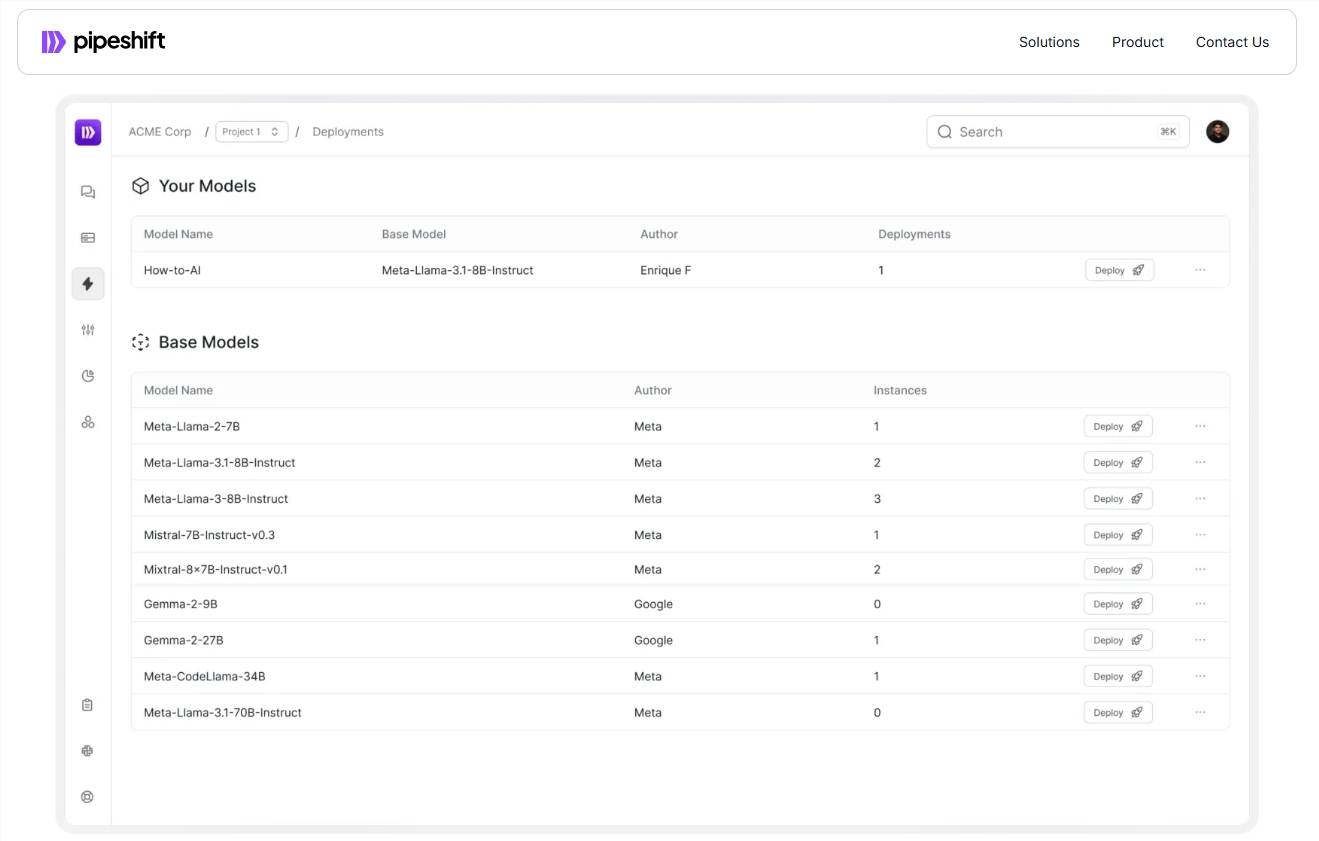

O Startup PipeShift lançou uma nova plataforma de ponta a ponta projetada para ajudar as empresas a treinar, implantar e escalar modelos de IA generativos de código aberto com mais eficiência. A plataforma é compatível com uma variedade de ambientes de nuvem e GPUs no local, melhorando significativamente a velocidade de inferência e reduzindo os custos, resolvendo o problema de alternância eficiente entre vários modelos por empresas. Ele adota uma estrutura mágica de inferência modular, que permite uma combinação flexível de diferentes componentes de inferência para otimizar o desempenho da inferência sem trabalho tedioso de engenharia. Este é, sem dúvida, um grande benefício para as empresas que enfrentam desafios na implantação e gerenciamento de modelos de IA.

Recentemente, a Startup PipeShift lançou uma nova plataforma de ponta a ponta projetada para ajudar as empresas a treinar, implantar e escalar modelos de IA generativos de código aberto com mais eficiência. A plataforma não apenas é executada em qualquer ambiente em nuvem ou na GPU local, mas também melhora significativamente a velocidade de inferência e reduz os custos.

Com o rápido desenvolvimento da tecnologia de IA, muitas empresas estão enfrentando o desafio de como alternar entre vários modelos com eficiência. Tradicionalmente, as equipes precisam construir um sistema MLOPS complexo que envolva vários links, como aquisição de recursos de computação, treinamento de modelos, ajuste fino e implantação no nível da produção. para o gerenciamento de infraestrutura.

Arko Chattopadhyay, co-fundador e CEO da PipShift, observou que o desenvolvimento de um mecanismo de raciocínio modular flexível geralmente leva anos de experiência, e as soluções da PipShift são projetadas para simplificar esse processo com seu mecanismo de raciocínio modular. A plataforma adota uma estrutura chamada Magic (Arquitetura Modular de Cluster de Inferência da GPU), que permite que as equipes combinem flexibilidade de diferentes componentes de inferência de acordo com requisitos específicos de carga de trabalho, otimizando assim o desempenho da inferência sem a necessidade de engenharia pesada.

Por exemplo, uma empresa de varejo da Fortune 500, depois de usar a plataforma PipeShift, integra quatro modelos que originalmente exigiram quatro instâncias independentes de GPU para executar em uma única instância de GPU. Dessa forma, a empresa não apenas alcançou um aumento de cinco vezes na velocidade de raciocínio, mas também reduziu os custos de infraestrutura em 60%. Essa conquista permite que as empresas permaneçam competitivas em um mercado em rápido crescimento.

A PipShift chegou a acordos anuais de licenciamento com 30 empresas e planos de lançar ferramentas para ajudar as equipes a criar e escalar conjuntos de dados no futuro. Isso acelerará ainda mais o processo experimental e de preparação de dados e melhorará a produtividade do cliente.

Entrada oficial: https://pipeshift.com/

Pontos:

O mecanismo de inferência modular da PipeShift pode reduzir significativamente o uso de GPU da inferência de IA e reduzir os custos em até 60%.

Através da estrutura mágica, as empresas podem combinar rapidamente componentes de inferência, melhorar a velocidade de inferência e reduzir a carga de engenharia.

A PipShift fez parceria com várias empresas e lançará mais ferramentas no futuro para ajudar as empresas a gerenciar as cargas de trabalho de IA com mais eficiência.

Com suas características eficientes, flexíveis e econômicas, a plataforma PipeShift fornece às empresas uma solução eficaz para simplificar a implantação e o gerenciamento dos modelos de IA, que vale a pena prestar atenção. Seu desenvolvimento futuro e o lançamento de novas ferramentas também valem a pena esperar.