A equipe de pesquisa da Salesforce AI divulgou o mais recente modelo de idioma multimodal, Blip-3-Video, com o objetivo de processar com eficiência dados de vídeo em crescimento. O modelo tradicional de compreensão de vídeo é ineficiente. Esse movimento resolve o problema de lidar com vídeos longos e fornece recursos mais fortes de compreensão de vídeo para indústrias como direção autônoma e entretenimento.

Recentemente, a equipe de pesquisa da Salesforce AI lançou um novo modelo de linguagem multimodal-Blip-3-Video. Com o rápido aumento no conteúdo de vídeo, como processar com eficiência os dados de vídeo se tornou um problema urgente. O surgimento deste modelo foi projetado para melhorar a eficiência e a eficácia da compreensão de vídeo e é adequado para indústrias, desde dirigir autônomo até entretenimento.

Os modelos tradicionais de compreensão de vídeo geralmente processam o quadro de vídeo a quadro, gerando uma grande quantidade de informações visuais. Esse processo não apenas consome muitos recursos de computação, mas também limita muito a capacidade de processar vídeos longos. À medida que a quantidade de dados de vídeo continua a crescer, essa abordagem se torna cada vez mais ineficiente, por isso é crucial encontrar uma solução que capte as informações críticas do vídeo enquanto reduz a carga de computação.

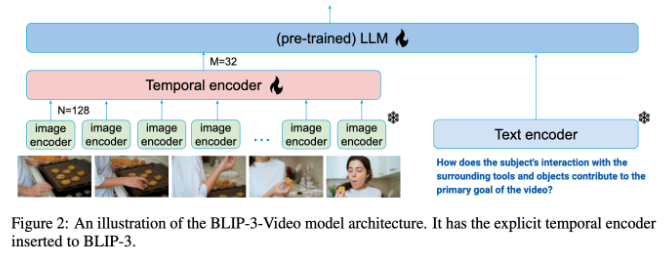

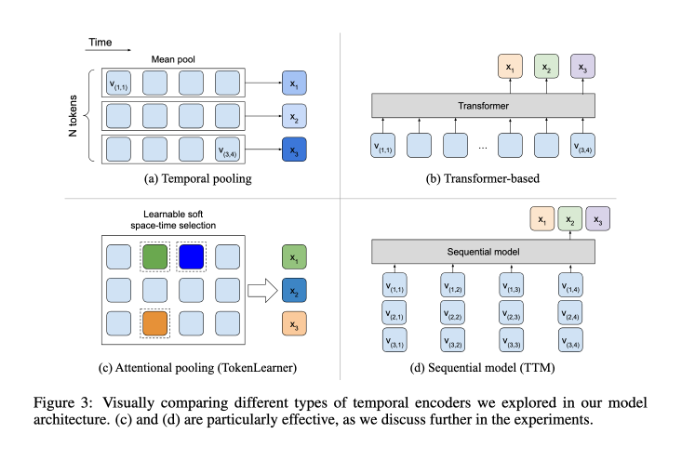

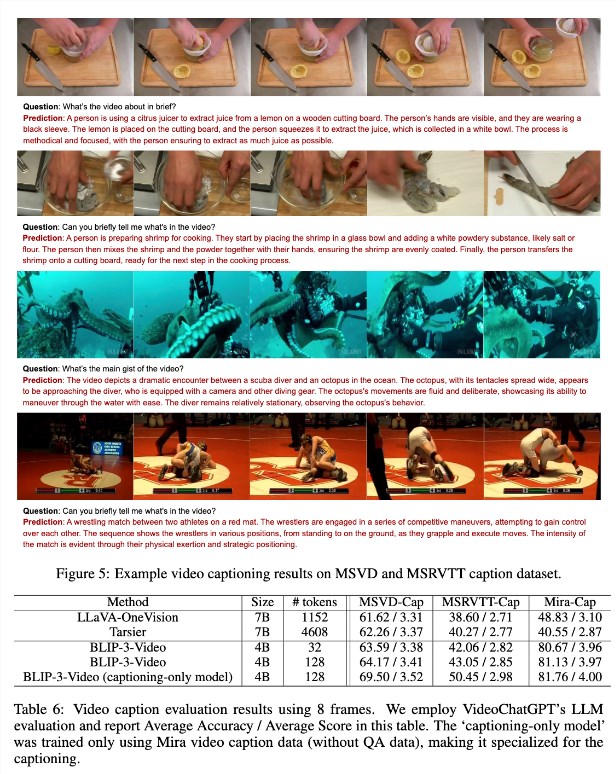

Nesse sentido, o BLIP-3-Video teve um desempenho muito bom. Ao introduzir um "codificador de sequência de tempo", o modelo reduziu com sucesso a quantidade de informações visuais necessárias no vídeo para 16 a 32 marcadores visuais. Esse design inovador melhora bastante a eficiência da computação, permitindo que os modelos concluam tarefas de vídeo complexas a um custo menor. Esse codificador de tempo usa um mecanismo de agrupamento de atenção espaço -temporal aprendida que extrai as informações mais importantes de cada quadro e a integra em um conjunto compacto de marcadores visuais.

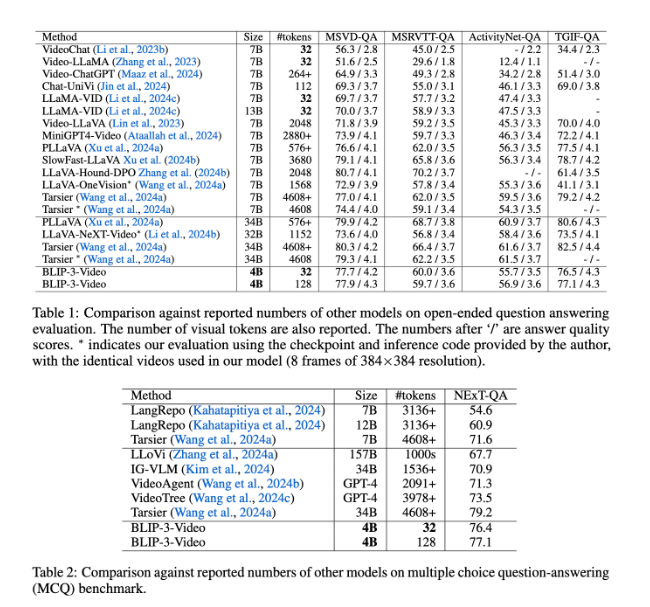

O BLIP-3-Video também teve um desempenho muito bom. Através da comparação com outros modelos grandes, o estudo constatou que o modelo possui uma taxa de precisão de modelos de topo comparáveis nas tarefas de perguntas e respostas em vídeo. Por exemplo, o modelo Tarsier-34B requer 4608 marcas para processar 8 quadros de vídeo, enquanto o BLIP-3-Video precisa apenas de 32 marcas para obter uma pontuação de referência de 77,7% do MSVD-QA. Isso mostra que o BLIP-3-VIDEO reduz significativamente o consumo de recursos, mantendo o alto desempenho.

Além disso, o desempenho do BLIP-3-VIDEO em tarefas de perguntas e respostas de múltipla escolha não deve ser subestimado. No conjunto de dados do próximo QA, o modelo alcançou uma pontuação alta de 77,1%, enquanto no conjunto de dados TGIF-QA, também alcançou uma taxa de precisão de 77,1%. Todos esses dados indicam a eficiência do BLIP-3-Video ao lidar com problemas de vídeo complexos.

O BLIP-3-VIDEO abre novas possibilidades no campo do processamento de vídeo por meio de codificadores de tempo inovadores. O lançamento deste modelo não apenas melhora a eficiência do entendimento de vídeo, mas também fornece mais possibilidades para futuros aplicativos de vídeo.

Entrada do projeto: https://www.salesforceairesearch.com/opensource/xgen-mm-vid/index.html

Pontos -chave:

-** Novo lançamento do modelo **: A pesquisa da Salesforce AI lança o BLIP-3-VIDEO, um modelo de linguagem multimodal, com foco no processamento de vídeo.

- ** Processamento eficiente **: O uso de um codificador de tempo reduz bastante o número de marcas visuais necessárias e melhora significativamente a eficiência da computação.

- ** Desempenho superior **: Excelente desempenho nas tarefas de perguntas e respostas em vídeo, mantenha alta precisão enquanto reduz o consumo de recursos.

Em resumo, o BLIP-3-Video trouxe um progresso significativo para o campo de entendimento em vídeo com seus recursos de processamento eficiente e excelente desempenho, e suas perspectivas de aplicativos são amplas. O código aberto deste modelo também fornece uma boa base para pesquisas e aplicações adicionais.