Com o rápido desenvolvimento do modelo de linguagem grande multimodal (MLLM), o processamento eficiente de vídeo ultra-longo se tornou um tópico importante na pesquisa atual. Os modelos existentes geralmente são limitados pelo comprimento do contexto e pelo custo computacional, dificultando a compreensão efetivamente os vídeos por hora. Em resposta a esse desafio, o Zhiyuan Research Institute e várias universidades lançaram o Video-XL, um modelo de linguagem visual ultra-longo projetado especificamente para um entendimento de vídeo eficiente em nível de hora.

Atualmente, o Modelo Multimodal de Linguagem de Grandes Idiomas (MLLM) fez um progresso significativo no campo da compreensão de vídeo, mas o manuseio de vídeos ultra-longos continua sendo um desafio. Isso ocorre porque os MLLMs geralmente lutam para lidar com milhares de marcadores visuais que excedem o comprimento máximo do contexto e são afetados pela atenuação da informação causada pela agregação de marcas. Ao mesmo tempo, um grande número de tags de vídeo também trará altos custos de computação.

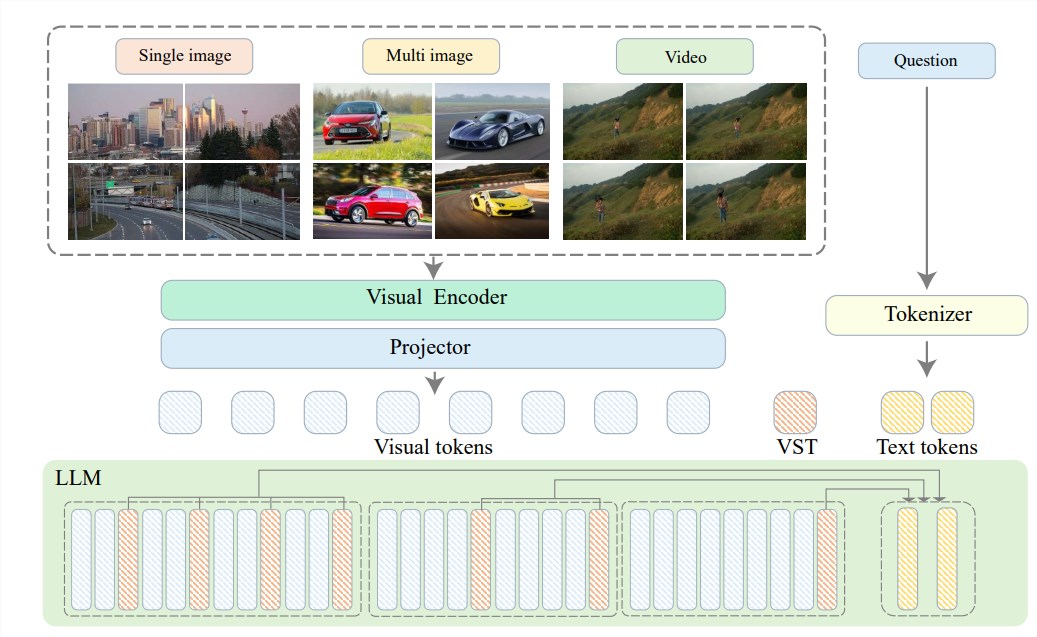

Para resolver esses problemas, o Zhiyuan Research Institute propôs o Video-XL em conjunto com a Universidade de Shanghai Jiaotong, a Universidade Renmin da China, a Universidade de Pequim e a Universidade de Posts e Telecomunicações, um super-designado e eficiente em vídeo Modelo de idioma. No centro do vídeo-XL está na tecnologia “Resumo do potencial de contexto visual”, que utiliza os recursos de modelagem de contexto inerentes ao LLM para comprimir efetivamente as longas representações visuais em formas mais compactas.

Simplificando, é comprimir o conteúdo de vídeo em uma forma mais simplificada, assim como concentrar uma carne inteira em uma tigela de essência de carne bovina, o que é conveniente para o modelo digerir e absorver.

Essa tecnologia de compactação não apenas melhora a eficiência, mas também mantém efetivamente as principais informações do vídeo. Você deve saber que vídeos longos geralmente são preenchidos com muitas informações redundantes, assim como a ligação do pé de uma velha senhora, que é longa e fedorenta. O Video-XL pode eliminar com precisão essas informações inúteis e reter apenas a essência, o que garante que o modelo não perca sua direção ao entender o conteúdo de vídeo longo.

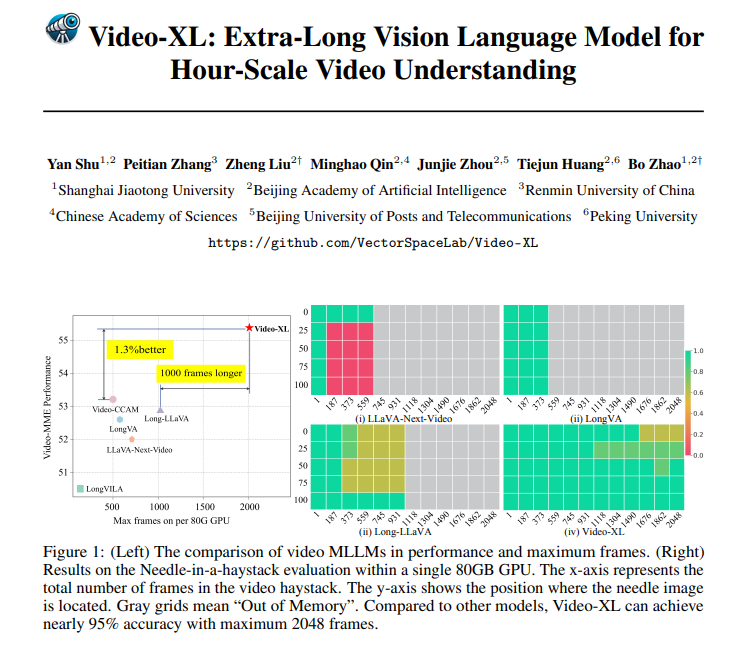

O Video-XL não é apenas muito poderoso em teoria, mas também tem uma habilidade prática muito poderosa. O VIDE-XL tem liderado o caminho em vários benchmarks de compreensão de vídeo longos, especialmente no teste VNBench, com uma precisão de quase 10% maior que os melhores métodos existentes.

O que é ainda mais impressionante é que o Video-XL atinge um equilíbrio incrível entre eficiência e eficácia, ele pode processar 2048 quadros de vídeo em uma única GPU de 80 GB, mantendo quase 95% de precisão na taxa de avaliação "Encontre uma agulha em um palheiro".

O Video-XL tem uma perspectiva de aplicativo muito ampla. Além de entender vídeos gerais longos, também pode ser competente para determinadas tarefas, como resumo de filmes, monitorar a detecção de anomalias e o reconhecimento de implantes de publicidade.

Isso significa que você não precisa suportar o lote longo ao assistir filmes no futuro. Eventos, que são muito mais eficientes do que a perseguição manual.

Endereço do projeto: https://github.com/vectorspacelab/video-xl

Papel: https://arxiv.org/pdf/2409.14485

Em resumo, o Video-XL fez um progresso inovador no campo do entendimento de vídeo ultra-longo.