Pesquisadores da Universidade de Princeton e da Universidade de Yale realizaram pesquisas aprofundadas sobre a capacidade de raciocínio "Cadeia of Thinking (COT)" de grandes modelos de linguagem (LLM) e divulgaram relatórios relevantes. O estudo levou a senha de turno como uma tarefa de teste e selecionou três LLMS GPT-4, Claude3 e LLAMA3.1 para análise, com o objetivo de revelar o mecanismo por trás da inferência do COT. A pesquisa descobriu que o raciocínio do COT da LLM não é um raciocínio lógico simbólico simples, mas resultado da interação complexa de vários fatores, que fornece uma nova perspectiva para entendermos a capacidade de raciocínio da LLM.

Pesquisadores da Universidade de Princeton e Yale divulgaram recentemente um relatório sobre a capacidade de raciocínio de “Cadeia de vinculação (COT)” no Big Language Model (LLM), revelando o mistério do raciocínio da BOT: não é um raciocínio simbólico baseado apenas em regras lógicas, mas Combina memória, probabilidade e raciocínio de ruído.

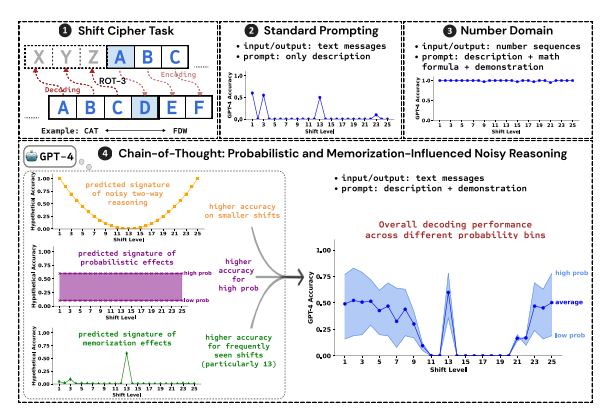

Os pesquisadores usaram a senha de troca como uma tarefa de teste para analisar o desempenho dos três LLMs, GPT-4, Claude3 e LLAMA3.1. As senhas de turno são um método simples de codificação e cada letra é substituída por cartas que avançam no alfabeto com dígitos fixos. Por exemplo, mova o alfabeto para a frente por 3 dígitos e "Cat" se torna "FDW".

Os resultados da pesquisa mostram que os três fatores -chave que afetam a eficácia da inferência do COT são:

Probabilidade: o LLM tende a gerar saídas com maior probabilidade, mesmo que a etapa de inferência aponte para respostas com menor probabilidade. Por exemplo, se a etapa de raciocínio apontar para "Staz", mas "Stay" for a palavra mais comum, o LLM pode "se corrigir" e a saída "Stay".

MEMÓRIA: LLM se lembra de uma grande quantidade de dados de texto durante o pré-treinamento, o que afeta a precisão de sua inferência COT. Por exemplo, o ROT-13 é a senha de mudança mais comum e o LLM tem uma precisão significativamente maior no ROT-13 do que outros tipos de senhas de turno.

Raciocínio de ruído: o processo de raciocínio do LLM não é completamente preciso, mas há um certo grau de ruído. À medida que o deslocamento da senha de mudança aumenta, as etapas intermediárias necessárias para a decodificação também aumentam e o impacto da inferência de ruído se torna mais óbvio, resultando em uma diminuição na precisão do LLM.

Os pesquisadores também descobriram que o raciocínio do COT da LLM depende do auto-condicionamento, ou seja, o LLM precisa gerar explicitamente o texto como o contexto para as etapas de raciocínio subsequentes. Se o LLM for instruído a "pensar em silêncio" sem emitir nenhum texto, sua capacidade de raciocínio será bastante reduzida. Além disso, a eficácia da etapa de demonstração tem pouco impacto na inferência do COT.

Este estudo mostra que o raciocínio do COT da LLM não é um raciocínio simbólico perfeito, mas combina vários fatores como memória, probabilidade e raciocínio de ruído. O LLM não apenas mostra as características de um mestre de memória no processo de raciocínio do COT, mas também mostra o estilo de um mestre de probabilidade. Esta pesquisa nos ajuda a ter um entendimento mais profundo dos recursos de raciocínio da LLM e a fornecer informações valiosas para o desenvolvimento futuro de sistemas de IA mais poderosos.

Endereço em papel: https://arxiv.org/pdf/2407.01687

Em resumo, este estudo é de grande significado para entender o mecanismo de raciocínio de grandes modelos de linguagem, e suas descobertas fornecem referência valiosa para melhorar as capacidades de raciocínio do LLM no futuro e desenvolver sistemas de IA mais poderosos. O estudo enfatiza o impacto de fatores como probabilidade, memória e ruído no raciocínio do LLM, fornecendo novas direções para pesquisadores no campo da IA.