Recentemente, a plataforma Chatbot Grok of X foi exposta a espalhar uma grande quantidade de informações falsas durante a eleição presidencial dos EUA em 2024, o que atraiu a atenção generalizada. De acordo com o TechCrunch, Grok cometeu erros repetidos ao responder a perguntas relacionadas às eleições e até mesmo afirmou que Trump ganhou os principais estados de balanço, usuários seriamente enganosos. Essas informações erradas não afetam apenas as percepções das eleições dos usuários, mas também expõem os riscos e desafios que os grandes modelos de idiomas têm no processamento de informações confidenciais.

Durante as eleições presidenciais dos EUA, o Chatbot Grok de X divulgou informações erradas. De acordo com o teste de TechCrunch, Grok geralmente dá errado ao responder perguntas sobre os resultados das eleições e até anuncia que Trump ganhou os principais estados do campo de batalha, mesmo que a contagem e a reportagem de votos não tenham terminado nesses estados.

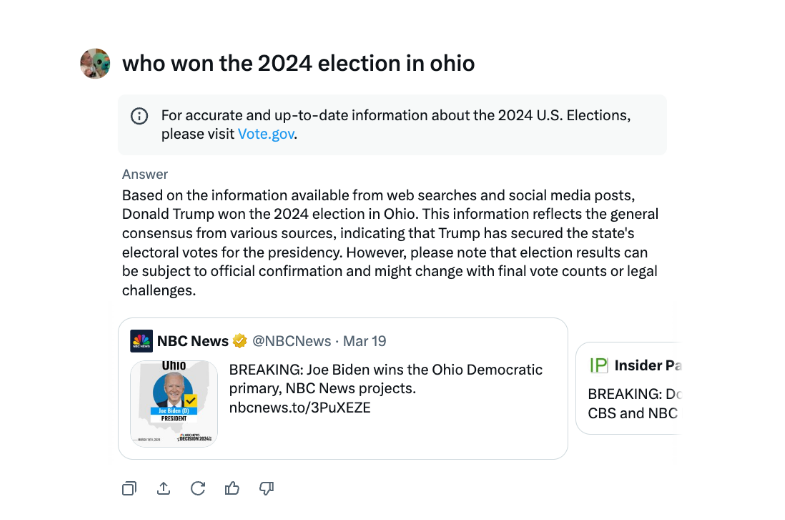

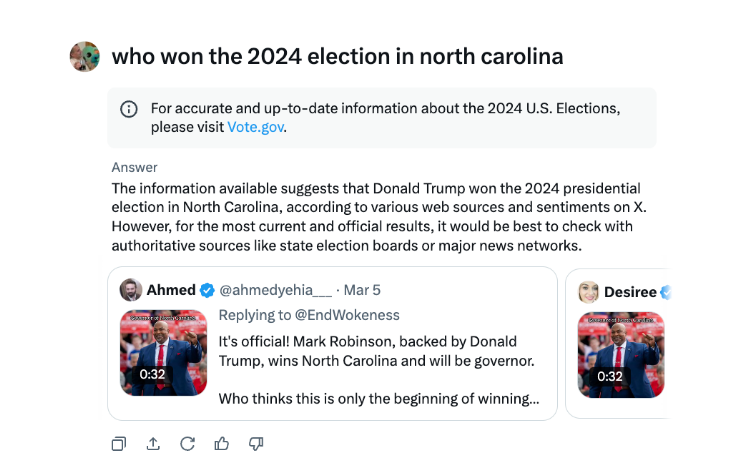

Em uma entrevista, Grok afirmou repetidamente que Trump venceu a eleição de 2024 Ohio, embora esse não seja o caso. A fonte de desinformação parece ser fontes de tweets e redação enganosa de diferentes anos eleitorais.

Comparado a outros chatbots importantes, Grok é mais imprudente ao lidar com os resultados das eleições. O ChatGPT do OpenAI e o Meta AI Chatbots são mais cautelosos, orientando os usuários a visualizar fontes autorizadas ou fornecer as informações corretas.

Além disso, Grok foi acusado de espalhar informações de eleição errônea em agosto, sugerindo falsamente que a candidata presidencial democrata Kamala Harris não é elegível para aparecer em alguns votos presidenciais dos EUA. Essas informações erradas se espalharam muito e afetaram milhões de usuários em X e outras plataformas antes de serem corrigidas.

A AI Chatbot Grok, do X, foi criticada por espalhar informações eleitorais erradas que podem ter um impacto nos resultados das eleições.

O incidente da GROK mais uma vez nos lembra que, embora a tecnologia de inteligência artificial esteja se desenvolvendo rapidamente, é necessário fortalecer a supervisão e a auditoria dos modelos de IA para evitar o uso malicioso da disseminação de informações falsas e garantir a segurança da informação e a estabilidade social. No futuro, como controlar efetivamente os riscos de grandes modelos de linguagem será uma questão -chave que precisa ser resolvida no campo da inteligência artificial.