As equipes de pesquisa da Universidade de Stanford e da Universidade de Washington lançaram recentemente um método de treinamento de IA inovador chamado S1. Diferentemente da dependência do grande poder de computação ou algoritmos complexos, o método S1 alcança inteligentemente um salto de desempenho, controlando a alocação de recursos de computação do modelo durante o teste.

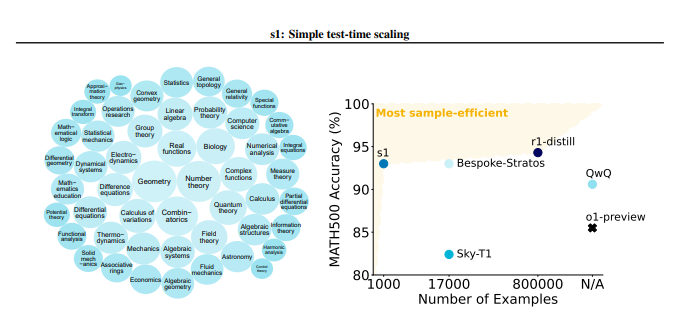

O método S1 primeiro construiu cuidadosamente um pequeno conjunto de dados chamado S1K que continha 1000 problemas de inferência de alta qualidade. Os padrões de triagem desse conjunto de dados são muito rigorosos e devem atender às três condições de alta dificuldade, forte diversidade e excelente qualidade ao mesmo tempo. A equipe de pesquisa verificou a importância desses três critérios por meio de experimentos detalhados de ablação, e os resultados mostraram que a seleção aleatória ou o foco em um único critério levaria a um declínio significativo no desempenho. Vale a pena mencionar que, mesmo que seja treinado usando um superset contendo 59.000 amostras, seu efeito é muito menor que o das 1.000 amostras cuidadosamente selecionadas, o que destaca a criticidade da seleção de dados.

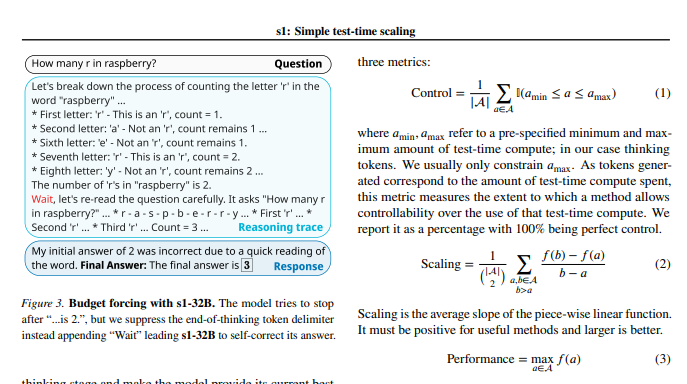

Após a conclusão do treinamento do modelo, os pesquisadores usaram uma técnica chamada "Orçamento obrigatório" para controlar a quantidade de cálculos durante o teste. Simplificando, esse método estende o tempo de pensamento do modelo, encerrando à força o processo de pensamento do modelo ou adicionando instruções "aguardando", orientando assim o modelo para uma exploração e verificação mais aprofundadas. Dessa forma, o modelo pode verificar repetidamente as etapas de inferência e corrigir efetivamente os erros.

Os resultados experimentais mostram que, com o ajuste fino no conjunto de dados S1K e o suporte da tecnologia "obrigatória para o orçamento", o desempenho do modelo S1-32B em problemas matemáticos no nível da concorrência excedeu o modelo de previsão O1 de OpenAI em até 27%. O que é ainda mais surpreendente é que, através da escala "obrigatória", o modelo S1-32B também mostrou capacidade de generalização além de seu próprio nível de treinamento, e sua pontuação no conjunto de testes AIME24 aumentou de 50% para 57%.

A contribuição principal deste estudo é que ele fornece um método simples e eficiente para criar conjuntos de dados com altos recursos de inferência e alcançar o escalonamento de desempenho ao testar. Com base nisso, a equipe de pesquisa criou o modelo S1-32B, cujo desempenho é comparável ou até supera o modelo de código fechado e, ao mesmo tempo, atinge o código aberto e a alta eficiência da amostra. O código, o modelo e os dados do estudo são de origem aberta no GitHub.

Os pesquisadores também realizaram experimentos detalhados de ablação sobre as sutilezas dos dados e a técnica de escala durante o teste. No lado dos dados, eles acharam crucial considerar dificuldade, diversidade e qualidade ao mesmo tempo. Em termos de escala no tempo de teste, a abordagem "Orçamento obrigatório" mostra excelente controlabilidade e melhorias de desempenho. O estudo também explora dois métodos diferentes, escala paralela e escala seqüencial e introduz tecnologias avançadas, como o Rebase, fornecendo inspiração importante para futuras direções de pesquisa.

Este estudo não apenas traz uma nova idéia de baixo custo e alta eficiência para o campo de treinamento de IA, mas também estabelece uma base sólida para uma gama mais ampla de aplicações de IA.

Endereço em papel: https://arxiv.org/pdf/2501.19393

Este estudo demonstra que, por meio de cuidadosos conjuntos de dados de dados e gerenciamento de recursos de computação em tempo de computação, os recursos de inferência dos modelos de IA podem ser significativamente aprimorados, fornecendo novas direções para o desenvolvimento futuro da IA.