Recentemente, a equipe Vita-MLLM divulgou seu último resultado de pesquisa Vita-1.5. O Vita-1.5 não apenas suporta dois idiomas: inglês e chinês, mas também atinge um salto qualitativo em vários indicadores de desempenho, tornando os usuários uma experiência interativa mais suave e eficiente.

O Vita-1.5 fez um grande avanço no atraso da interação, reduzindo bastante o atraso original de 4 segundos para apenas 1,5 segundos. Essa melhoria permite que os usuários quase não sejam atrasos durante a interação da voz, melhorando bastante a experiência do usuário. Além disso, o Vita-1.5 também melhorou significativamente no desempenho multimodal.

Em termos de processamento de voz, o Vita-1.5 também foi profundamente otimizado. A taxa de erro do seu sistema de reconhecimento automático de fala (ASR) caiu de 18,4 para 7,5, melhorando significativamente a precisão da compreensão e resposta dos comandos de voz. Ao mesmo tempo, o Vita-1.5 apresenta um novo módulo de texto para fala (TTS) de ponta a ponta, que pode receber diretamente incorporações de grandes modelos de linguagem (LLMS) como entrada, melhorando bastante a naturalidade e a coerência da síntese da fala .

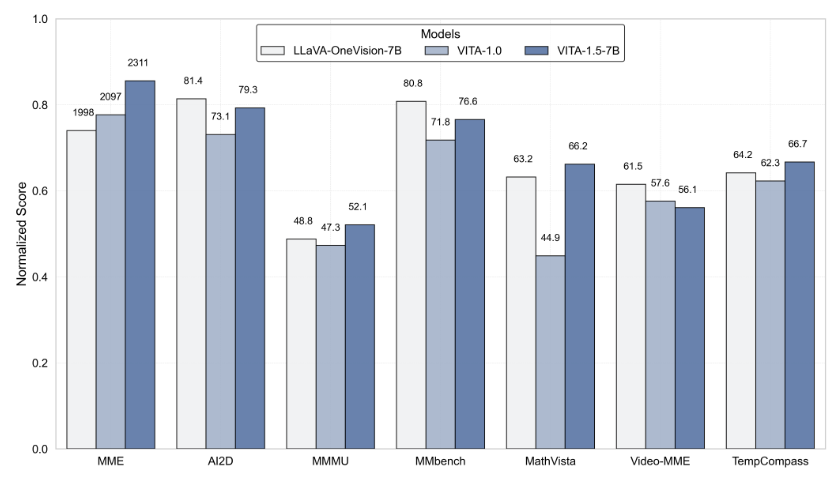

Para garantir o equilíbrio dos recursos multimodais, o Vita-1.5 adota uma estratégia de treinamento progressiva, que minimiza o impacto do módulo de processamento de fala recém-adicionado no desempenho da linguagem visual, e o desempenho da compreensão da imagem diminuiu apenas de 71,3 para 70,8. Através dessas inovações tecnológicas, o Vita-1.5 promove ainda mais os limites entre as interações visuais e de voz em tempo real, estabelecendo uma base sólida para futuras aplicações de interação inteligentes.

Para os desenvolvedores, o Vita-1.5 é muito conveniente de usar. Os desenvolvedores podem começar rapidamente com operações simples de linha de comando, e a equipe também fornece demonstrações interativas básicas e em tempo real para ajudar os usuários a entender e usar melhor o sistema. Para melhorar ainda mais a experiência interativa em tempo real, os usuários precisam preparar alguns módulos necessários, como o módulo de detecção de atividades de voz (VAD). Além disso, o Código de Vita-1.5 será totalmente de código aberto, permitindo que os desenvolvedores participem e contribuam e promovam em conjunto o avanço dessa tecnologia.

O lançamento do Vita-1.5 marca outro marco importante no campo do modelo de linguagem grande multimodal interativa, demonstrando a busca incessante da equipe Vita-MLLM em inovação tecnológica e experiência do usuário. O lançamento desta versão não apenas traz aos usuários uma experiência interativa mais inteligente, mas também aponta a direção para o desenvolvimento futuro da tecnologia multimodal.

Entrada do projeto: https://github.com/vita-mllm/vita?tab=readme-ov-file

Pontos -chave:

O Vita-1.5 reduz significativamente a latência de interação, reduzindo de 4 segundos para 1,5 segundos, melhorando significativamente a experiência do usuário.

O desempenho multimodal melhorou, com o desempenho médio de vários benchmarks aumentou de 59,8 para 70,8.

A capacidade de processamento de voz é aprimorada, a taxa de erro ASR caiu de 18,4 para 7,5 e o reconhecimento de fala é mais preciso.