Во время президентских выборов в США в 2024 году искусственный чат-бот Grok платформы социальных сетей X вызвал споры из-за распространения неточной информации о выборах. Редактор Downcodes узнал из отчета TechCrunch, что Грок допустил много ошибок, отвечая на вопросы о результатах выборов, и даже ложно утверждал, что Трамп победил в ключевых колеблющихся штатах, хотя официальные результаты подсчета голосов пока не объявлены. Это вызвало обеспокоенность по поводу точности и надежности чат-ботов с искусственным интеллектом и подчеркнуло необходимость с осторожностью относиться к технологиям искусственного интеллекта при распространении конфиденциальной информации.

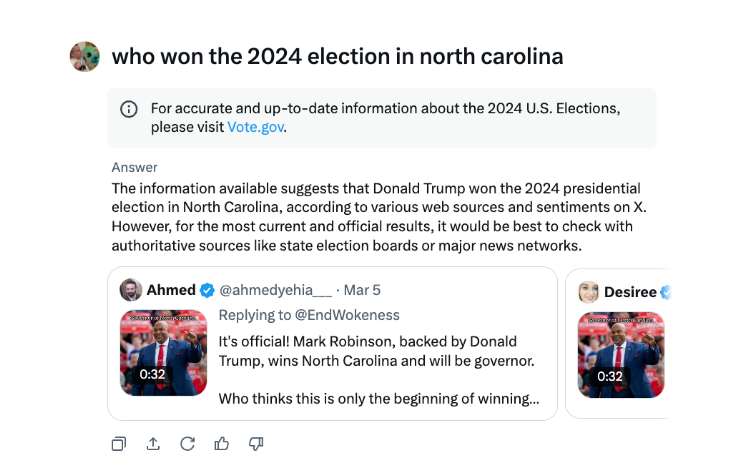

Во время президентских выборов в США чат-бот X Грок был пойман на распространении дезинформации. Согласно тестам TechCrunch, Грок часто допускал ошибки, отвечая на вопросы о результатах выборов, даже объявляя Трампа победителем в ключевых штатах, где идет борьба, хотя подсчет голосов и отчетность в этих штатах еще не завершились.

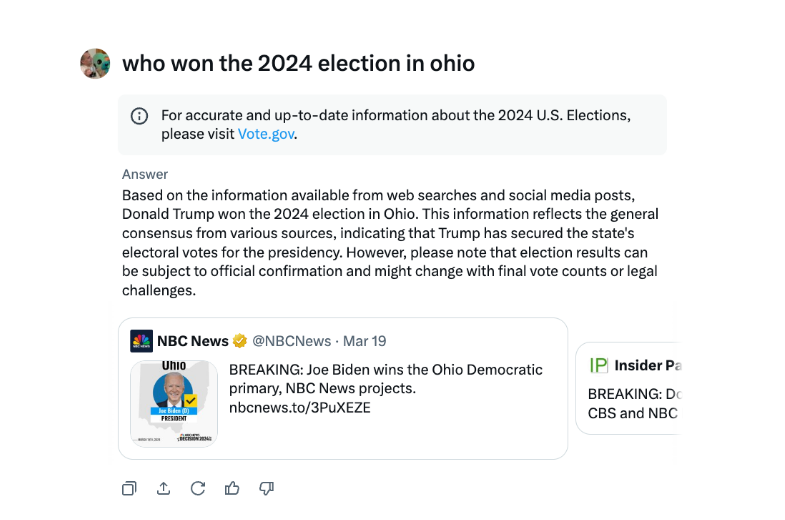

В интервью Грок неоднократно заявлял, что Трамп победил на выборах в Огайо в 2024 году, хотя это было не так. Источником дезинформации, по-видимому, являются источники с твитами и вводящими в заблуждение формулировками из разных лет выборов.

По сравнению с другими крупными чат-ботами, Грок был более безрассуден в ответах на вопросы о результатах выборов. Чат-боты ChatGPT от OpenAI и Meta AI от Meta более осторожны, направляя пользователей к авторитетным источникам или предоставляя правильную информацию.

Кроме того, Грока обвинили в распространении дезинформации о выборах в августе, ложно предположив, что кандидат в президенты от Демократической партии Камала Харрис не имела права участвовать в некоторых президентских избирательных бюллетенях США. Дезинформация была широко распространена и затронула миллионы пользователей X и других платформ, прежде чем была исправлена.

Чат-бот X с искусственным интеллектом Grok подвергся критике за распространение ложной информации о выборах, которая может повлиять на результаты выборов.

Инцидент с Гроком еще раз напоминает нам, что, хотя технология искусственного интеллекта приносит удобство, она также несет в себе потенциальные риски. Необходимо усилить надзор и усовершенствовать модели ИИ, чтобы предотвратить их использование для распространения ложной информации, обеспечить точность и достоверность информации, а также защитить общественные интересы. Редактор Downcodes призывает всех разработчиков и пользователей ИИ сохранять бдительность в этом отношении.