Исследовательская группа из Университета Карнеги-Меллона недавно выпустила революционную технологию DressRecon, которая может реконструировать согласованную во времени и подробную 3D-модель человеческого тела по монокулярному видео. В отличие от предыдущих методов реконструкции человеческого тела, которые требуют тесной одежды или данных с нескольких изображений, DressRecon может обрабатывать сцены в свободной одежде или даже с объектами, что значительно расширяет сферу применения и привносит инновации в такие области, как создание виртуальных изображений и производство анимации. Редактор Downcodes даст вам более глубокое понимание этой впечатляющей технологии.

Недавно исследовательская группа из Университета Карнеги-Меллон выпустила новую технологию под названием «DressRecon», цель которой — восстановить постоянную во времени модель человека по монокулярному видео. Самое замечательное в DressRecon то, что вы можете не только ввести видео для создания 3D-модели, но и восстановить мелкие детали, такие как сложная одежда и предметы ручной работы.

Эта технология особенно подходит для ситуаций, когда вы носите свободную одежду или взаимодействуете с ручными предметами, преодолевая ограничения предыдущих технологий. В прошлом реконструкция человеческого тела обычно требовала ношения облегающей одежды или требовала многопроекционной калибровки для сбора данных или даже персонализированного сканирования, которое было трудно собрать в больших масштабах.

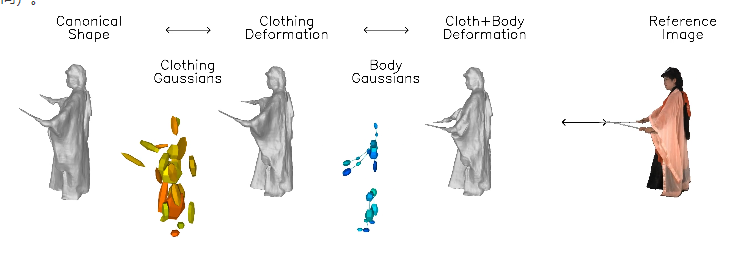

Инновация DressRecon заключается в том, что она сочетает в себе общие предварительные знания о форме человеческого тела и деформации тела, специфичные для видео, и может быть оптимизирована внутри видео.

Суть этой технологии заключается в изучении нейронной неявной модели, которая может отдельно обрабатывать деформацию тела и одежды и отдельно устанавливать слои модели движения.

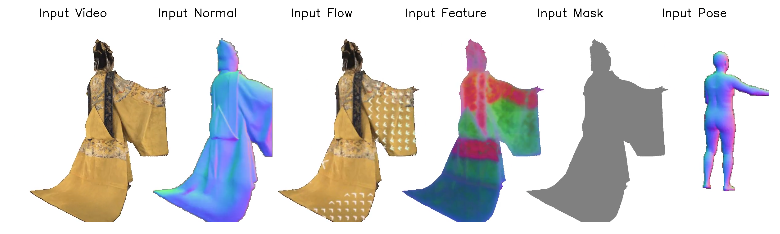

Чтобы уловить тонкие геометрические особенности одежды, исследовательская группа использовала предварительные знания, основанные на изображениях, включая позу человека, нормали поверхности и оптический поток. Эта информация обеспечивает дополнительную поддержку в процессе оптимизации, делая эффект реконструкции более реалистичным.

DressRecon способен извлекать высококачественные 3D-модели из одного видеовхода и даже может быть дополнительно оптимизирован в явные 3D-гауссианы для улучшения качества рендеринга и поддержки интерактивной визуализации.

Исследователи продемонстрировали высокоточные эффекты 3D-реконструкции, которых DressRecon может достичь на некоторых сложных наборах данных о деформации одежды и взаимодействии объектов.

Кроме того, реконструированное виртуальное изображение человека можно визуализировать под любым углом, демонстрируя очень впечатляющий визуальный эффект. Команда также сравнила производительность DressRecon с несколькими базовыми технологиями реконструкции формы. Результаты показали, что DressRecon показал более высокую точность при обработке сложных деформированных структур.

Вход в проект: https://jefftan969.github.io/dressrecon/

Выделять:

? Исследовательская группа запустила технологию DressRecon для достижения высококачественной реконструкции человеческого тела с помощью монокулярного видео, особенно подходящего для сцен со свободной одеждой и ручными предметами.

? Используя неявные нейронные модели, эта технология обрабатывает деформации тела и одежды отдельно и фиксирует тонкие геометрические особенности с помощью предварительного знания базы изображений.

? Результаты реконструкции могут не только генерировать трехмерные модели высокой точности, но также поддерживать рендеринг под любым углом, улучшая качество визуализации.

Появление технологии DressRecon, несомненно, будет способствовать развитию технологии 3D-моделирования человеческого тела большим шагом вперед. Его эффективные и удобные функции, а также отличные возможности обработки сложных сцен открывают неограниченные возможности в области виртуальной реальности, производства анимации, разработки игр и других областях в будущем. Мы с нетерпением ждем, когда эта технология реализует свой огромный потенциал в большем количестве сценариев применения!