В последние годы модель Трансформера и ее механизм внимания добились значительного прогресса в области больших языковых моделей (LLM), но проблема восприимчивости к помехам со стороны нерелевантной информации существовала всегда. Редактор Downcodes интерпретирует для вас последнюю статью, в которой предлагается новая модель под названием Дифференциальный трансформатор (DIFF Transformer), целью которой является решение проблемы шума внимания в модели Transformer и повышение эффективности и точности модели. Модель эффективно отфильтровывает ненужную информацию с помощью инновационного механизма дифференцированного внимания, позволяя модели больше сосредоточиться на ключевой информации, тем самым достигая значительных улучшений во многих аспектах, включая языковое моделирование, обработку длинного текста, поиск ключевой информации, уменьшение иллюзий модели и т. д. .

В последнее время быстро развиваются модели больших языков (LLM), в которых важную роль играет модель Transformer. Ядром Transformer является механизм внимания, который действует как информационный фильтр и позволяет модели сосредоточиться на наиболее важных частях предложения. Но даже мощному Трансформеру будет мешать ненужная информация, точно так же, как вы пытаетесь найти книгу в библиотеке, но вас заваливает кучей ненужных книг, и эффективность, естественно, низкая.

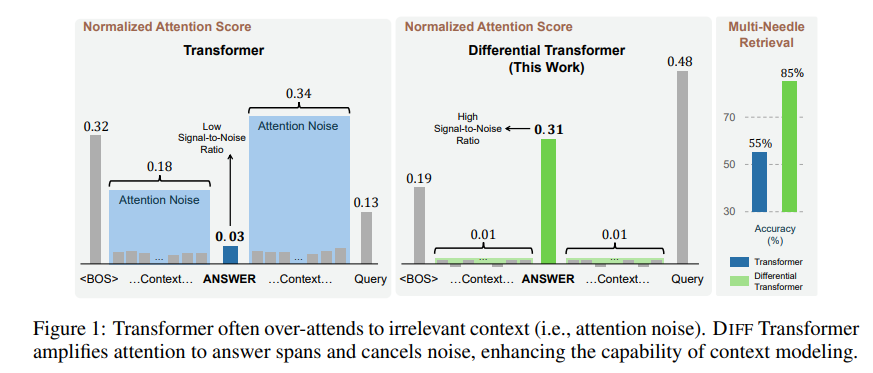

Нерелевантная информация, генерируемая этим механизмом внимания, в статье называется шумом внимания. Представьте, что вы хотите найти ключевую информацию в файле, но внимание модели Трансформера рассеяно по разным нерелевантным местам, как у недальновидного человека, который не может увидеть ключевые моменты.

Для решения этой проблемы в данной статье предлагается дифференциальный трансформатор (DIFF Transformer). Название очень продвинутое, но принцип на самом деле очень прост. Как и в наушниках с шумоподавлением, шум устраняется за счет разницы между двумя сигналами.

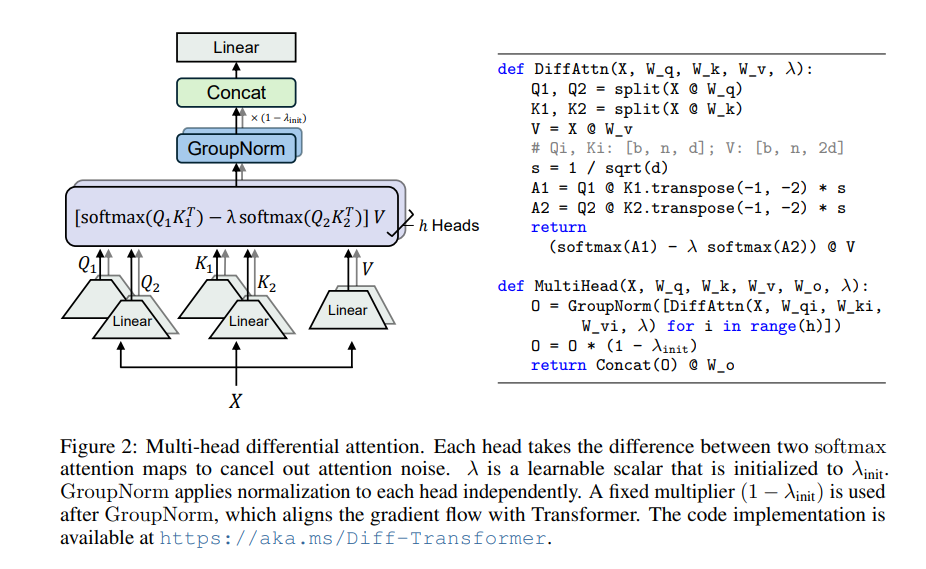

Ядром дифференциального преобразователя является механизм дифференцированного внимания. Он делит вектор запроса и ключевые векторы на две группы, вычисляет две карты внимания соответственно, а затем вычитает эти две карты, чтобы получить окончательную оценку внимания. Этот процесс подобен съемке одного и того же объекта двумя камерами с последующим наложением двух фотографий, и различия будут выделены.

Таким образом, дифференциальный преобразователь может эффективно устранить шум внимания и позволить модели больше сосредоточиться на ключевой информации. Точно так же, как когда вы надеваете наушники с шумоподавлением, окружающий шум исчезает, и вы можете слышать нужный звук более четко.

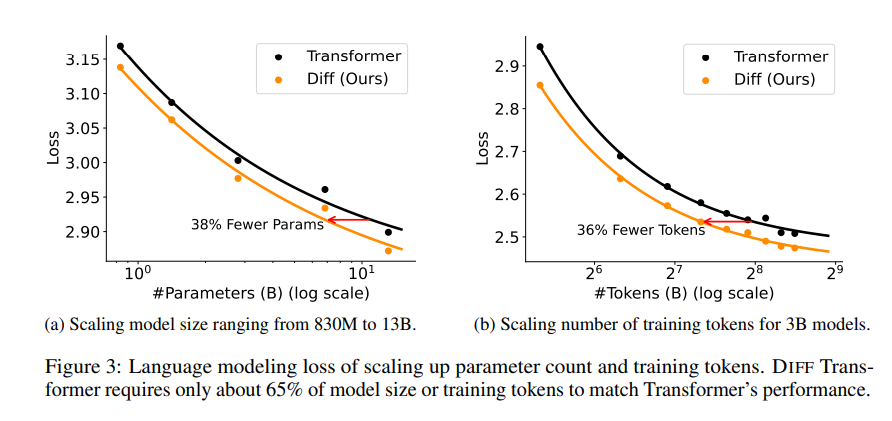

В статье была проведена серия экспериментов, чтобы доказать превосходство дифференциального трансформатора. Во-первых, он хорошо работает при языковом моделировании, требуя всего 65% размера модели или обучающих данных Transformer для достижения аналогичных результатов.

Во-вторых, дифференциальный преобразователь также лучше справляется с моделированием длинных текстов и может эффективно использовать более длинную контекстную информацию.

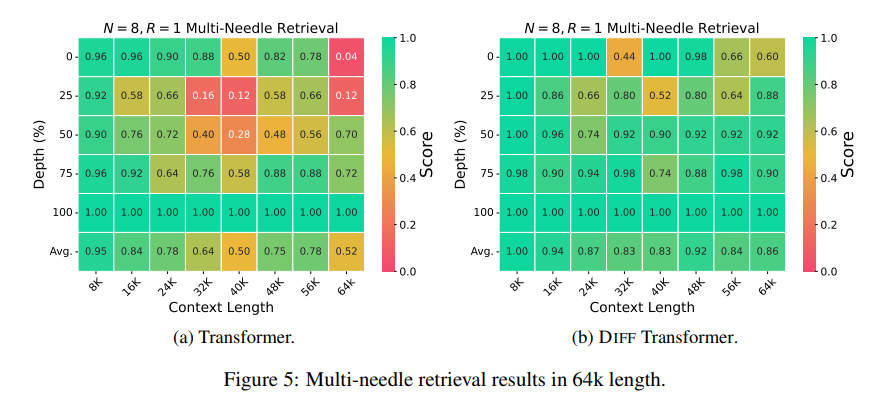

Что еще более важно, дифференциальный преобразователь демонстрирует значительные преимущества в поиске ключевой информации, уменьшении иллюзий модели и изучении контекста.

С точки зрения поиска ключевой информации, дифференциальный преобразователь похож на точную поисковую систему, которая может точно найти то, что вам нужно, в огромных объемах информации. Он может поддерживать высокую точность даже в сценариях с чрезвычайно сложной информацией.

Что касается уменьшения галлюцинаций модели, дифференциальный преобразователь может эффективно избегать «бессмыслицы» модели и генерировать более точное и надежное обобщение текста, а также результаты вопросов и ответов.

С точки зрения контекстного обучения, Дифференциальный Трансформатор больше похож на мастера обучения, способного быстро усваивать новые знания из небольшого количества образцов, а эффект обучения более стабилен, в отличие от Трансформатора, на который не так легко влияет порядок образцов. .

Кроме того, дифференциальный преобразователь также может эффективно уменьшать выбросы в значениях активации модели, что означает, что он более удобен для квантования модели и может обеспечить квантование с меньшими битами, тем самым повышая эффективность модели.

В целом, Дифференциальный Трансформатор эффективно решает проблему шума внимания модели Трансформера с помощью механизма дифференциального внимания и достигает значительных улучшений во многих аспектах. Он дает новые идеи для разработки больших языковых моделей и в будущем сыграет важную роль во многих областях.

Адрес статьи: https://arxiv.org/pdf/2410.05258.

В целом, дифференциальный преобразователь обеспечивает эффективный метод решения проблемы шума модели трансформатора. Его отличная производительность во многих областях указывает на его важную роль в разработке больших языковых моделей в будущем. Редактор Downcodes рекомендует читателям прочитать всю статью, чтобы получить более глубокое понимание ее технических деталей и перспектив применения. Мы с нетерпением ждем, когда «Дифференциальный трансформатор» принесет еще больше прорывов в области искусственного интеллекта!