Apple выпустила крупное обновление своей мультимодальной модели искусственного интеллекта MM1 — MM1.5. Это обновление представляет собой не простую итерацию версии, а всестороннее улучшение возможностей модели, значительно повышающее ее производительность в понимании изображений, распознавании текста и визуальном выполнении команд. Редактор Downcodes подробно объяснит улучшения MM1.5 и его значение в области мультимодального искусственного интеллекта.

Недавно Apple выпустила крупное обновление своей мультимодальной модели искусственного интеллекта MM1, обновив ее до версии MM1.5. Это обновление представляет собой не простое изменение номера версии, а комплексное улучшение возможностей, позволяющее модели демонстрировать более высокую производительность в различных областях.

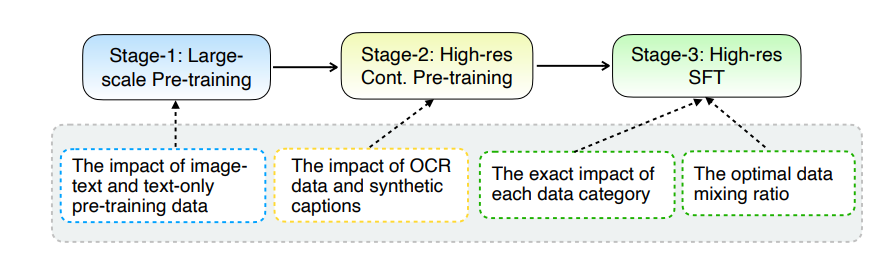

Основное обновление MM1.5 заключается в инновационном методе обработки данных. В модели применяется подход обучения, ориентированный на данные, а набор обучающих данных тщательно проверяется и оптимизируется. В частности, MM1.5 использует данные оптического распознавания символов высокой четкости и синтетические описания изображений, а также оптимизированные визуальные инструкции для точной настройки набора данных. Введение этих данных значительно улучшило производительность модели в распознавании текста, понимании изображений и выполнении визуальных инструкций.

Что касается размера модели, MM1.5 охватывает несколько версий от 1 до 30 миллиардов параметров, включая интенсивные варианты и варианты со смешанным участием экспертов (MoE). Стоит отметить, что даже модели меньшего масштаба с 1 миллиардом и 3 миллиардами параметров могут достичь впечатляющих уровней производительности с тщательно разработанными данными и стратегиями обучения.

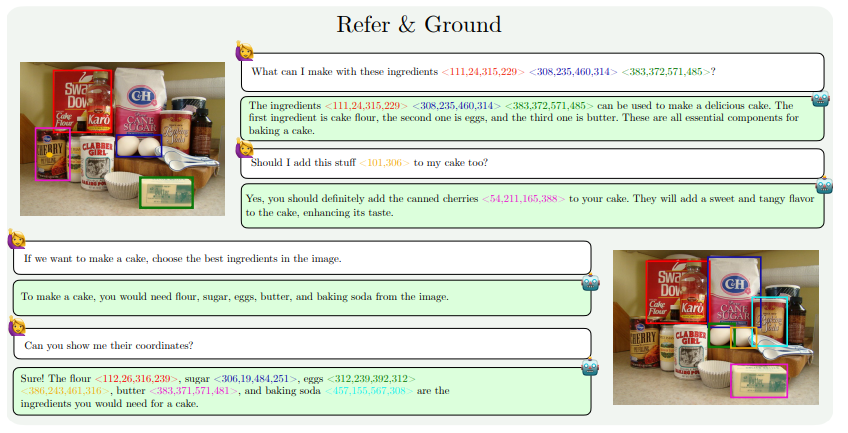

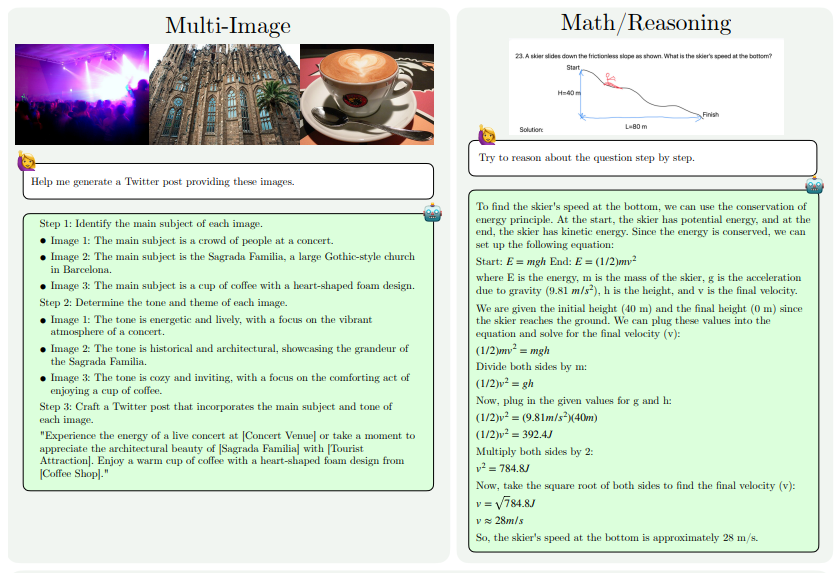

Улучшения возможностей MM1.5 в основном отражены в следующих аспектах: понимание текстовых изображений, визуальная привязка и позиционирование, анализ нескольких изображений, понимание видео и понимание мобильного пользовательского интерфейса. Эти возможности позволяют применять MM1.5 к более широкому спектру сценариев, таких как идентификация исполнителей и инструментов по концертным фотографиям, понимание данных диаграммы и ответы на соответствующие вопросы, обнаружение конкретных объектов в сложных сценах и т. д.

Чтобы оценить производительность MM1.5, исследователи сравнили его с другими продвинутыми мультимодальными моделями. Результаты показывают, что MM1.5-1B хорошо работает в модели с масштабом в 1 миллиард параметров, значительно лучше, чем другие модели того же уровня. MM1.5-3B превосходит MiniCPM-V2.0 и находится на одном уровне с InternVL2 и Phi-3-Vision. Кроме того, исследование также показало, что независимо от того, является ли это плотной моделью или моделью MoE, производительность значительно улучшится по мере увеличения масштаба.

Успех MM1.5 не только отражает сильные стороны исследований и разработок Apple в области искусственного интеллекта, но и указывает путь для будущего развития мультимодальных моделей. За счет оптимизации методов обработки данных и архитектуры моделей даже модели меньшего масштаба могут достичь высокой производительности, что имеет большое значение для развертывания высокопроизводительных моделей ИИ на устройствах с ограниченными ресурсами.

Адрес статьи: https://arxiv.org/pdf/2409.20566.

В целом, выпуск MM1.5 знаменует собой значительный прогресс в технологии мультимодального искусственного интеллекта. Его инновации в обработке данных и архитектуре моделей открывают новые идеи и направления для разработки будущих моделей ИИ. Мы с нетерпением ожидаем, что Apple продолжит добиваться новых прорывных результатов в области искусственного интеллекта.