Редактор Downcodes познакомит вас с последними открытиями мета-исследователей! Они использовали модель Трансформера для преодоления давней нерешенной проблемы в области динамических систем — нахождения глобальной функции Ляпунова. Это исследование не только демонстрирует мощные возможности крупномасштабных языковых моделей в сложных математических рассуждениях, но, что более важно, оно предлагает инновационный метод «обратной генерации», который эффективно решает проблему недостаточности обучающих данных и открывает путь для ИИ в научных открытиях. Применение в нем открыло новые возможности. Результаты исследования опубликованы на arXiv, указан адрес статьи.

Большие языковые модели хорошо справляются со многими задачами, но их логические способности вызывают споры. Исследователи из Meta недавно опубликовали статью, показывающую, как они используют модель Трансформера для решения давней математической проблемы: открытия глобальной функции Ляпунова динамической системы.

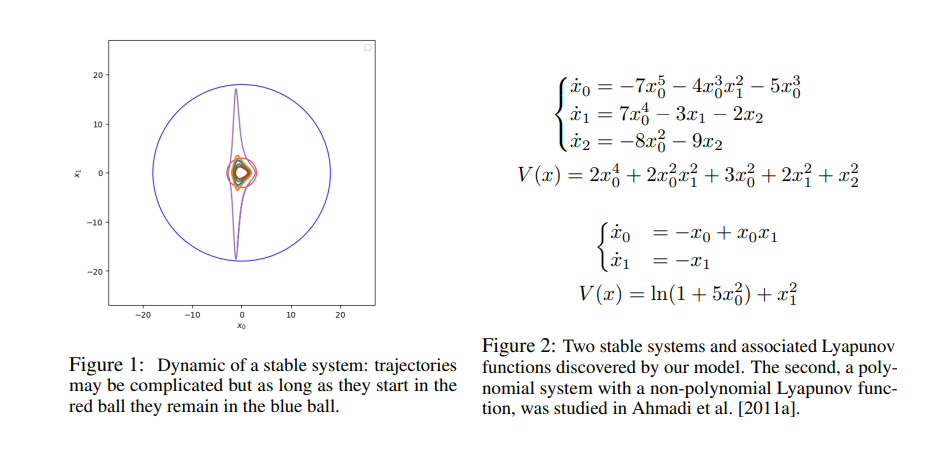

Функция Ляпунова может определить, устойчива ли динамическая система. Например, ее можно использовать для прогнозирования долгосрочной устойчивости задачи трех тел, то есть долгосрочной траектории трех небесных тел под действием силы тяжести. . Однако общего метода вывода функции Ляпунова пока не найдено, а соответствующая ей функция известна лишь для немногих систем.

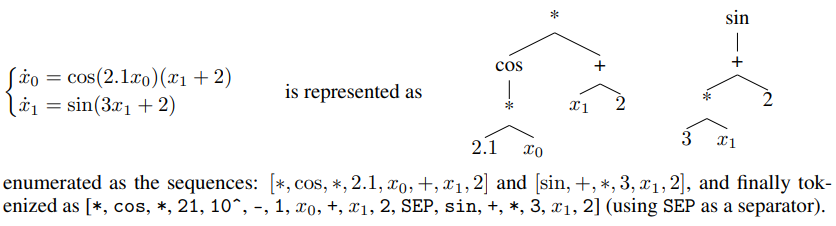

Чтобы решить эту проблему, исследователи из Meta обучили модель Трансформатора последовательность-последовательность для прогнозирования функции Ляпунова данной системы. Они новаторски использовали подход «обратной генерации» для создания большого набора обучающих данных, содержащего стабильные динамические системы и соответствующие им функции Ляпунова.

Традиционный метод «прямой генерации» начинается со случайно сгенерированной системы и пытается вычислить ее функцию Ляпунова. Этот метод неэффективен и может обрабатывать только определенные типы простых систем. Метод «обратной генерации» сначала случайным образом генерирует функции Ляпунова, а затем строит соответствующую им устойчивую систему, тем самым обходя проблему вычисления функций Ляпунова и генерируя более разнообразные обучающие данные.

Исследователи обнаружили, что модель Transformer, обученная на наборе данных «обратной генерации», достигла почти идеальной точности на тестовом наборе (99%), а также показала хорошие результаты на тестовом наборе вне распределения (73%). Еще более удивительным является то, что, добавив в обучающую выборку небольшое количество (300) простых примеров «прямой генерации», точность модели можно дополнительно повысить до 84 %, что показывает, что даже небольшое количество известных решений может значительно повысить точность модели. Улучшить способность модели к обобщению.

Чтобы проверить способность модели обнаруживать новые функции Ляпунова, исследователи сгенерировали десятки тысяч случайных систем и использовали модель для прогнозирования. Результаты показывают, что модель в десять раз эффективнее находит функции Ляпунова в полиномиальных системах, чем современные методы, а также может находить функции Ляпунова в неполиномиальных системах, чего не может сделать ни один современный алгоритм. маленький.

Исследователи также сравнили модель с людьми-математиками. Они пригласили 25 студентов-математиков провести тест, и результаты показали, что точность модели намного выше, чем у людей.

Это исследование показывает, что модели Transformer можно обучить решению сложных математических задач и что методы «обратной генерации» могут эффективно создавать наборы обучающих данных, которые преодолевают ограничения традиционных методов. В будущем исследователи планируют применить этот метод к другим математическим задачам и изучить больше возможностей ИИ в научных открытиях.

Адрес статьи: https://arxiv.org/pdf/2410.08304.

В целом, исследования Меты предоставляют ИИ новые идеи и методы для решения сложных научных проблем, а также указывают на то, что ИИ будет играть все более важную роль в области научных исследований. Редактор Downcodes продолжит обращать внимание на последние разработки в области искусственного интеллекта и предлагать читателям еще больше интересных репортажей!