Недавно редактор Downcodes обратил внимание на тревожную новость: было обнаружено, что широко используемый в медицинской отрасли инструмент транскрипции ИИ, основанный на технологии OpenAI Whisper, обладает «галлюцинациями» и может генерировать ложный контент. Это вызвало обеспокоенность по поводу безопасности и надежности технологий искусственного интеллекта в медицинской сфере. В этой статье будет подробно проанализирован этот инцидент, изучены его потенциальные риски и реакция OpenAI.

В последнее время в медицинской отрасли приобрел популярность инструмент транскрипции ИИ, основанный на технологии OpenAI Whisper. Многие врачи и медицинские организации используют этот инструмент для записи и обобщения обращений пациентов.

Согласно отчету ABC News, исследователи обнаружили, что этот инструмент может в некоторых случаях вызывать «галлюцинации», а иногда даже полностью фабриковать контент.

Инструмент транскрипции, разработанный компанией Nabla, успешно расшифровал более 7 миллионов медицинских разговоров и в настоящее время используется более чем 30 000 врачей и 40 системами здравоохранения. Тем не менее, Набла осознает, что у Уиспер могут быть галлюцинации, и говорит, что работает над решением этой проблемы.

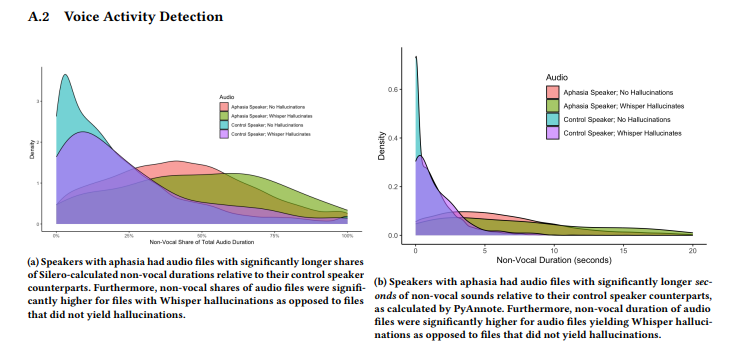

Исследование, проведенное группой исследователей из Корнеллского университета, Вашингтонского университета и других, показало, что Whisper галлюцинирует примерно в 1% своих транскрипций. В этих случаях инструмент случайным образом генерирует бессмысленные фразы во время молчания записи, иногда выражающие бурные эмоции. Исследователи собрали образцы аудио из AphasiaBank TalkBank и отметили, что тишина особенно распространена, когда говорят люди с нарушениями речи.

Исследователь Корнеллского университета Эллисон Кенеке поделилась в социальных сетях некоторыми примерами галлюцинаторного контента, созданного Whisper. Исследователи обнаружили, что контент, созданный с помощью инструмента, также включал вымышленные медицинские термины и даже фразы типа «Спасибо за просмотр!», которые звучали как слова из видеороликов на YouTube.

Исследование было представлено на конференции FAccT Ассоциации вычислительной техники в Бразилии в июне, но неясно, прошло ли оно рецензирование. Что касается этой проблемы, представитель OpenAI Тая Кристиансон заявила в интервью The Verge, что они очень серьезно относятся к этой проблеме и будут продолжать усердно работать над ее улучшением, особенно в области уменьшения галлюцинаций. В то же время она упомянула, что при использовании Whisper на их платформе API существуют четкие политики использования, запрещающие использование этого инструмента в определенных средах принятия решений с высокими ставками.

Выделять:

Инструмент транскрипции шепота широко используется в медицинской отрасли и записал 7 миллионов медицинских разговоров.

⚠️ Исследования показали, что Whisper «галлюцинирует» примерно в 1% транскрипций, иногда создавая бессмысленный контент.

OpenAI заявляет, что работает над улучшением производительности инструмента, особенно над уменьшением галлюцинаций.

В целом, технология искусственного интеллекта имеет широкие перспективы применения в медицинской сфере, но также сталкивается со многими проблемами. Появление феномена «галлюцинации» Уиспера напоминает нам о том, что нам необходимо относиться к технологии искусственного интеллекта с осторожностью и усилить надзор за ее безопасностью и надежностью, чтобы обеспечить ее безопасное и эффективное применение в медицинской сфере и защитить права и безопасность пациентов. Редактор Downcodes продолжит обращать внимание на дальнейшее развитие этого инцидента.