Природа «черного ящика» больших языковых моделей (LLM) всегда была важной проблемой в области искусственного интеллекта. Неинтерпретируемость результатов модели затрудняет гарантию ее надежности и достоверности. Чтобы решить эту проблему, OpenAI запустила новую технологию под названием Prover-Verifier Games (PVG), целью которой является улучшение интерпретируемости и проверяемости результатов LLM. Редактор Downcodes подробно объяснит вам эту технологию.

OpenAI недавно выпустила новую технологию под названием Prover-Verifier Games (PVG), целью которой является решение проблемы «черного ящика» вывода моделей искусственного интеллекта.

Представьте, что у вас есть сверхразумный помощник, но его мыслительный процесс подобен черному ящику, и вы понятия не имеете, как он приходит к своим выводам. Это звучит немного непросто? Да, с этой проблемой в настоящее время сталкиваются многие модели больших языков (LLM). Несмотря на свою мощь, точность генерируемого ими контента трудно проверить.

URL-адрес статьи: https://cdn.openai.com/prover-verifier-games-improve-legibility-of-llm-outputs/legibility.pdf.

Чтобы решить эту проблему, OpenAI запустила технологию PVG. Проще говоря, это значит позволить маленьким моделям (таким как GPT-3) контролировать вывод больших моделей (таких как GPT-4). Это похоже на игру. Проверяющий отвечает за создание контента, а Верификатор отвечает за определение правильности содержимого. Звучит интересно?

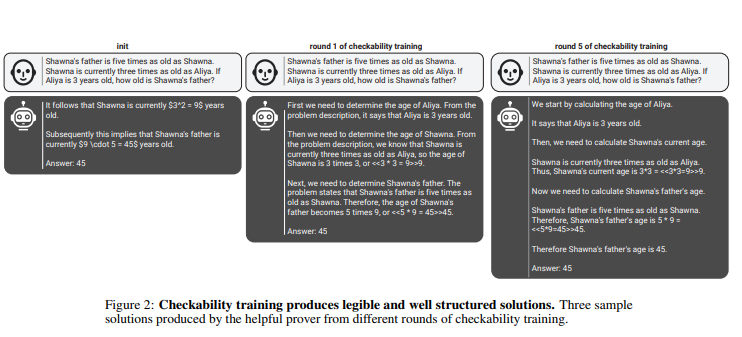

Согласно этому правилу, испытатели и проверяющие постоянно совершенствуют свои способности посредством нескольких раундов итеративного обучения. Верификаторы используют контролируемое обучение для прогнозирования правильности контента, а проверяющие используют обучение с подкреплением для оптимизации генерируемого ими контента. Еще более интересно то, что существует два типа доказывающих: полезные доказывающие и хитрые доказывающие. Полезные доказывающие стремятся создать правильный и убедительный контент, в то время как искусные доказывающие пытаются создать неправильный, но столь же убедительный контент, тем самым оспаривая суждение проверяющего.

penAI подчеркивает, что для обучения эффективной модели верификатора необходим большой объем реальных и точных данных этикетки для улучшения ее возможностей распознавания. В противном случае, даже если используется технология PVG, проверенный контент все равно может подвергаться риску незаконного вывода.

Выделять:

? Технология PVG решает проблему «черного ящика» ИИ, сверяя выходные данные больших моделей с маленькими.

? Система обучения основана на теории игр и моделирует взаимодействие между доказывающим и проверяющим, повышая точность и управляемость результатов модели.

? Для обучения модели верификатора требуется большой объем реальных данных, чтобы обеспечить достаточную оценку и надежность.

В целом, технология PVG OpenAI предлагает новую идею решения проблемы «черного ящика» моделей искусственного интеллекта, но ее эффективность по-прежнему зависит от высококачественных обучающих данных. Стоит с нетерпением ждать дальнейшего развития этой технологии, поскольку она будет способствовать развитию моделей искусственного интеллекта в более надежном, объяснимом и заслуживающем доверия направлении. Редактор Downcodes надеется на появление новых подобных инновационных технологий.