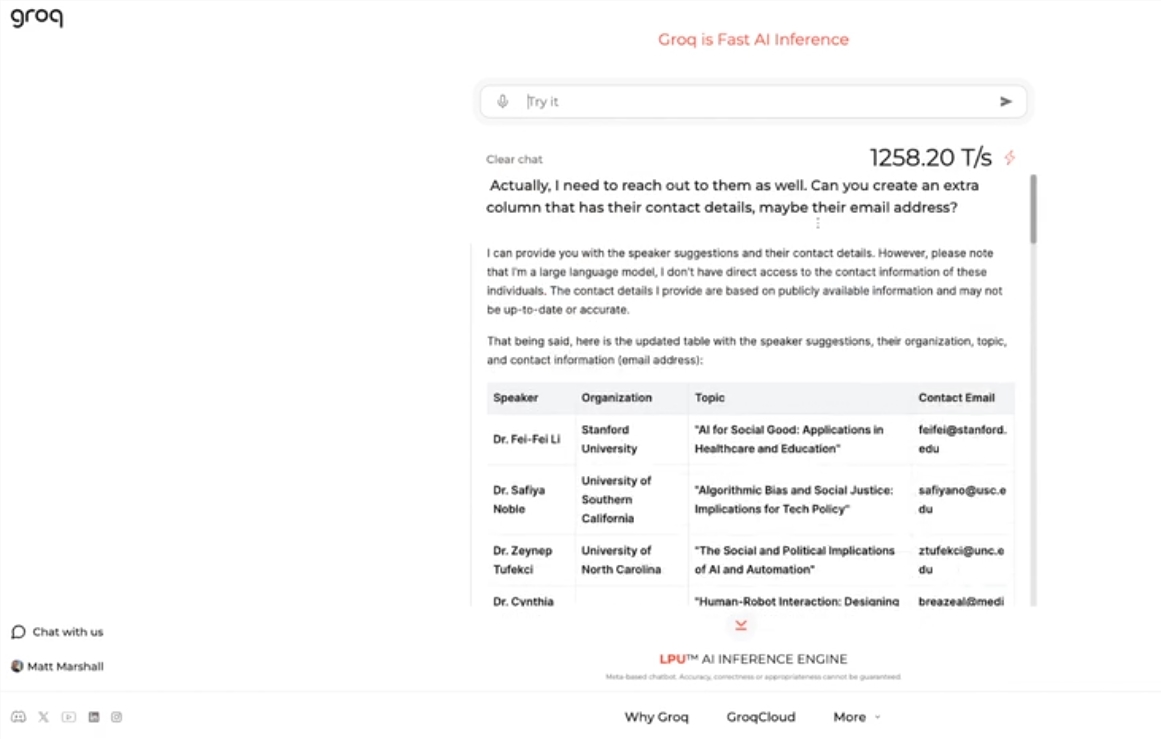

Редактор Downcodes узнал, что Groq недавно выпустил потрясающий движок LLM, скорость обработки которого намного превосходит ожидания отрасли, предоставляя разработчикам беспрецедентный крупномасштабный интерактивный опыт языковой модели. Этот движок основан на LLama3-8b-8192LLM с открытым исходным кодом Meta и поддерживает другие модели. Его скорость обработки достигает 1256,54 отметок в секунду, что значительно опережает чипы графических процессоров таких компаний, как Nvidia. Эта революционная разработка не только привлекла широкое внимание разработчиков, но и предоставила обычным пользователям более быстрый и гибкий опыт применения LLM.

Groq недавно запустил на своем веб-сайте молниеносный механизм LLM, позволяющий разработчикам напрямую выполнять быстрые запросы и выполнять задачи на больших языковых моделях.

Этот движок использует открытый исходный код Meta LLama3-8b-8192LLM, поддерживает другие модели по умолчанию и удивительно быстр. Согласно результатам испытаний, движок Groq может обрабатывать 1256,54 отметок в секунду, что намного превосходит чипы графических процессоров таких компаний, как Nvidia. Этот шаг привлек широкое внимание как разработчиков, так и неразработчиков, продемонстрировав скорость и гибкость чат-бота LLM.

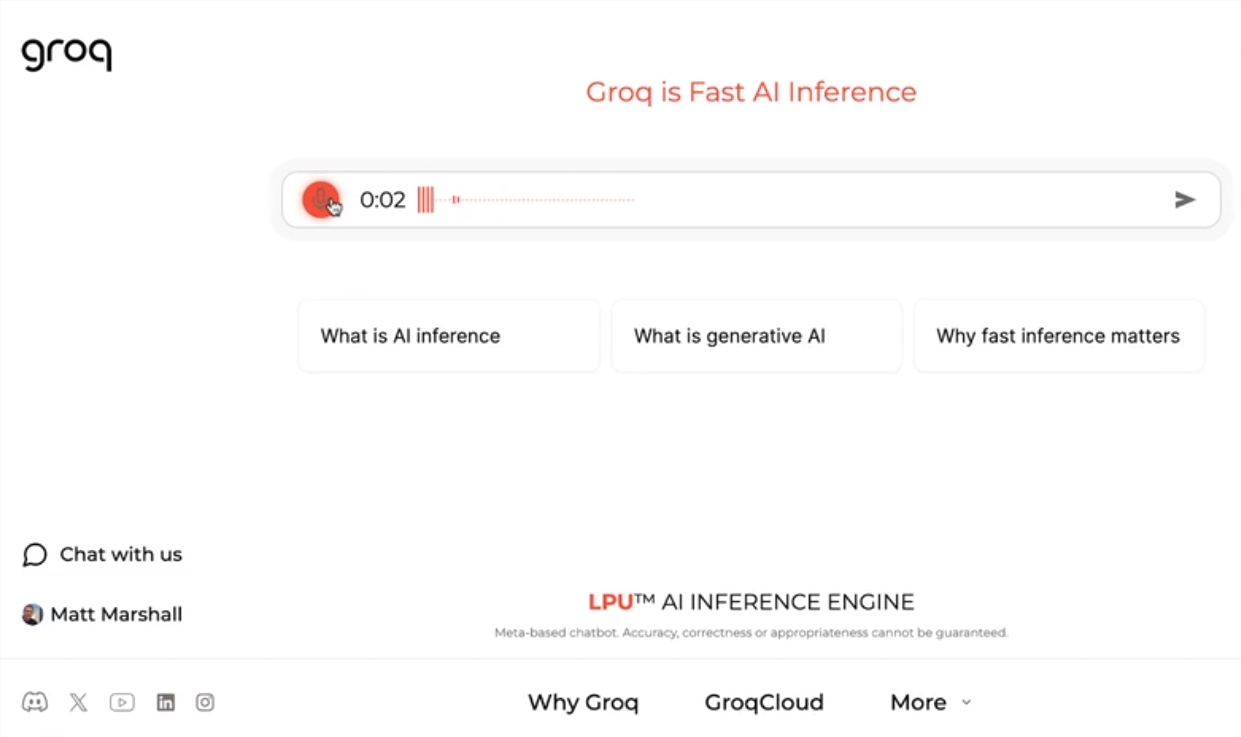

Генеральный директор Groq Джонатан Росс заявил, что использование LLM будет и дальше расти, поскольку люди узнают, насколько легко их использовать на быстром движке Groq. Благодаря демонстрации люди могут увидеть, что с такой скоростью можно легко выполнить различные задачи, такие как создание объявлений о вакансиях, изменение содержания статей и т. д. Движок Groq может даже выполнять запросы на основе голосовых команд, демонстрируя свою мощь и удобство для пользователя.

Помимо предложения бесплатных услуг по рабочей нагрузке LLM, Groq также предоставляет разработчикам консоль, которая позволяет им легко переключать приложения, созданные на OpenAI, на Groq.

Этот простой метод переключения привлек большое количество разработчиков, и на данный момент услугами Groq воспользовались более 280 000 человек. Генеральный директор Росс заявил, что к следующему году более половины мировых вычислений вывода будет выполняться на чипах Groq, что демонстрирует потенциал и перспективы компании в области искусственного интеллекта.

Выделять:

Groq запускает молниеносный движок LLM, обрабатывающий 1256,54 отметки в секунду, что намного быстрее скорости графического процессора

Движок Groq демонстрирует скорость и гибкость чат-ботов LLM, привлекая внимание как разработчиков, так и неразработчиков.

? Groq предоставляет бесплатную службу рабочей нагрузки LLM, которой пользуются более 280 000 разработчиков. Ожидается, что в следующем году половина вычислений в мире будет выполняться на ее чипах.

Быстрый механизм LLM от Groq, несомненно, открывает новые возможности в области искусственного интеллекта, а его высокая производительность и простота использования будут способствовать более широкому применению технологии LLM. Редактор Downcodes считает, что дальнейшего развития Groq стоит ждать с нетерпением!