Редактор Даункодов даст вам глубокое понимание секретов модели Трансформера! Недавно статья под названием «Слои-трансформеры как художники» ярко объяснила механизм работы среднего слоя модели «Трансформер» с точки зрения «художника». С помощью умных метафор и экспериментов эта статья показывает, как работает иерархия Трансформеров, предлагая нам новые идеи для понимания внутренних операций больших языковых моделей. В статье автор сравнивает каждый слой Трансформера с художником, работающим вместе над созданием грандиозной языковой картины, и проверяет это мнение с помощью серии экспериментов.

В мире искусственного интеллекта существует особая группа художников — иерархическая структура в модели Трансформера. Они подобны волшебным кистям, рисующим красочный мир на холсте языка. Недавно статья под названием «Слои-трансформеры как художники» открыла нам новую перспективу для понимания механизма работы среднего слоя-трансформера.

Модель трансформера, как самая популярная в настоящее время крупномасштабная языковая модель, имеет миллиарды параметров. Каждый его слой подобен художнику, работающему вместе, чтобы завершить грандиозную языковую картину. Но как эти художники работали вместе? Чем различались кисти и краски, которые они использовали? Эта статья пытается ответить на эти вопросы.

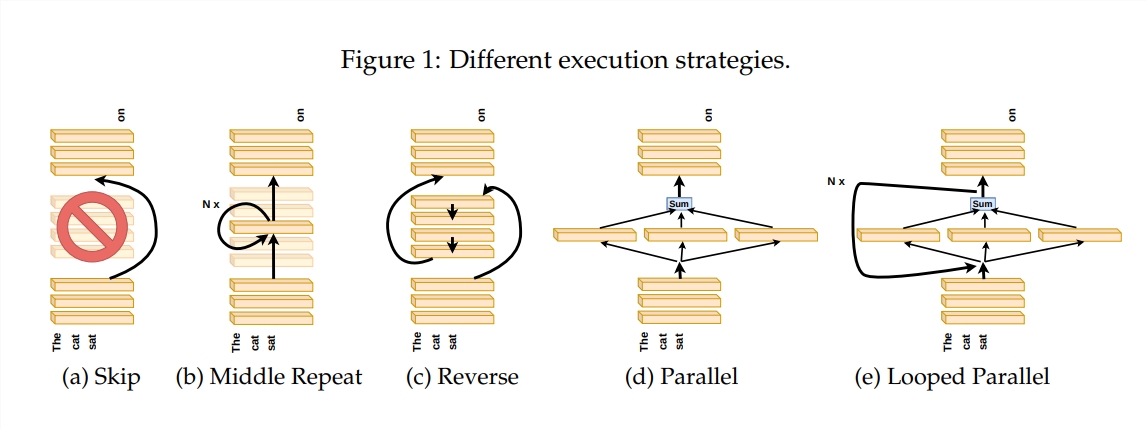

Чтобы изучить, как работает слой «Трансформер», автор разработал серию экспериментов, включая пропуск определенных слоев, изменение порядка слоев или параллельное выполнение слоев. Эти эксперименты подобны установлению различных правил рисования для художников, чтобы посмотреть, смогут ли они адаптироваться.

В метафоре «конвейера художника» ввод рассматривается как холст, а процесс прохождения через промежуточные слои подобен прохождению холста на сборочной линии. Каждый «художник», то есть каждый слой Трансформера, модифицирует картину в соответствии со своими знаниями. Эта аналогия помогает нам понять параллелизм и масштабируемость слоя Transformer.

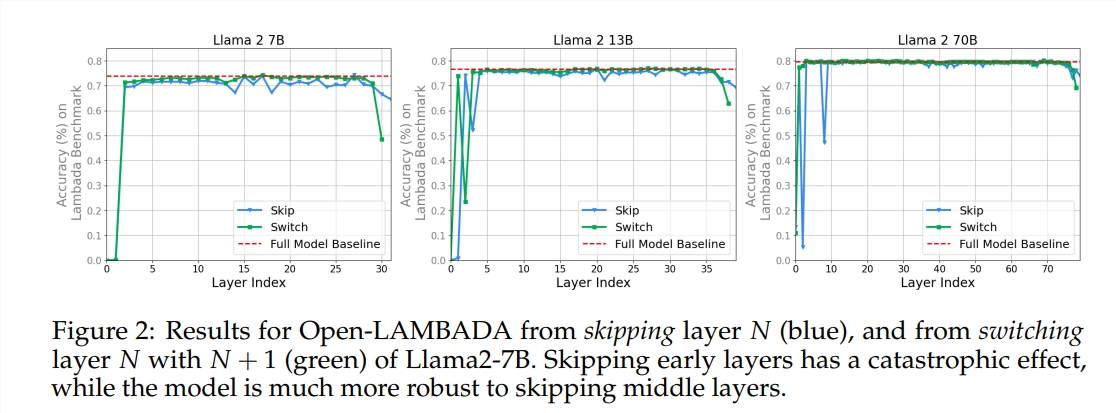

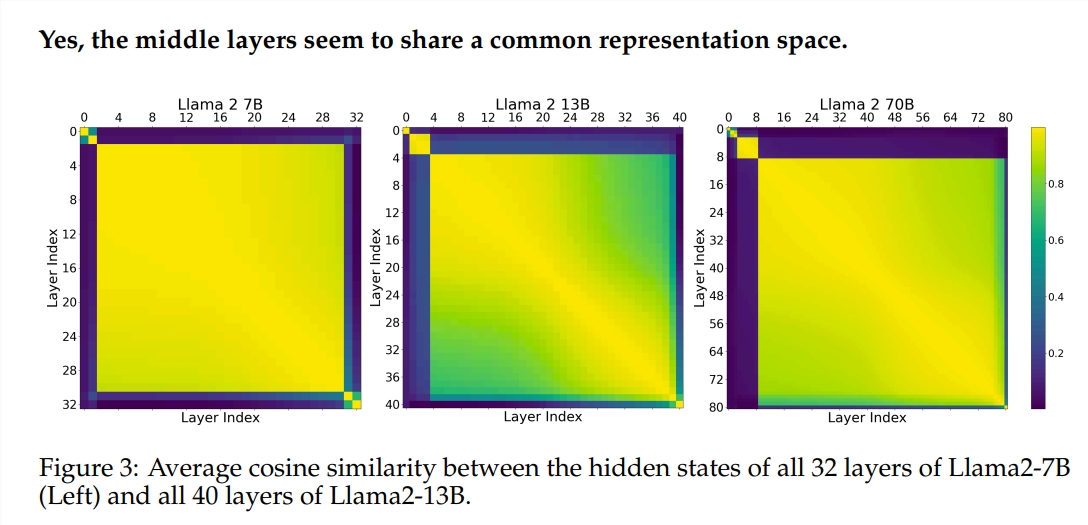

В эксперименте использовались две предварительно обученные модели большого языка (LLM): Llama2-7B и BERT. Исследование показало, что художники на средних уровнях, похоже, использовали общую коробку с красками, представляющую пространство, отличную от художников на первом и последнем уровнях. Художники, пропускающие определенные промежуточные слои, мало влияют на всю картину, а это указывает на то, что не все художники требуются.

Хотя художники среднего слоя используют одну и ту же коробку с красками, они используют свои собственные навыки, чтобы нарисовать на холсте разные узоры. Если вы просто повторно используете технику определенного художника, картина потеряет свое первоначальное очарование.

Порядок рисования особенно важен для математических и логических задач, требующих строгой логики. Для задач, которые полагаются на семантическое понимание, влияние порядка относительно невелико.

Результаты исследования показывают, что средний слой Трансформера имеет определенную степень согласованности, но не является избыточным. Для математических и логических задач порядок слоев более важен, чем для семантических задач.

Исследование также показало, что не все слои необходимы и что промежуточные слои можно пропустить, не оказывая катастрофического влияния на производительность модели. Более того, хотя промежуточные уровни используют одно и то же пространство представления, они выполняют разные функции. Изменение порядка выполнения слоев привело к снижению производительности, что указывает на то, что порядок оказывает важное влияние на производительность модели.

На пути к изучению модели Трансформера многие исследователи пытаются ее оптимизировать, включая обрезку, уменьшение параметров и т. д. Эти работы дают ценный опыт и вдохновение для понимания модели Трансформера.

Адрес статьи: https://arxiv.org/pdf/2407.09298v1.

В целом, эта статья открывает нам новую перспективу для понимания внутреннего механизма модели Трансформера и предлагает новые идеи для будущей оптимизации модели. Редактор Downcodes рекомендует заинтересованным читателям прочитать статью полностью, чтобы глубже понять тайны модели Трансформера!