В последнее время модель искусственного интеллекта с открытым исходным кодом Reflection70B привлекла широкое внимание в отрасли из-за противоречий в ее производительности. Модель была выпущена компанией HyperWrite, которая первоначально заявляла, что она является самой мощной в мире моделью с открытым исходным кодом, и привлекла большое внимание благодаря отличным характеристикам в сторонних тестах. Однако некоторые независимые учреждения и пользователи впоследствии усомнились в его эффективности, а результаты испытаний значительно отличались от первоначальных заявлений HyperWrite.

Модель искусственного интеллекта с открытым исходным кодом Reflection70B, которая только что дебютировала, недавно вызвала широкие сомнения в отрасли.

Эта модель, выпущенная нью-йоркским стартапом HyperWrite, которая утверждает, что является вариантом Llama3.1 от Meta, привлекла внимание благодаря отличным характеристикам в сторонних тестах. Однако после публикации некоторых результатов испытаний репутация Reflection70B начала подвергаться сомнению.

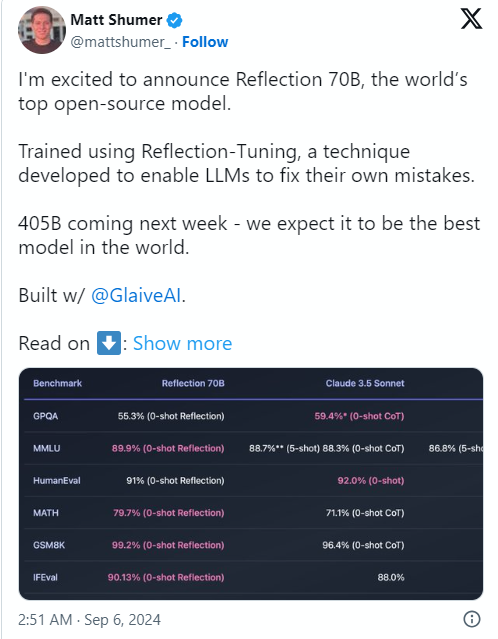

Причиной всему стало то, что соучредитель и генеральный директор HyperWrite Мэтт Шумер 6 сентября анонсировал Reflection70B в социальной сети X и уверенно назвал ее «самой сильной в мире моделью с открытым исходным кодом».

Шумер также рассказал о технологии «рефлексивной настройки» модели, заявив, что этот метод позволяет модели проверять себя перед созданием контента, тем самым повышая точность.

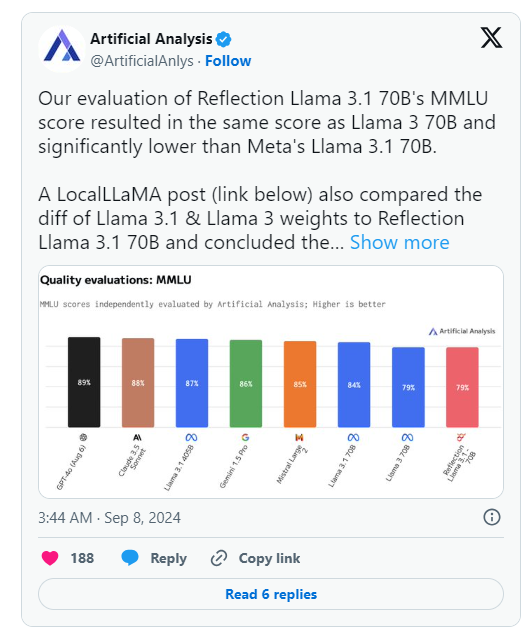

Однако на следующий день после анонса HyperWrite группа Artificial Analysis, которая специализируется на «независимом анализе моделей искусственного интеллекта и хостинг-провайдеров», опубликовала свой собственный анализ X, отметив, что они оценили показатель MMLU (массовое многозадачное понимание языка) Reflection Llama3.170B. такой же, как у Llama370B, но значительно ниже, чем у Meta Llama3.170B, что существенно отличается от результатов, первоначально опубликованных HyperWrite/Shumer.

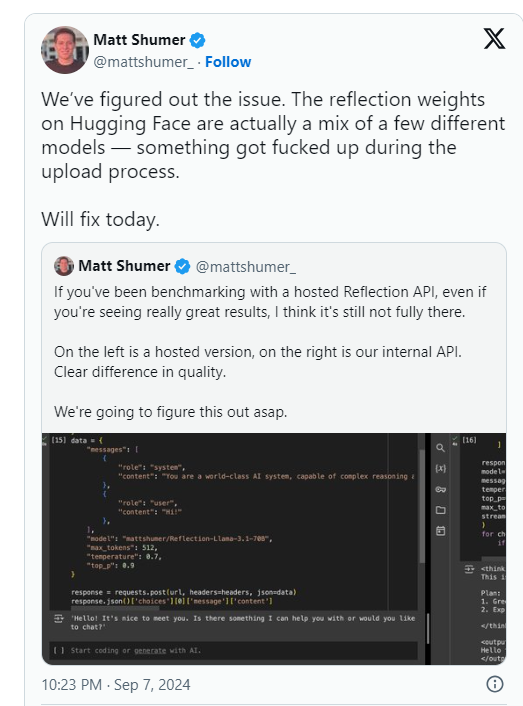

Позже Шумер заявил, что возникла проблема с весами Reflection70B (или настройками модели с открытым исходным кодом) во время загрузки в Hugging Face (сторонний репозиторий и компания по размещению кода AI), что могло привести к ухудшению производительности, чем у «внутреннего API» HyperWrite. "Версия. .

В последующем заявлении компании Artificial Analysis говорится, что они получили доступ к частному API и увидели впечатляющую производительность, но не на первоначально заявленном уровне. Поскольку этот тест проводился на частном API, они не смогли независимо проверить, что тестируют.

Группа подняла два ключевых вопроса, которые серьезно ставят под сомнение первоначальные заявления HyperWrite и Шумера о производительности:

Между тем, пользователи в многочисленных сообществах машинного обучения и искусственного интеллекта на Reddit также подвергли сомнению заявленную производительность и происхождение Reflection70B. Некоторые отмечают , что Reflection70B является вариантом Llama3, а не Llama-3.1 , основываясь на сравнении моделей, опубликованном третьей стороной на Github, что ставит под сомнение первоначальные заявления Шумера и HyperWrite.

В результате по крайней мере один пользователь X, Шин Мегами Бозон, опубликовал сообщение 8 сентября по восточноевропейскому времени.

В 20:07 по восточному времени Шумер публично обвинил Шумера в «мошенническом поведении» в исследовательском сообществе ИИ и опубликовал длинный список скриншотов и других доказательств.

Другие утверждали, что модель на самом деле представляет собой «оболочку» или приложение, созданное на базе проприетарного конкурента Anthropic с закрытым исходным кодом Claude3.

Тем не менее, другие пользователи X встали на защиту Shumer и Reflection70B, причем некоторые из них также продемонстрировали впечатляющую производительность своей модели.

В настоящее время сообщество исследователей искусственного интеллекта ожидает ответа Шумера на эти обвинения в мошенничестве и обновленного веса моделей на Hugging Face.

После выпуска модели Reflection70B ее производительность была поставлена под сомнение, поскольку результаты испытаний не подтвердили первоначальные заявления.

⚙️ Основатель HyperWrite объяснил, что проблемы с загрузкой модели привели к снижению производительности, и призвал обратить внимание на обновленную версию.

Модель горячо обсуждалась в социальных сетях, вперемешку с обвинениями и защитой.

В настоящее время инцидент с Reflection70B все еще продолжает развиваться, и окончательный результат все еще требует дальнейшего расследования и реагирования. Этот инцидент также напоминает нам о том, что мы должны быть осторожны при повышении производительности любой модели ИИ и полагаться на результаты независимых проверок для вынесения суждений.