Недавно пользовательский опыт чат-бота Anthropic Claude с искусственным интеллектом вызвал бурные дискуссии. На Reddit появилось большое количество отзывов пользователей, в которых говорилось, что производительность Клода снизилась, что особенно проявляется в потере памяти и снижении способностей к кодированию. Этот инцидент вызвал широкие дискуссии об оценке производительности и пользовательском опыте больших языковых моделей и еще раз подчеркнул проблемы, с которыми сталкиваются компании, занимающиеся искусственным интеллектом, при поддержании стабильности моделей.

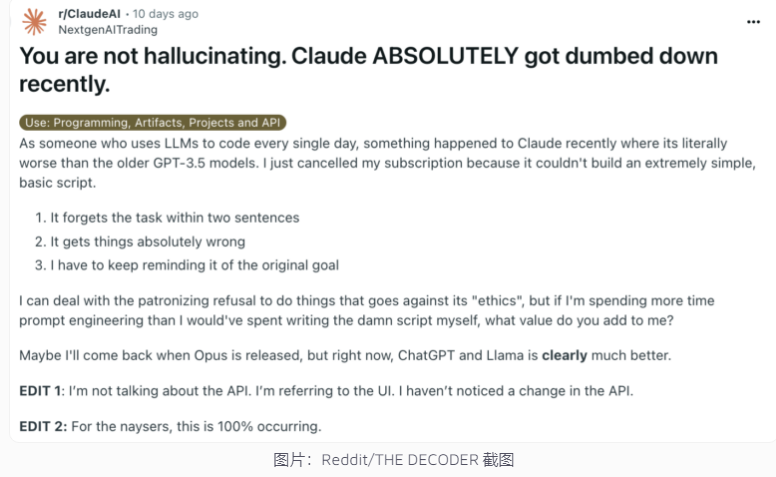

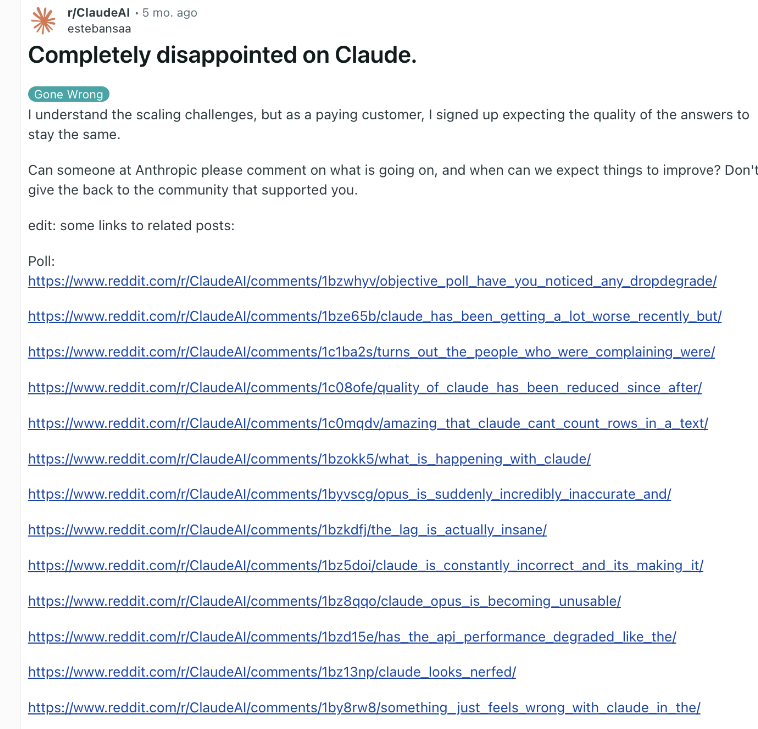

Недавно чат-бот Anthropic с искусственным интеллектом Клод снова оказался вовлечен в спор о производительности. Сообщение на Reddit, в котором утверждалось, что Клод стал намного глупее, недавно привлекло широкое внимание: многие пользователи сообщили, что у них наблюдалось снижение способностей Клода, включая потерю памяти и снижение способностей к программированию.

В ответ исполнительный директор Anthropic Алекс Альберт ответил, что расследование компании не выявило каких-либо общих проблем, и подтвердил, что в модель Claude3.5Sonnet или конвейер вывода не было внесено никаких изменений. Для повышения прозрачности Anthropic опубликовала на своем официальном сайте системные подсказки модели Клода.

Это не первый случай, когда пользователи сообщают о деградации ИИ, и компания это отрицает. В конце 2023 года ChatGPT OpenAI также столкнулся с аналогичными сомнениями. По мнению инсайдеров отрасли, причинами этого явления могут быть: растущие с течением времени ожидания пользователей, естественные изменения в результатах искусственного интеллекта, временные ограничения вычислительных ресурсов и т. д.

Однако эти факторы могут по-прежнему приводить к ухудшению производительности, воспринимаемому пользователем, даже если базовая модель не претерпевает существенных изменений. OpenAI однажды отметила, что поведение ИИ само по себе непредсказуемо, а поддержание и оценка производительности крупномасштабного генеративного ИИ является огромной проблемой.

Anthropic заявила, что продолжит обращать внимание на отзывы пользователей и усердно работать над улучшением стабильности производительности Claude. Этот инцидент подчеркивает проблемы, с которыми сталкиваются компании, занимающиеся ИИ, при обеспечении согласованности моделей, а также важность повышения прозрачности в оценке производительности ИИ и коммуникации.

Споры о производительности Клода отражают сложность разработки и развертывания больших языковых моделей, а также разрыв между ожиданиями пользователей и реальными приложениями. В будущем компаниям, занимающимся искусственным интеллектом, необходимо и дальше повышать стабильность моделей и поддерживать более эффективное общение с пользователями, чтобы гарантировать, что технология искусственного интеллекта сможет продолжать надежно предоставлять услуги пользователям.