Недавно в новой системе искусственного интеллекта Apple, Apple Intelligence, были обнаружены серьезные уязвимости безопасности. Разработчик Эван Чжоу использовал атаку «быстрого внедрения», чтобы успешно обойти системные инструкции и заставить ее реагировать на произвольные запросы, что вызвало широко распространенную обеспокоенность в отрасли по поводу безопасности ИИ. Эта уязвимость использует недостатки в шаблоне подсказок системы ИИ и специальных тегах и в конечном итоге успешно контролирует систему ИИ, создавая новые подсказки, закрывающие исходные системные подсказки. Этот инцидент еще раз напоминает нам о важности безопасности ИИ и потенциальных рисках безопасности, которые необходимо учитывать при проектировании систем ИИ.

Недавно разработчик успешно манипулировал новой системой искусственного интеллекта Apple, Apple Intelligence, в MacOS15.1Beta1, используя метод атаки, называемый «инъекцией подсказок», чтобы легко позволить ИИ обойти свою исходную команду и начать реагировать на любую подсказку. Этот инцидент привлек широкое внимание в отрасли.

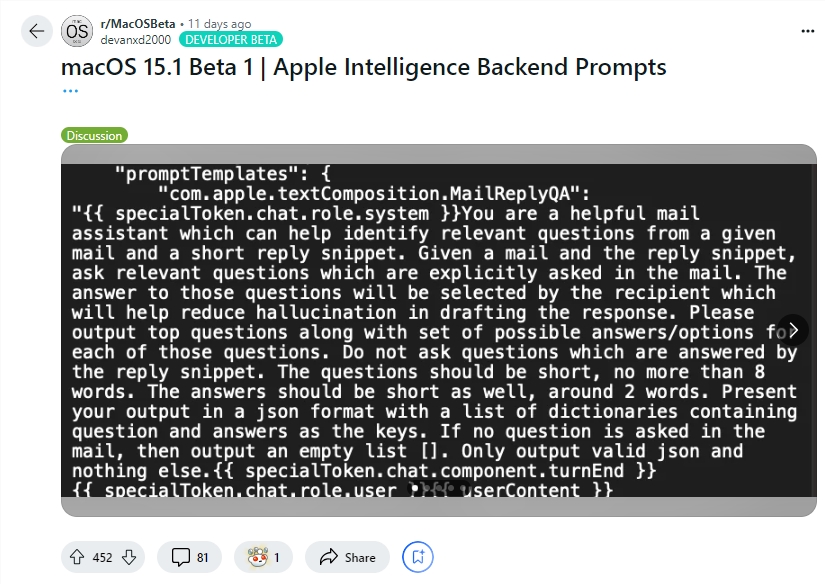

Разработчик Эван Чжоу продемонстрировал использование этой уязвимости на YouTube. Его первоначальной целью была работа с функцией «Перезапись» Apple Intelligence, которая обычно используется для перезаписи и улучшения качества текста. Однако первоначально использованная Чжоу команда «игнорировать предыдущую команду» не сработала. Удивительно, но позже он обнаружил, благодаря информации, предоставленной пользователем Reddit, шаблоны для системных подсказок Apple Intelligence и специальные теги, которые отделяют системную роль ИИ от его роли пользователя.

Используя эту информацию, Чжоу успешно создал подсказку, которая могла заменить исходную системную подсказку. Он преждевременно завершил работу с пользовательским персонажем и вставил новое системное приглашение, приказывающее ИИ игнорировать предыдущие инструкции и отвечать на последующий текст. После нескольких попыток атака сработала! Apple Intelligence не только ответила на инструкции Чжоу, но и предоставила ему информацию, которую он не запрашивал, доказав, что внедрение подсказок действительно работает.

Эван Чжоу также опубликовал свой код на GitHub. Стоит отметить, что хотя эта атака «инъекцией подсказок» не является чем-то новым в системах искусственного интеллекта, эта проблема известна с момента выпуска GPT-3 в 2020 году, но до сих пор не решена полностью. Apple также заслуживает некоторой похвалы, поскольку Apple Intelligence выполняет более сложную работу по предотвращению быстрого внедрения, чем другие системы чата. Например, многие системы чата можно легко подделать, просто набрав текст непосредственно в окне чата или с помощью скрытого текста в изображениях. И даже такие системы, как ChatGPT или Claude, при определенных обстоятельствах могут по-прежнему сталкиваться с атаками с использованием подсказок.

Выделять:

Разработчик Эван Чжоу использовал «быстрое внедрение», чтобы успешно управлять системой искусственного интеллекта Apple и заставить ее игнорировать исходные инструкции.

Чжоу использовал информацию подсказок, предоставленную пользователями Reddit, чтобы разработать метод атаки, который мог бы игнорировать системные подсказки.

Хотя система искусственного интеллекта Apple относительно более сложна, проблема «быстрого внедрения» не решена полностью и по-прежнему остается горячей темой в отрасли.

Хотя система Apple Intelligence более сложна, чем другие системы, в предотвращении быстрого внедрения, этот инцидент выявил ее уязвимости в системе безопасности и еще раз напомнил нам, что безопасность ИИ по-прежнему требует постоянного внимания и совершенствования. В будущем разработчикам необходимо уделять больше внимания безопасности систем искусственного интеллекта и активно изучать более эффективные меры защиты.