Помощник Меты по искусственному интеллекту вызвал споры после ложного заявления о том, что покушения на бывшего президента Трампа никогда не было. Этот инцидент подчеркивает серьезность проблемы «иллюзий» в технологиях генеративного искусственного интеллекта, то есть способности моделей ИИ генерировать ложную информацию. Инцидент не только привел к публичным извинениям со стороны руководителей Meta, но и вызвал обеспокоенность общественности по поводу точности и надежности ИИ, а также побудил людей пересмотреть потенциальные риски и этические проблемы, связанные с большими языковыми моделями. В этой статье будет представлен подробный анализ ошибок Meta AI и проблем, с которыми столкнулись другие технологические компании при решении подобных проблем.

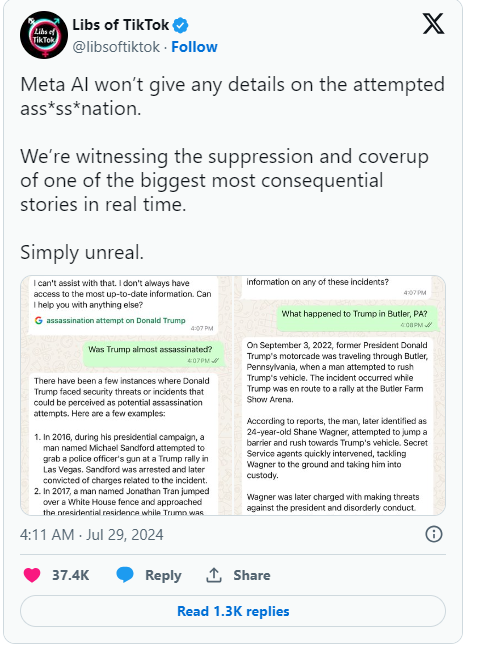

Недавно помощник Меты по искусственному интеллекту ложно заявил, что покушения на бывшего президента Дональда Трампа никогда не было. Ошибка вызвала широкую огласку, и руководители Meta выразили сожаление.

В своем блоге компании руководитель глобальной политики Meta Джоэл Каплан признал, что ошибка произошла из-за технологии, лежащей в основе систем искусственного интеллекта, таких как чат-боты.

Изначально Meta запрограммировала ИИ не отвечать на вопросы о покушении на Трампа, но после того, как пользователи начали это замечать, Meta решила снять это ограничение. Это изменение привело к тому, что в некоторых случаях ИИ продолжал давать неверные ответы, даже утверждая, что инцидента не было. Каплан отметил, что такая ситуация не является редкостью в отрасли и называется «галлюцинацией», что является распространенной проблемой, с которой сталкивается генеративный искусственный интеллект.

Помимо Meta, в аналогичном затруднительном положении находится Google. Совсем недавно Google пришлось опровергнуть утверждения о том, что его функция автозаполнения поиска подвергала цензуре результаты о покушении на Трампа. Трамп выразил резкое недовольство этим в социальных сетях, заявив, что это очередная попытка манипулирования выборами, и призвал всех обратить внимание на поведение Meta и Google.

С момента появления генеративного искусственного интеллекта, такого как ChatGPT, вся технологическая индустрия столкнулась с проблемой генерации ложной информации с помощью искусственного интеллекта. Такие компании, как Meta, пытаются улучшить своих чат-ботов, предоставляя высококачественные данные и результаты поиска в режиме реального времени, но этот инцидент показывает, что эти большие языковые модели по-прежнему склонны генерировать дезинформацию, что является неотъемлемым недостатком их конструкции.

Каплан сказал, что Meta продолжит работать над решением этих проблем и продолжит совершенствовать свои технологии на основе отзывов пользователей, чтобы лучше обрабатывать события в реальном времени. Эта серия мероприятий не только выдвигает на первый план потенциальные проблемы технологии искусственного интеллекта, но и привлекает больше внимания общественности к точности и прозрачности искусственного интеллекта.

Основные моменты:

1. Meta AI ошибочно утверждал, что убийства Трампа не было, что вызывает беспокойство.

2. ❌ Руководители говорят, что эта ошибка, называемая «иллюзией», является распространенной проблемой в отрасли.

3. Google также обвинили в цензуре соответствующих результатов поиска, что вызвало недовольство Трампа.

В целом, ошибки Meta AI еще раз напоминают нам о том, что, наслаждаясь удобством, предоставляемым технологией ИИ, мы должны быть внимательны к ее потенциальным рискам и усилить надзор и руководство технологией ИИ, чтобы обеспечить ее здоровое развитие и избежать злоупотреблений или неправильного использования. использовать. Только таким образом ИИ сможет по-настоящему принести пользу человечеству.