Новейшая модель Green Deep Learning RWKV-CLIP с открытым исходным кодом продемонстрировала высокие результаты в области обучения визуальному представлению языка благодаря инновационному дизайну, объединяющему архитектуру Transformer и RNN. Эта модель эффективно решает проблему зашумленных данных и значительно повышает надежность модели и производительность последующих задач за счет умелого сочетания двухбашенной архитектуры, модулей пространственного смешивания и смешивания каналов, а также разнообразной структуры генерации описаний. Он добился прорывного прогресса в сопоставлении и понимании текста и изображения, открыв новое направление для исследований и применения моделей визуального языка.

Гелингшентонг открыл исходный код модели RWKV-CLIP, которая представляет собой средство обучения визуальному представлению языка, сочетающее в себе преимущества Transformer и RNN. Модель значительно повышает производительность при выполнении визуальных и языковых задач за счет расширения набора данных с использованием пар изображение-текст, полученных с веб-сайтов с помощью задач предварительного обучения изображения и текста.

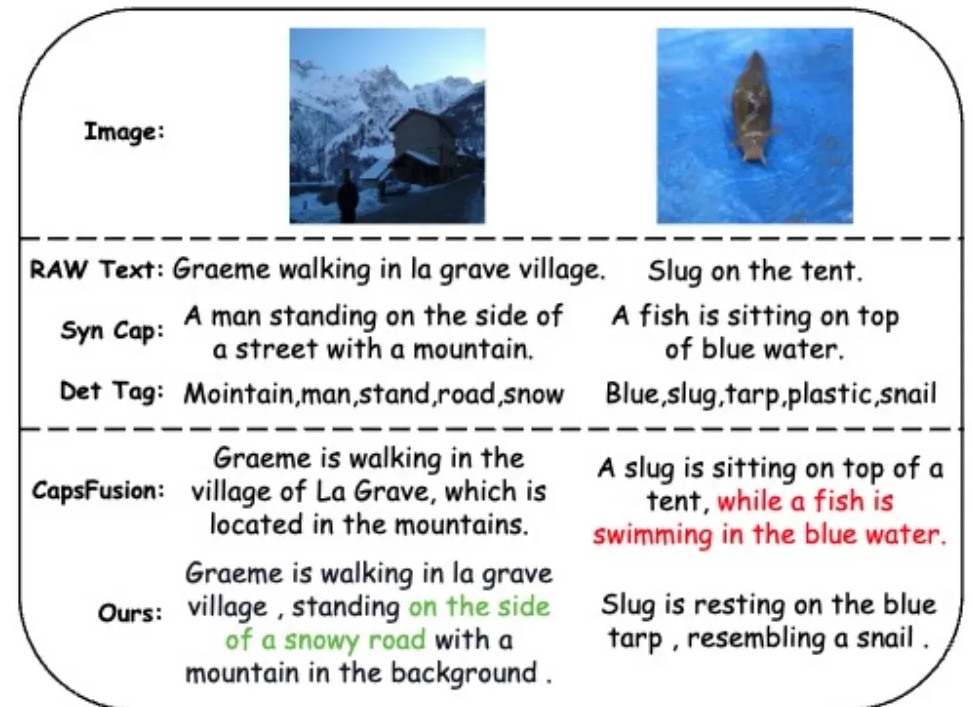

Чтобы решить проблему зашумленных данных и улучшить качество данных, исследовательская группа представила разнообразную структуру генерации описаний, которая использует большие языковые модели (LLM) для синтеза и уточнения контента из веб-текста, синтезированных субтитров и обнаруженных тегов.

Модель RWKV-CLIP использует двухбашенную архитектуру, объединяющую эффективное параллельное обучение Transformer и эффективный вывод RNN. Модель дополнена несколькими модулями пространственного и канального смешивания, которые обеспечивают глубокую обработку входных изображений и текста. На этапе пространственного смешивания модель использует механизм внимания для выполнения глобального расчета линейной сложности и усиления взаимодействия функций на уровне канала. Этап смешивания каналов дополнительно уточняет представление объектов. Что касается улучшения ввода, модель RWKV-CLIP повышает надежность модели за счет случайного выбора исходного текста, синтетических субтитров или сгенерированных описаний в качестве входного текста.

Результаты экспериментов показывают, что RWKV-CLIP обеспечивает высочайшую производительность при решении множества последующих задач, включая линейное обнаружение, нулевую классификацию и поиск текста изображения с нулевым кадром. По сравнению с базовой моделью RWKV-CLIP обеспечивает значительное улучшение производительности.

Кросс-модальный анализ модели RWKV-CLIP показывает, что ее изученные представления демонстрируют более четкую различимость в пределах одной и той же модальности и демонстрируют более близкие расстояния в пространстве модальностей изображения и текста, что указывает на перекрестную модальность. Лучшие характеристики выравнивания.

Адрес модели: https://wisemodel.cn/models/deepglint/RWKV-CLIP

В целом, модель RWKV-CLIP демонстрирует большой потенциал в области визуального языка, а ее открытый исходный код также предоставляет ценные ресурсы для соответствующих исследований. Заинтересованные разработчики могут посетить предоставленную ссылку, чтобы загрузить модель и провести дальнейшие исследования и применение.