Модели визуального языка (VLM) добились значительного прогресса в области искусственного интеллекта, но по-прежнему сталкиваются с проблемами при обработке изображений высокого разрешения и разнообразных текстов. Существующие модели часто используют статические визуальные кодеры, которые неэффективны и не обеспечивают точности работы с различными наборами данных. Отсутствие разнообразия и специфичности задач в наборе обучающих данных также ограничивает его производительность, особенно в специализированных задачах, таких как интерпретация графиков.

Благодаря быстрому развитию искусственного интеллекта интеграция визуальных и языковых возможностей привела к прорывному прогрессу в моделях визуального языка (VLM). Эти модели предназначены для одновременной обработки и понимания визуальных и текстовых данных и широко используются в таких сценариях, как описание изображений, визуальные ответы на вопросы, оптическое распознавание символов и мультимодальный анализ контента.

VLM сыграли важную роль в разработке автономных систем, расширении взаимодействия человека с компьютером и эффективных инструментах обработки документов, успешно устраняя разрыв между этими двумя модальностями данных. Однако при обработке визуальных данных высокого разрешения и разнообразного текстового ввода все еще существует множество проблем.

Текущие исследования частично устраняют эти ограничения, но статические визуальные кодеры, используемые в большинстве моделей, не обладают адаптивностью к высоким разрешениям и переменным размерам входных данных. В то же время сочетание предварительно обученных языковых моделей с визуальными кодировщиками часто приводит к неэффективности, поскольку они не оптимизированы для мультимодальных задач. Хотя в некоторых моделях для управления сложностью используются разреженные вычислительные методы, точность различных наборов данных все еще недостаточна. Более того, наборам обучающих данных существующих моделей часто не хватает разнообразия и специфичности задач, что еще больше ограничивает их производительность. Например, многие модели плохо справляются со специализированными задачами, такими как интерпретация диаграмм или анализ плотного документа.

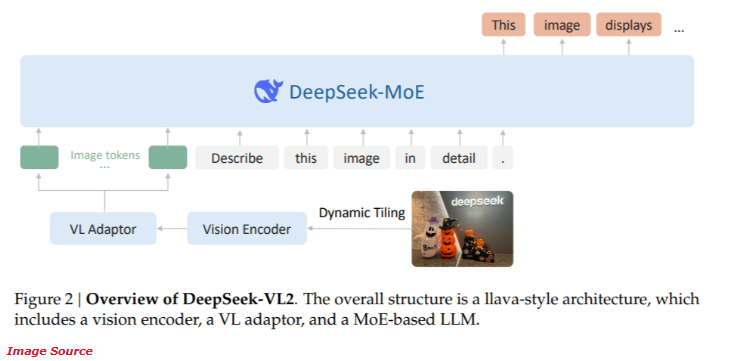

Недавно компания DeepSeek-AI выпустила новую серию моделей визуального языка DeepSeek-VL2 с открытым исходным кодом для гибридных экспертов (MoE). Эта серия моделей сочетает в себе передовые инновационные технологии, в том числе динамическую нарезку визуального кодирования, многоголовочный механизм скрытого внимания и структуру DeepSeek-MoE.

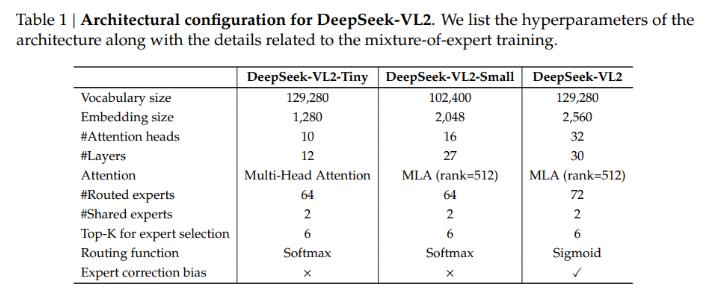

Серия DeepSeek-VL2 предоставляет три различные конфигурации параметров:

- DeepSeek-VL2-Tiny: 3,37 миллиарда параметров (1 миллиард параметров активации)

- DeepSeek-VL2-Small: 16,1 миллиарда параметров (2,8 миллиарда параметров активации)

- DeepSeek-VL2: 27,5 миллиардов параметров (4,5 миллиардов параметров активации)

Эта масштабируемость обеспечивает его способность адаптироваться к различным потребностям приложений и вычислительным бюджетам.

Архитектура DeepSeek-VL2 разработана для оптимизации производительности при одновременном снижении вычислительных требований. Метод динамической нарезки гарантирует обработку изображений высокого разрешения без потери важных деталей, что делает его идеальным для анализа документов и задач визуальной локализации. Кроме того, механизм скрытого внимания с несколькими головками позволяет модели эффективно обрабатывать большие объемы текстовых данных, сокращая вычислительные затраты, обычно связанные с обработкой плотного языкового ввода. Обучение DeepSeek-VL2 охватывает разнообразные мультимодальные наборы данных, что позволяет ему хорошо справляться с различными задачами, такими как оптическое распознавание символов, визуальные ответы на вопросы и интерпретация диаграмм.

Согласно тестам производительности, конфигурация Small достигла точности 92,3% в задаче оптического распознавания символов, значительно превзойдя существующие модели. В тесте визуального позиционирования модель улучшила точность на 15% по сравнению с продуктом предыдущего поколения.

В то же время DeepSeek-VL2 снижает требования к вычислительным ресурсам на 30%, сохраняя при этом современную точность. Эти результаты демонстрируют превосходство этой модели в обработке изображений и текста с высоким разрешением.

Вход в проект: https://huggingface.co/collections/deepseek-ai/deepseek-vl2-675c22accc456d3beb4613ab

Основные моменты:

Серия DeepSeek-VL2 предоставляет множество конфигураций параметров для адаптации к различным потребностям приложений.

Технология динамической нарезки повышает эффективность обработки изображений высокого разрешения и подходит для сложного анализа документов.

Модель хорошо справляется с задачами оптического распознавания символов и визуальной локализации со значительно повышенной точностью.

Модели серии DeepSeek-VL2 принесли новый прорыв в область моделей визуального языка благодаря своей инновационной архитектуре и превосходной производительности. Его преимущества в изображении высокого разрешения и сложной обработке текста делают его большим потенциалом во многих сценариях применения и заслуживают дальнейшего внимания и исследований.