Китайский стартап в области искусственного интеллекта DeepSeek выпустил свою новейшую сверхбольшую модель DeepSeek-V3, которая стала центром внимания отрасли благодаря своему открытому исходному коду и высокой производительности. Благодаря параметрам 671B и экспертной гибридной архитектуре DeepSeek-V3 превосходит ведущие модели с открытым исходным кодом в нескольких тестах и даже работает так же, как некоторые модели с закрытым исходным кодом. Его инновация заключается во вспомогательной стратегии балансировки нагрузки без потерь и технологии прогнозирования нескольких токенов, которая значительно повышает эффективность обучения модели и скорость работы. Выпуск DeepSeek-V3 знаменует собой крупный прорыв в технологии искусственного интеллекта с открытым исходным кодом, который еще больше сокращает разрыв с искусственным интеллектом с закрытым исходным кодом и открывает путь для развития общего искусственного интеллекта (AGI).

26 декабря 2024 года китайский стартап в области искусственного интеллекта DeepSeek выпустил свою новейшую сверхбольшую модель DeepSeek-V3, которая известна своей технологией с открытым исходным кодом и инновационными задачами, ведущими передовыми поставщиками ИИ. DeepSeek-V3 имеет 671B параметров и использует архитектуру, состоящую из нескольких экспертов, для активации определенных параметров для точного и эффективного решения конкретной задачи. Согласно тестам, предоставленным DeepSeek, эта новая модель превзошла ведущие модели с открытым исходным кодом, включая Llama3.1-405B от Meta, и имеет производительность, аналогичную закрытым моделям от Anthropic и OpenAI.

Выпуск DeepSeek-V3 знаменует собой дальнейшее сокращение разрыва между ИИ с открытым исходным кодом и ИИ с закрытым исходным кодом. DeepSeek, который начинался как ответвление китайского квантового хедж-фонда High-Flyer Capital Management, надеется, что эти разработки проложат путь к общему искусственному интеллекту (AGI), где модели смогут понимать или изучать любую интеллектуальную задачу, которую может выполнить человек. .

К основным особенностям DeepSeek-V3 относятся:

Как и ее предшественник DeepSeek-V2, новая модель основана на базовой архитектуре многоголового скрытого внимания (MLA) и DeepSeekMoE, обеспечивающей эффективное обучение и вывод.

Компания также запустила две инновации: вспомогательную стратегию балансировки нагрузки без потерь и прогнозирование нескольких токенов (MTP), которая позволяет моделям прогнозировать несколько будущих токенов одновременно, повышая эффективность обучения и позволяя моделям работать в три раза быстрее, генерируя 60 токенов в секунду. .

На этапе предварительного обучения DeepSeek-V3 обучился на 14,8Т высококачественных и разнообразных токенов и выполнил двухэтапное расширение длины контекста и, наконец, выполнил пост-обучение с контролируемой точной настройкой (SFT) и обучением с подкреплением (RL). привести модель в соответствие с человеческими предпочтениями и еще больше раскрыть ее потенциал.

На этапе обучения DeepSeek использует различные аппаратные средства и алгоритмы оптимизации, в том числе среду обучения смешанной точности FP8 и алгоритм DualPipe для распараллеливания конвейеров, что снижает затраты на обучение. Утверждается, что весь процесс обучения DeepSeek-V3 занимает 2788 тысяч часов графического процессора H800 или примерно 5,57 миллиона долларов, что намного меньше, чем сотни миллионов долларов, которые обычно тратятся на предварительное обучение больших языковых моделей.

DeepSeek-V3 стал самой мощной моделью с открытым исходным кодом на рынке. Многочисленные тесты, проведенные компанией, показали, что он превосходит GPT-4o с закрытым исходным кодом в большинстве тестов, за исключением ориентированных на английский язык SimpleQA и FRAMES, где модель OpenAI лидировала с баллами 38,2 и 80,5 соответственно (оценки DeepSeek-V3 — 24,9 и 73,3). соответственно). DeepSeek-V3 особенно хорошо показал себя в тестах по китайскому языку и математике, набрав 90,2 балла в тесте Math-500, за ним следует Qwen с результатом 80.

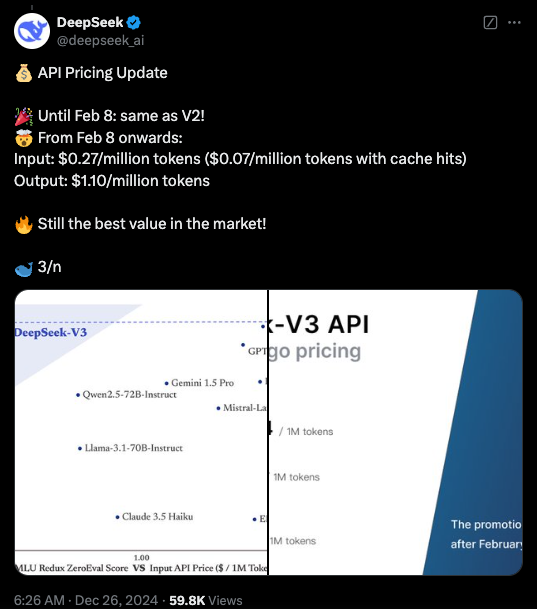

В настоящее время код DeepSeek-V3 доступен по лицензии MIT на GitHub, а модель предоставляется по лицензии модели компании. Предприятия также могут тестировать новые модели через DeepSeek Chat, платформу, аналогичную ChatGPT, и получать доступ к API для коммерческого использования. DeepSeek будет предоставлять API по той же цене, что и DeepSeek-V2, до 8 февраля. После этого будет взиматься плата в размере 0,27 доллара США за миллион входных токенов (0,07 доллара США за миллион токенов при попадании в кэш) и 1,10 доллара США за миллион выходных токенов.

Выделять:

Выпущен DeepSeek-V3, производительность которого превосходит Llama и Qwen.

Используйте параметры 671B и экспертную гибридную архитектуру для повышения эффективности.

Инновации включают стратегии балансировки нагрузки без потерь и прогнозирование нескольких токенов для повышения скорости.

Затраты на обучение значительно сокращаются, что способствует развитию искусственного интеллекта с открытым исходным кодом.

Открытый исходный код и высокая производительность DeepSeek-V3 окажут глубокое влияние на область искусственного интеллекта, будут способствовать развитию технологии искусственного интеллекта с открытым исходным кодом и способствовать ее применению в различных областях. DeepSeek продолжит работу над разработкой более совершенных моделей искусственного интеллекта и будет способствовать реализации AGI. В будущем у нас есть основания ожидать от DeepSeek новых прорывов.