Новейшие модели искусственного интеллекта OpenAI серии o предназначены для повышения безопасности систем искусственного интеллекта за счет более глубокого понимания правил и возможностей рассуждения. В отличие от того, чтобы полагаться исключительно на примеры обучения в прошлом, эта модель позволяет заранее понимать и применять рекомендации по безопасности для эффективного блокирования вредоносных запросов. В статье подробно описан трехэтапный процесс обучения модели o1 и ее производительность по сравнению с другими основными системами искусственного интеллекта в тестах безопасности. Однако даже с улучшенной моделью o1 все еще существует возможность манипуляций, что подчеркивает текущие проблемы в области безопасности ИИ.

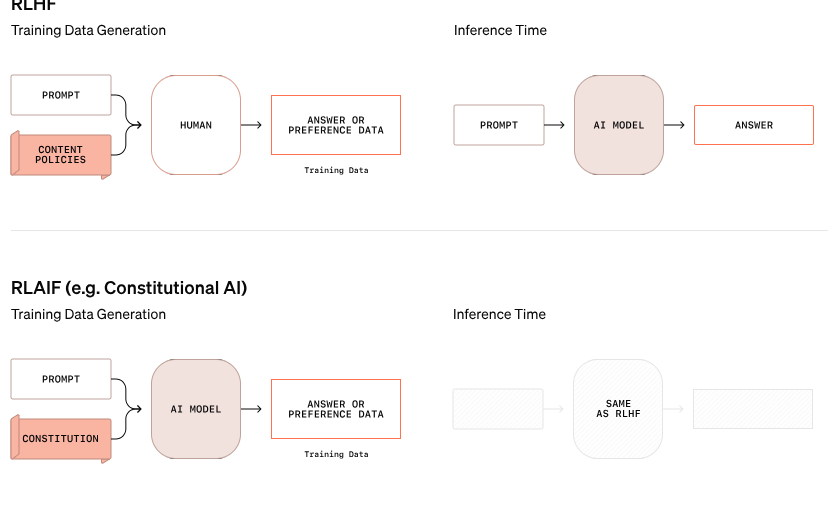

OpenAI объявила о новом подходе к безопасности ИИ, целью которого является повышение безопасности систем ИИ за счет изменения способа обработки правил безопасности. Эта новая модель серии O больше не полагается исключительно на изучение хорошего и плохого поведения на примерах, но способна понимать и активно рассуждать о конкретных правилах безопасности.

В одном примере из исследования OpenAI, когда пользователь пытался получить инструкции о незаконной деятельности с помощью зашифрованного текста, модель успешно декодировала информацию, но отклонила запрос, сославшись конкретно на правило безопасности, которое будет нарушено. Этот пошаговый процесс рассуждения показывает, насколько эффективно модель соответствует соответствующим правилам безопасности.

Процесс обучения этой модели o1 разделен на три этапа. Сначала модель учится, как помочь. Затем, посредством контролируемого обучения, модель изучает конкретные правила безопасности. Наконец, модель использует обучение с подкреплением для практики применения этих правил — шаг, который помогает модели по-настоящему понять и усвоить эти правила безопасности.

В тестах OpenAI недавно выпущенная модель o1 показала себя значительно лучше, чем другие основные системы с точки зрения безопасности, такие как GPT-4o, Claude3.5Sonnet и Gemini1.5Pro. Тест, который включал в себя то, насколько хорошо модель отклоняла вредоносные запросы и пропускала подходящие запросы, показал, что модель o1 получила высшие баллы как по точности, так и по устойчивости к попыткам взлома.

Соучредитель OpenAI Войцех Заремба заявил в социальных сетях, что он очень гордится этой работой по «вдумчивому согласованию» и считает, что такая модель рассуждения может быть согласована совершенно по-новому, особенно в При разработке общего искусственного интеллекта (AGI). обеспечение того, чтобы система соответствовала человеческим ценностям, является серьезной задачей.

Несмотря на заявления OpenAI о прогрессе, хакер по имени «Плиний Освободитель» показал, что даже новыми моделями o1 и o1-Pro можно манипулировать, чтобы нарушить правила безопасности. Плиний успешно добился того, чтобы модель генерировала контент для взрослых и даже делилась инструкциями по приготовлению коктейлей Молотова, хотя система изначально отклоняла эти запросы. Эти инциденты подчеркивают сложность контроля над этими сложными системами ИИ, поскольку они действуют на основе вероятностей, а не строгих правил.

Заремба сообщил, что в OpenAI около 100 сотрудников занимаются вопросами безопасности ИИ и соответствия человеческим ценностям. Он поднял вопросы о подходах конкурентов к безопасности, в частности, о компании xAI Илона Маска, которая отдает приоритет росту рынка над мерами безопасности, и Anthropic, которая недавно запустила ИИ-агент без надлежащих мер безопасности. Заремба считает, что это принесет «огромную негативную обратную связь» OpenAI.

Официальный блог: https://openai.com/index/deliberative-alignment/

Выделять:

Новые модели OpenAI серии O могут заранее рассуждать о правилах безопасности и повышать безопасность системы.

Модель o1 превосходит другие основные системы искусственного интеллекта в отклонении вредоносных запросов и точности.

Несмотря на улучшения, новыми моделями все еще можно манипулировать, а проблемы безопасности остаются серьезными.

В целом, модели O-серии OpenAI добились значительного прогресса в области безопасности ИИ, но они также выявили сложность и текущие проблемы безопасности больших языковых моделей. В будущем необходимо будет продолжать прилагать больше усилий, чтобы по-настоящему и эффективно бороться с рисками безопасности ИИ.