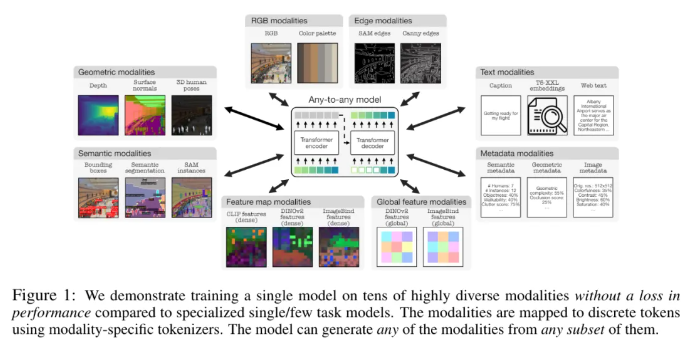

Apple и Федеральная политехническая школа Лозанны (EPFL) в Швейцарии совместно разработали революционную мультимодальную модель 4M-21. Модель может быть обучена на 21 различных модальностях, ее производительность значительно выше, чем у существующих моделей, и она реализует множество функций, таких как кросс-модальный поиск и контролируемая генерация. Это исследование значительно улучшило производительность и адаптируемость модели за счет расширения размера модели и набора данных, увеличения типа и количества методов обучения, а также принятия совместной стратегии обучения. Модель 4M-21 использует архитектуру кодера-декодера на основе трансформатора и добавляет дополнительные модальные внедрения для адаптации к новым модальностям. В процессе обучения полностью учитываются характеристики различных модальностей и используется специальный метод токенизации для модальностей.

В этом исследовании было использовано решение 4M для предварительного обучения, которое может улучшить производительность и адаптируемость модели за счет расширения размера модели и наборов данных, увеличения типа и количества модальностей, задействованных в обучении модели, а также проведения совместного обучения на нескольких наборы данных. Исследователи используют различные методы токенизации для дискретизации модальностей с различными функциями, такими как глобальное встраивание изображений, человеческие позы и семантические экземпляры. Что касается выбора архитектуры, в этом исследовании используется архитектура кодера-декодера 4M на основе Transformer и добавляются дополнительные модальные внедрения для адаптации к новым модальностям.

Эта модель может не только выполнять ряд общих задач по зрению, таких как оценка нормали и глубины поверхности DIODE, семантика COCO и сегментация экземпляров, оценка позы человека 3DPW3D и т. д., она также может генерировать произвольные методы обучения и поддерживать несколько Выполняется мелкозернистая и многомодальная генерация, а изображения RGB или другие модальности можно получить, используя другие модальности в качестве запросов. Кроме того, исследователи также провели эксперименты по мультимодальной передаче на NYUv2, семантической сегментации Hypersim и ARKitScenes.

К его важным функциональным особенностям относятся:

Модальность «любой к любому»: увеличено с 7 модальностей лучшей существующей модели «любой к любому» до 21 различных модальностей, что обеспечивает кросс-модальный поиск, контролируемую генерацию и высокую производительность «из коробки».

Поддержка разнообразия: добавьте поддержку более структурированных данных, таких как позы людей, экземпляры SAM, метаданные и многое другое.

Токенизация. Изучите дискретную токенизацию для различных модальностей, используя методы, специфичные для модальностей, такие как глобальное встраивание изображений, человеческие позы и семантические экземпляры.

Масштабирование: увеличьте размер модели до 3 миллиардов параметров и набора данных до 0,5 миллиарда выборок.

Совместное обучение: совместное обучение зрению и языку одновременно.

Адрес статьи: https://arxiv.org/pdf/2406.09406.

Основные моменты:

- Исследователи из Apple и Федеральной политехнической школы Лозанны (EPFL) в Швейцарии совместно разработали единую модель модальности «любой к любому», которую можно обучать 21 различному модальности.

- Модель может выполнять ряд задач общего зрения «из коробки», а также способна генерировать произвольные методы обучения, поддерживая несколько методов для выполнения мелкозернистой и мультимодальной генерации.

- Исследователи также провели эксперименты по мультимодальной передаче на NYUv2, семантической сегментации Hypersim и ARKitScenes.

В целом модель 4М-21 добилась значительного прогресса в области мультимодальных исследований. Ее мощные характеристики и широкие перспективы применения открывают новое направление для будущего развития мультимодального искусственного интеллекта. Открытый исходный код и будущие применения этой модели заслуживают ожидания.