Исследовательские группы из Нанкинского университета, Фуданьского университета и лаборатории Ноева ковчега компании Huawei добились крупных прорывов в области 3D-цифровых людей, решив проблемы недостаточной согласованности нескольких представлений и эмоциональной выразительности в существующих методах. Они разработали новый метод, который позволяет синтезировать говорящие 3D-аватары с контролируемыми эмоциями и обеспечивает значительное улучшение синхронизации губ и качества рендеринга. Результаты исследования основаны на недавно созданном наборе данных EmoTalk3D, который содержит калиброванные многопросмотровые видео, эмоциональные аннотации и покадровую 3D-геометрическую информацию и опубликован для некоммерческого исследовательского использования. Благодаря структуре отображения «от речи к геометрии и внешнему виду» этот метод точно фиксирует тонкие выражения лица и обеспечивает высокоточную визуализацию под свободными углами обзора.

Вход в продукт: https://nju-3dv.github.io/projects/EmoTalk3D/

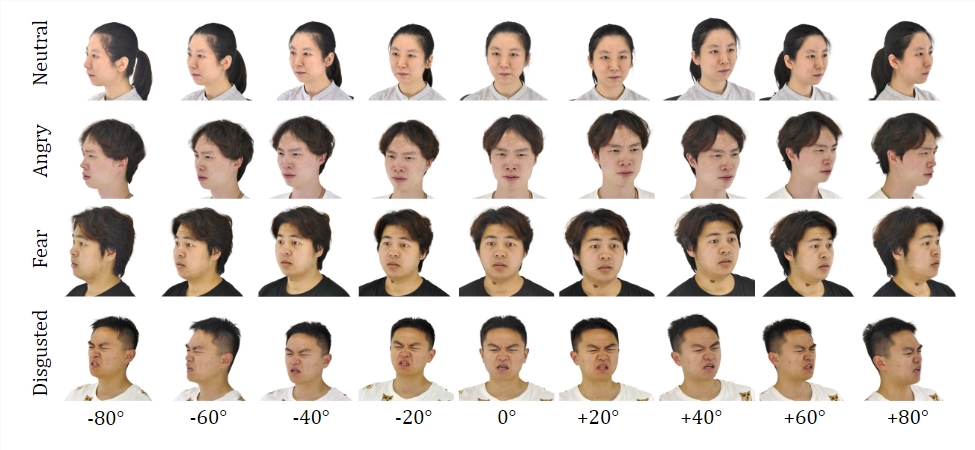

Они собрали набор данных EmoTalk3D с калиброванными многопросмотровыми видео, аннотациями эмоций и покадровой 3D-геометрией. Предлагается новый метод синтеза говорящих 3D-аватаров с управляемыми эмоциями со значительными улучшениями в синхронизации губ и качестве рендеринга.

Набор данных:

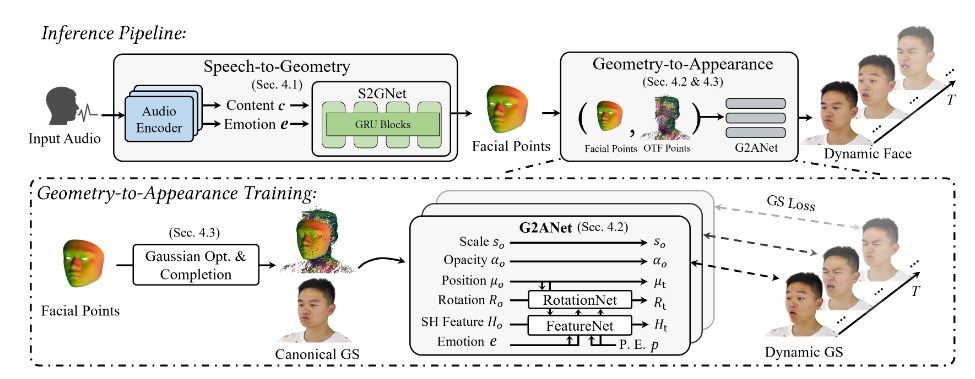

Обучаясь на наборе данных EmoTalk3D, исследовательская группа создала структуру картографирования «от речи к геометрии и внешнему виду». Реалистичная трехмерная геометрическая последовательность сначала прогнозируется на основе звуковых характеристик, а затем на основе предсказанной геометрии синтезируется внешний вид трехмерной говорящей головы, представленной четырехмерной гауссианой. Внешность далее разлагается на стандартные и динамические гауссианы, полученные из видеороликов с несколькими представлениями, и объединяются для рендеринга анимации говорящей головы в свободном просмотре.

Модель позволяет контролировать эмоции в генерируемых говорящих аватарах и отображает их в широком диапазоне углов обзора. Продемонстрировано улучшенное качество рендеринга и стабильность генерации движения губ при одновременной передаче динамических деталей лица, таких как морщины и тонкие выражения. В примере сгенерированных результатов точно отображены счастливые, злые и разочарованные выражения лица трехмерного цифрового человека.

Общий процесс состоит из пяти модулей:

Первый — это кодировщик декомпозиции эмоционального контента, который анализирует контент и эмоциональные характеристики из входной речи; второй — это сеть преобразования речи в геометрию, которая прогнозирует динамические трехмерные облака точек на основе функций; третий — модуль гауссовой оптимизации и завершения для создания; стандартный внешний вид; четвертый — преобразование геометрии в внешний вид. Сеть синтезирует внешний вид лица на основе динамического трехмерного облака точек; пятый — модуль рендеринга, который преобразует динамическую гауссову анимацию в свободный просмотр.

Кроме того, они создали набор данных EmoTalk3D — набор данных «говорящей головы», аннотированный эмоциями, с несколькими изображениями и покадровыми трехмерными формами лица, который будет доступен общественности для некоммерческих исследовательских целей.

Выделять:

Предложите новый метод синтеза цифровых людей с управляемыми эмоциями.

Создайте структуру отображения «от речи к геометрии и внешнему виду».

Набор данных EmoTalk3D установлен и готов к открытию.

Это исследование открывает новое направление для развития цифровых 3D-технологий человека. Предложенные методы и наборы данных предоставят ценные ресурсы для будущих исследований и будут способствовать развитию 3D-цифровых человеческих технологий, которые будут более реалистичными и эмоционально выразительными. Открытие набора данных EmoTalk3D также способствует сотрудничеству и обменам в академическом сообществе.