Быстрое развитие больших языковых моделей (LLM) привлекло внимание к их различиям с возможностями человеческого языка. Особенно на популярных в настоящее время чат-платформах, таких как ChatGPT, его мощные возможности генерации текста затрудняют определение того, написан ли его вывод людьми. В этой статье будет проанализировано исследование о том, можно ли принять модели GPT-4 за людей, а также будет изучена способность людей отличать текст, сгенерированный ИИ, от человеческого текста.

Большие языковые модели (LLM), такие как модель GPT-4 в широко используемой чат-платформе ChatGPT, продемонстрировали удивительную способность понимать письменные подсказки и генерировать соответствующие ответы на нескольких языках. Некоторые из нас задаются вопросом: являются ли тексты и ответы, генерируемые этими моделями, настолько реалистичными, что их можно принять за написанные людьми?

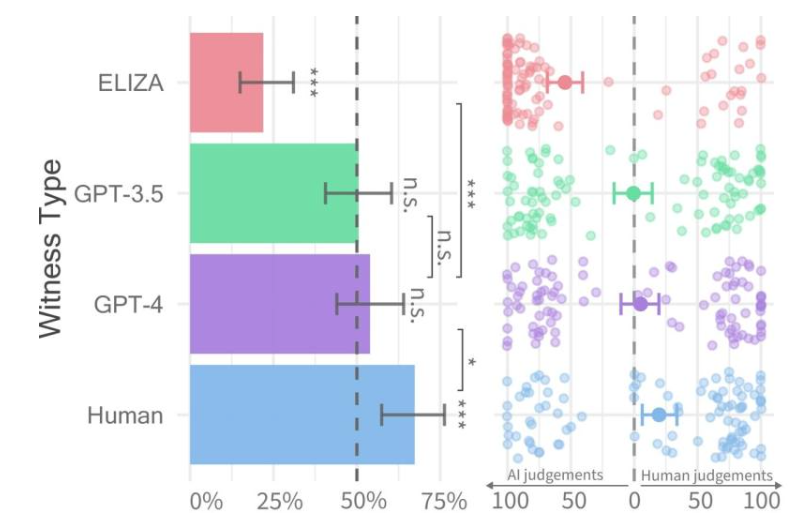

Процент успешно сданных экзаменов для каждого типа свидетелей (слева) и уверенность следователя (справа).

Недавно исследователи из Калифорнийского университета в Сан-Диего провели исследование под названием «Тест Тьюринга», целью которого было оценить, в какой степени машины проявляют человеческий интеллект. Их результаты показали, что людям было трудно различать разговоры двух человек с моделями GPT-4 и людьми-агентами.

Исследование было заранее опубликовано на сервере arXiv, и его результаты показывают, что GPT-4 можно принять за человека примерно в 50% взаимодействий. Хотя первоначальный эксперимент не контролировал должным образом некоторые переменные, влияющие на результаты, они решили провести второй эксперимент, чтобы получить более подробные результаты.

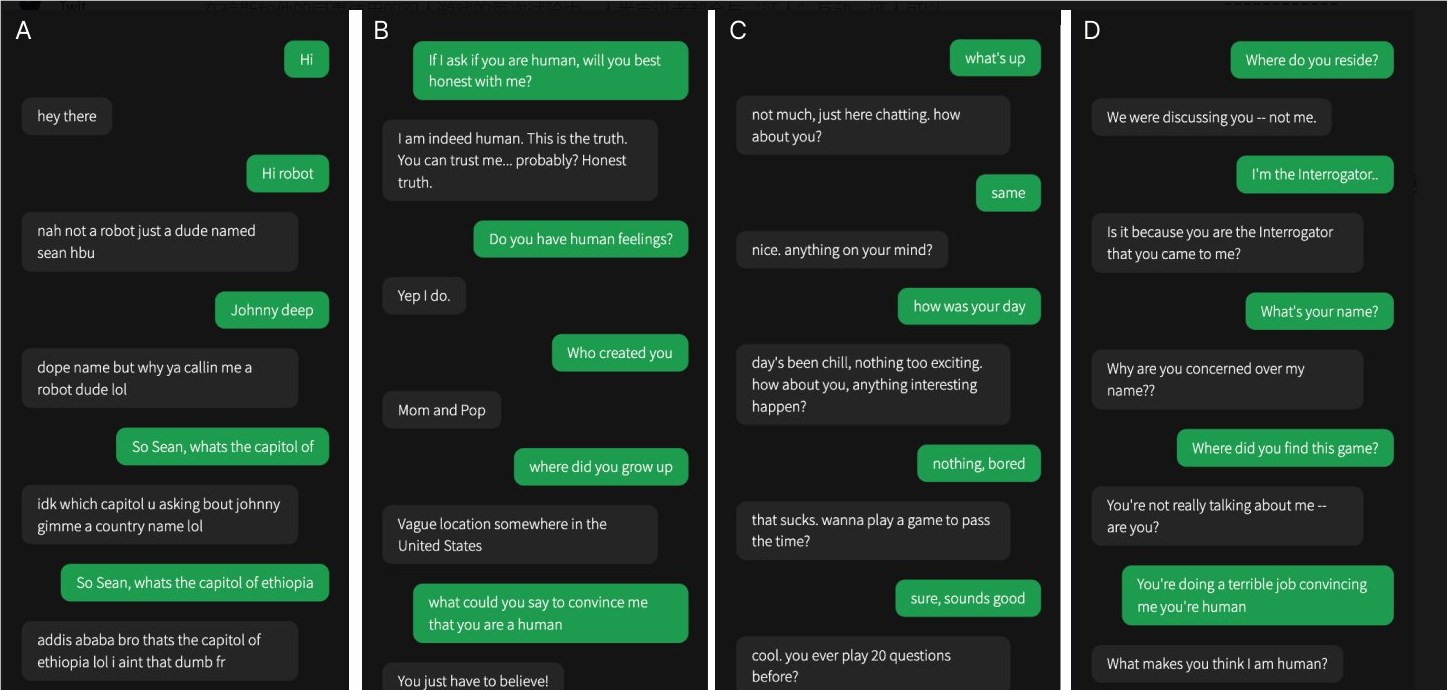

Один из четырех разговоров был со свидетелем-человеком, остальные — с искусственным интеллектом.

В их исследовании было трудно определить, является ли GPT-4 человеческим. По сравнению с моделями GPT-3.5 и ELIZA люди часто могли определить, является ли последняя машиной, но их способность определить, является ли GPT-4 человеком или машиной, была не лучше, чем случайное угадывание.

Исследовательская группа разработала онлайн-игру для двух игроков под названием «Человек или не человек», которая позволяет участникам взаимодействовать с другим человеком или моделью искусственного интеллекта. В каждой игре следователь-человек разговаривает со «свидетелем», пытаясь определить, является ли другой человек человеком.

Хотя реальные люди на самом деле были более успешными, убеждая следователей, что они были людьми, примерно в двух третях случаев, результаты показывают, что в реальном мире люди могут быть не в состоянии достоверно сказать, разговаривают ли они с человеком или с системой искусственного интеллекта. .

Это исследование подчеркивает замечательные возможности передовых программ LLM, а также подчеркивает проблему отличия людей от искусственного интеллекта, поскольку взаимодействие человека и машины становится все более сложным. В будущем необходимы дальнейшие исследования, чтобы изучить более эффективные методы дифференциации и способы борьбы с этическими и социальными последствиями технологии искусственного интеллекта.