В связи с быстрым развитием мультимодальных моделей большого языка (MLLM) эффективная интеграция визуальных, языковых и речевых модальностей стала горячей точкой исследований. Однако проблемы, вызванные существенными различиями в различных модальных данных, таких как пространственная информация зрения и информация временных рядов речи, препятствуют эффективному мультимодальному взаимодействию. Существующие методы часто опираются на независимые модули ASR и TTS, что увеличивает задержку и снижает плавность взаимодействия. В этой статье представлена VITA-1.5, мультимодальная крупномасштабная языковая модель, которая объединяет зрение, язык и речь и направлена на решение этих проблем.

В последнее время значительный прогресс был достигнут в мультимодальных моделях большого языка (MLLM), особенно в интеграции визуальных и текстовых модальностей. Однако с ростом популярности взаимодействия человека с компьютером важность речевых модальностей становится все более заметной, особенно в мультимодальных диалоговых системах. Голос является не только ключевым средством передачи информации, но и значительно повышает естественность и удобство взаимодействия.

Однако из-за существенных различий между визуальными и речевыми данными интеграция их в MLLM не является тривиальной задачей. Например, визуальные данные передают пространственную информацию, а речевые данные передают динамические изменения во временных рядах. Эти фундаментальные различия затрудняют одновременную оптимизацию двух методов, что часто приводит к конфликтам в процессе обучения. Кроме того, традиционные системы преобразования речи в речь полагаются на отдельные модули автоматического распознавания речи (ASR) и преобразования текста в речь (TTS), что увеличивает задержку и снижает когерентность, ограничивая их полезность в приложениях реального времени.

Чтобы решить эти проблемы, исследователи запустили VITA-1.5, мультимодальную крупномасштабную языковую модель, которая объединяет зрение, язык и речь. VITA-1.5 использует тщательно разработанный трехэтапный метод обучения для постепенного введения визуальных и речевых данных для облегчения модальных конфликтов, сохраняя при этом высокую мультимодальную производительность.

На первом этапе модель фокусируется на визуально-лингвистическом обучении, развитии сильных визуальных способностей путем обучения визуальных адаптеров и точной настройке модели с использованием описательных подписей и визуальных данных вопросов и ответов.

На втором этапе вводится обработка аудиовхода путем обучения аудиокодера с использованием парных данных транскрипции речи, а затем его точной настройки с использованием речевых данных вопросов и ответов, чтобы модель могла эффективно понимать и реагировать на аудиовход. Наконец, на третьем этапе аудиодекодер обучается обеспечивать сквозной вывод речи без необходимости использования внешних модулей TTS, что позволяет VITA-1.5 генерировать плавные речевые ответы и повышать естественность и интерактивность мультимодального диалога. системы.

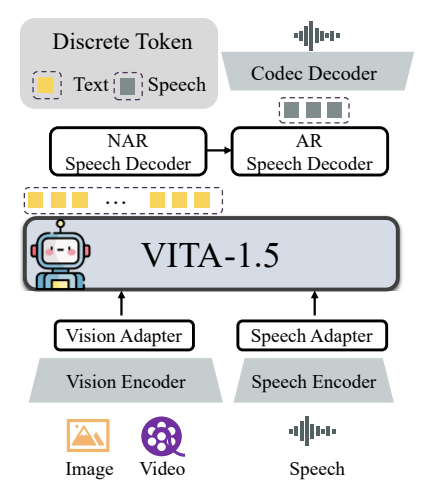

Общая архитектура VITA-1.5 включает визуальные и аудиокодеры и адаптеры для подключения к большим языковым моделям. На выходе имеется модуль сквозной генерации речи вместо использования внешней модели TTS, как в исходной версии VITA-1.0. Визуальный кодер использует InternViT-300M, размер входного изображения составляет 448×448 пикселей, каждое изображение генерирует 256 визуальных токенов.

Для изображений с высоким разрешением VITA-1.5 использует стратегию динамического исправления для захвата локальных деталей. Видео рассматривается как особый тип ввода с несколькими изображениями, при этом кадры выбираются в зависимости от длины видео. Модуль кодирования звука состоит из нескольких сверточных слоев понижающей дискретизации и 24 блоков преобразователей с частотой выходных кадров 12,5 Гц. Аудиоадаптер состоит из нескольких сверточных слоев с двукратным понижением частоты дискретизации. В качестве модели кодека используется TiCodec, который кодирует непрерывный речевой сигнал в дискретные речевые токены с частотой 40 Гц и способен декодировать их обратно в речевой сигнал с частотой дискретизации 24 000 Гц. Чтобы модель могла выводить речевые токены, после текстовых токенов добавляются два речевых декодера: речевой декодер без авторегрессии (NAR) и речевой декодер с авторегрессией (AR).

Данные обучения VITA-1.5 охватывают широкий спектр категорий, таких как данные субтитров, а также данные вопросов и ответов, включая китайский и английский языки. На разных этапах обучения подмножества всего набора данных выборочно выбираются для достижения разных целей. Стратегия обучения осуществляется в три этапа:

Первый этап: визуально-лингвистическое обучение, включая визуальное выравнивание, визуальное понимание и тонкую настройку визуального контроля, направлено на устранение разрыва между зрением и языком и предоставление модели возможности понимать содержание изображения и отвечать на визуальные вопросы.

Этап 2. Настройка аудиовхода, включая выравнивание звука и точную настройку звука под контролем, предназначена для того, чтобы модель могла понимать аудиовход и взаимодействовать с помощью голосовых вопросов и текстовых ответов.

Третий этап: настройка вывода звука, включая обучение кодека и обучение декодера NAR + AR, предназначена для того, чтобы модель могла генерировать речевой вывод и обеспечивать сквозное голосовое взаимодействие.

Исследователи провели обширную оценку различных тестов на понимание изображений, видео и речи и сравнили результаты с моделями с открытым исходным кодом и проприетарными моделями. Результаты показывают, что VITA-1.5 демонстрирует сопоставимые способности восприятия и рассуждения с ведущим MLLM при решении задач с изображениями и видео, а также достигает значительных улучшений в речевых способностях. Например, в тесте распознавания изображений VITA-1.5 работает на одном уровне с современными моделями с открытым исходным кодом и даже превосходит некоторые модели с закрытым исходным кодом. С точки зрения понимания видео VITA-1.5 работает на одном уровне с лучшими моделями с открытым исходным кодом. Кроме того, VITA-1.5 достигла высочайшей точности в задачах ASR как на китайском, так и на английском языке, превзойдя профессиональные речевые модели.

В целом, VITA-1.5 успешно интегрирует зрение и речь посредством тщательно разработанной трехэтапной стратегии обучения, обеспечивая сильные возможности визуального и речевого понимания, обеспечивая эффективное взаимодействие речи с речью, не полагаясь на отдельный модуль ASR или TTS. Ожидается, что это исследование будет способствовать развитию моделей с открытым исходным кодом в области мультимодального взаимодействия в реальном времени.

Адрес проекта: https://github.com/VITA-MLLM/VITA

Появление VITA-1.5 знаменует собой новый этап в разработке мультимодальных крупномасштабных языковых моделей. Его возможности сквозной генерации речи и превосходная производительность в задачах понимания изображений, видео и речи сделают процесс более естественным и плавным. мультимодальная языковая модель будущего. Динамические интерактивные системы открывают новые возможности. Этот результат исследования заслуживает внимания и, как ожидается, сыграет важную роль в практических приложениях.