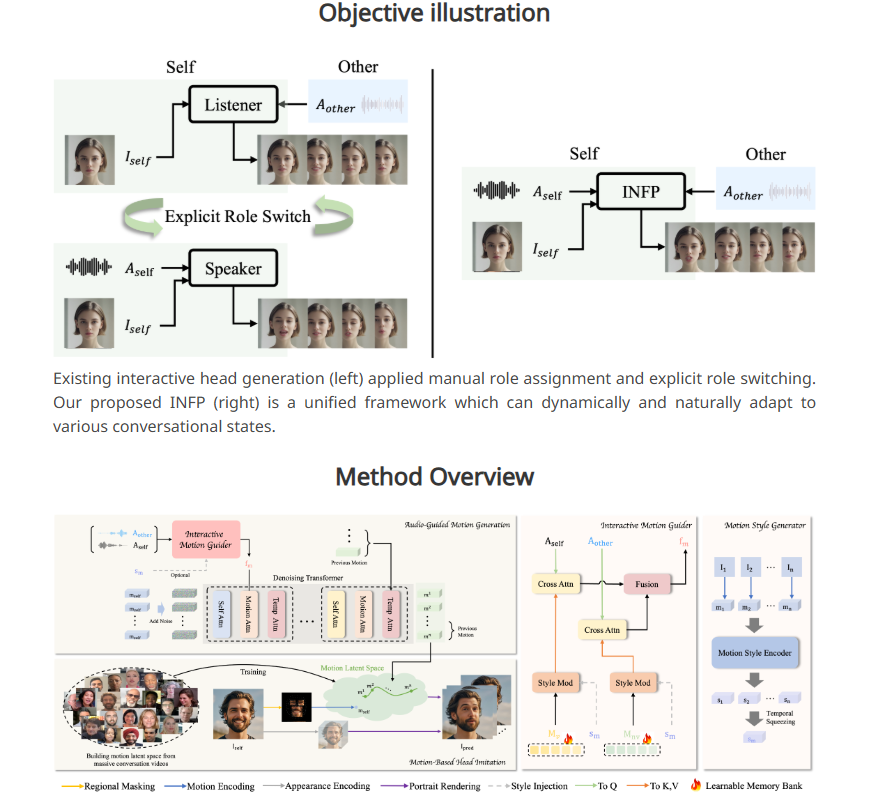

ByteDance запустила новую систему искусственного интеллекта INFP, которая позволяет статическим портретным фотографиям «говорить» и реагировать посредством аудиовхода. В отличие от традиционной технологии, INFP не нужно вручную указывать роли. Система может автоматически принимать решения на основе разговора, что значительно повышает эффективность и удобство. Его основная технология заключается в двух этапах: «имитация головы на основе движения» и «генерация движений под звуковым сопровождением». Анализируя выражения лица, движения головы и аудиовход в разговорах, он генерирует естественные и плавные модели движений для создания статичных изображений. к жизни. Для обучения INFP ByteDance также создала набор данных DyConv, содержащий более 200 часов реальных видео разговоров, чтобы обеспечить высокое качество вывода системы.

Рабочий процесс INFP состоит из двух основных этапов. На первом этапе, получившем название «мимикрия головы на основе движений», система извлекает детали из видео, анализируя выражения лиц и движения головы людей во время разговора. Эти данные о движении преобразуются в формат, который можно использовать в последующих анимациях, что позволяет фотографиям соответствовать движению исходного персонажа.

Вторым шагом является «генерация движений с аудиоуправлением», когда система генерирует естественные шаблоны движений на основе аудиовхода. Исследовательская группа разработала «руководство по движениям», которое анализирует звук обеих сторон разговора, чтобы создать модели движений для разговора и прослушивания. Компонент искусственного интеллекта, называемый диффузионным преобразователем, затем постепенно оптимизирует эти шаблоны, в результате чего получается плавное и реалистичное движение, которое идеально соответствует аудиоконтенту.

Чтобы эффективно обучать систему, исследовательская группа также создала набор данных диалогов под названием DyConv, который собирает более 200 часов реальных диалогов. По сравнению с существующими базами данных разговоров, такими как ViCo и RealTalk, DyConv имеет уникальные преимущества в эмоциональном выражении и качестве видео.

ByteDance утверждает, что INFP превосходит существующие инструменты в нескольких ключевых областях, в частности, в согласовании движений губ с речью, сохранении индивидуальных черт лица и создании разнообразных естественных движений. Кроме того, система одинаково хорошо показала себя при создании видеороликов, в которых был слышен только собеседник.

Хотя INFP в настоящее время поддерживает только аудиовход, исследовательская группа изучает возможность расширения системы до изображений и текста. Будущая цель — создавать реалистичную анимацию всего тела персонажа. Однако, учитывая, что этот тип технологии может использоваться для создания фейковых видеороликов и распространения дезинформации, исследовательская группа планирует ограничить использование основной технологии исследовательскими учреждениями, аналогично тому, как Microsoft управляет своей передовой системой клонирования голоса.

Эта технология является частью более широкой стратегии ByteDance в области искусственного интеллекта. Опираясь на свои популярные приложения TikTok и CapCut, ByteDance располагает широкой инновационной платформой приложений для искусственного интеллекта.

Вход в проект: https://grisoon.github.io/INFP/

Основные моменты:

INFP может позволить статичным портретам «говорить» посредством звука и автоматически определять роль диалога.

Система работает в два этапа: во-первых, она извлекает детали движений в человеческих разговорах, а во-вторых, преобразует звук в естественные модели движений.

Набор данных ByteDance DyConv содержит более 200 часов высококачественных видео разговоров, которые помогают повысить производительность системы.

Запуск системы INFP демонстрирует инновационную мощь ByteDance в области искусственного интеллекта. Ее будущий потенциал развития огромен, но с потенциальными этическими рисками также необходимо тщательно справляться. Развитие технологий всегда должно быть ориентировано на социальные интересы и обеспечивать их использование на благо человечества.