Последняя платформа синхронизации губ LatentSync, выпущенная ByteDance, использует модель условной скрытой диффузии звука, основанную на Stable Diffusion, для достижения более точного и эффективного эффекта синхронизации губ. В отличие от предыдущих методов, LatentSync использует сквозной подход для прямого моделирования сложных взаимосвязей между звуком и зрением, не требуя промежуточного представления движения, что значительно повышает эффективность обработки и точность синхронизации. Эта платформа умело использует Whisper для встраивания звука и объединяет его с механизмом TREPA для повышения временной согласованности, гарантируя, что выходное видео сохраняет временную согласованность, сохраняя при этом точность синхронизации губ.

Недавно ByteDance выпустила новую платформу синхронизации губ под названием LatentSync, целью которой является использование модели скрытой диффузии состояния звука для достижения более точной синхронизации губ. Платформа основана на Stable Diffusion и оптимизирована для обеспечения согласованности времени.

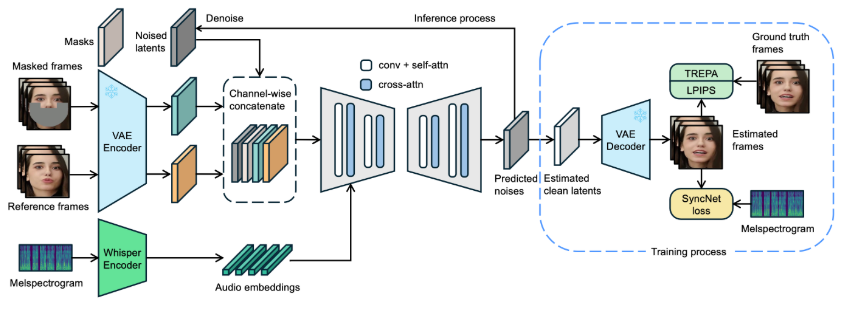

В отличие от предыдущих методов, основанных на пространственной диффузии пикселей или двухэтапной генерации, LatentSync использует сквозной подход без необходимости промежуточного представления движения и может напрямую моделировать сложные аудиовизуальные отношения.

В рамках LatentSync Whisper впервые используется для преобразования аудиоспектрограмм в эмбеддинг аудио и интегрируется в модель U-Net через уровни перекрестного внимания. Платформа выполняет конкатенацию на уровне канала опорных кадров и кадров маски со скрытыми переменными шума в качестве входных данных в U-Net.

Во время обучения используется одноэтапный подход для оценки чистых скрытых переменных на основе шума прогнозирования, а затем декодирования для генерации чистых кадров. В то же время в модели представлен механизм Temporal REPresentation Alignment (TREPA), который повышает временную согласованность и гарантирует, что сгенерированное видео может поддерживать временную согласованность, сохраняя при этом точность синхронизации губ.

Чтобы продемонстрировать эффективность этой технологии, проект предоставляет серию примеров видеороликов, показывающих исходное видео и видео, синхронизированное по губам. На примерах пользователи могут интуитивно почувствовать значительный прогресс LatentSync в синхронизации видео.

Оригинальное видео:

Выходное видео:

Кроме того, проект также планирует открыть исходный код кода вывода и контрольных точек, чтобы облегчить пользователям обучение и тестирование. Пользователям, которые хотят попробовать логические выводы, просто загрузите необходимые файлы веса модели, и все готово. Также был разработан полный процесс обработки данных, охватывающий каждый этап от обработки видеофайлов до выравнивания лица, что гарантирует, что пользователи смогут легко приступить к работе.

Вход в модельный проект: https://github.com/bytedance/LatentSync.

Основные моменты:

LatentSync — это платформа сквозной синхронизации, основанная на модели условной скрытой диффузии звука без необходимости промежуточных представлений движения.

Платформа использует Whisper для преобразования аудиоспектрограмм во встраивания, что повышает точность модели и временную согласованность во время синхронизации губ.

Проект предоставляет серию примеров видеороликов и планирует открыть исходный код соответствующих кодов и процессов обработки данных, чтобы облегчить использование и обучение пользователей.

Открытый исходный код и простота использования LatentSync будут способствовать дальнейшему развитию и применению технологии синхронизации губ, открывая новые возможности в области редактирования видео и создания контента. С нетерпением ждем последующих обновлений этого проекта, которые принесут еще больше сюрпризов.