20 января 2025 года компания DeepSeek выпустила свою первую модель вывода DeepSeek-R1, основанную на обучении с подкреплением. Модель показала производительность, сравнимую с OpenAI-o1-1217 или даже превосходящую ее в нескольких тестах производительности. DeepSeek-R1 обучается не напрямую, а посредством многоэтапного обучения и данных холодного запуска. На основе модели DeepSeek-V3-Base он преодолевает проблемы, вызванные использованием только модели обучения с подкреплением (DeepSeek-R1-Zero). Такие проблемы, как плохая читабельность и смешанные языки, в конечном итоге привели к значительному повышению производительности. Модель имеет открытый исходный код и предлагает конкурентоспособные цены на доступ к API, предоставляя пользователям более удобный и экономичный вариант.

20 января 2025 года DeepSeek объявила о выпуске своей первой модели вывода DeepSeek-R1, обученной с помощью обучения с подкреплением (RL), которая достигла производительности, сопоставимой с OpenAI-o1-1217 в нескольких тестах вывода. DeepSeek-R1 основан на модели DeepSeek-V3-Base и использует данные многоэтапного обучения и холодного запуска для улучшения возможностей вывода.

Исследователи DeepSeek впервые разработали DeepSeek-R1-Zero — модель, полностью обучаемую посредством крупномасштабного обучения с подкреплением без каких-либо подготовительных шагов для контролируемой точной настройки. DeepSeek-R1-Zero продемонстрировал отличные результаты в тестах вывода. Например, на экзамене AIME2024 его балл pass@1 увеличился с 15,6% до 71,0%. Однако у DeepSeek-R1-Zero также есть некоторые проблемы, такие как плохая читаемость и смешанные языки.

Чтобы решить эти проблемы и еще больше повысить производительность вывода, команда DeepSeek разработала DeepSeek-R1. DeepSeek-R1 представляет многоэтапное обучение и данные холодного запуска перед обучением с подкреплением. В частности, исследователи сначала собрали тысячи данных холодного запуска для точной настройки модели DeepSeek-V3-Base. Затем они провели обучение с подкреплением, ориентированное на логические выводы, во время обучения DeepSeek-R1-Zero. Когда процесс обучения с подкреплением был близок к конвергенции, они создавали новые контролируемые данные для точной настройки путем отклонения выборки контрольных точек обучения с подкреплением в сочетании с контролируемыми данными DeepSeek-V3 в таких областях, как письмо, ответы на факты и самосознание, а затем переобучались. Модель DeepSeek-V3-Base. Наконец, на точно настроенных контрольных точках выполняется дополнительное обучение с подкреплением с использованием сигналов из всех сценариев.

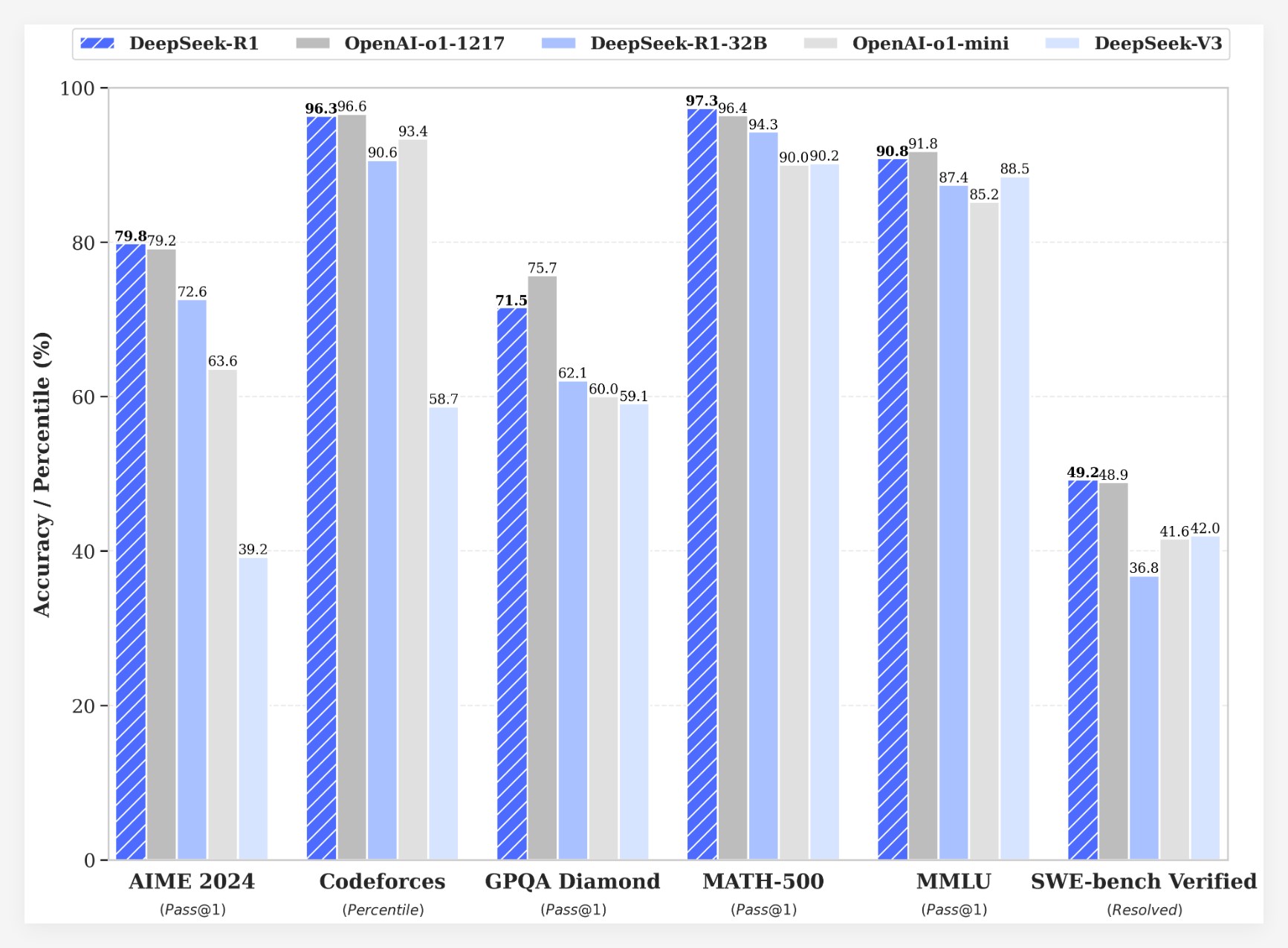

DeepSeek-R1 достигает впечатляющих результатов в нескольких тестах:

• На экзамене AIME2024 балл DeepSeek-R1 pass@1 достиг 79,8%, что немного выше, чем у OpenAI-o1-1217.

• На экзамене MATH-500 балл DeepSeek-R1 pass@1 достиг 97,3%, что соответствует показателю OpenAI-o1-1217.

• В соревновании по коду DeepSeek-R1 получил рейтинг Elo 2029 на Codeforces, превзойдя 96,3% участников-людей.

• В таких тестах знаний, как MMLU, MMLU-Pro и GPQA Diamond, DeepSeek-R1 набирает 90,8%, 84,0% и 71,5% соответственно, что значительно лучше, чем DeepSeek-V3.

•DeepSeek-R1 также хорошо справляется с другими задачами, такими как творческое письмо, общие вопросы и ответы, редактирование, обобщение и т. д.

Кроме того, DeepSeek также исследует возможность применения возможностей вывода DeepSeek-R1 в более мелких моделях. Было обнаружено, что дистилляция непосредственно из DeepSeek-R1 работает лучше, чем применение обучения с подкреплением на небольшой модели. Это говорит о том, что шаблоны вывода, обнаруженные с помощью больших базовых моделей, имеют решающее значение для улучшения возможностей вывода. DeepSeek имеет DeepSeek-R1-Zero, DeepSeek-R1 с открытым исходным кодом и шесть плотных моделей (1.5B, 7B, 8B, 14B, 32B, 70B), полученных из DeepSeek-R1 на основе Qwen и Llama. Запуск DeepSeek-R1 знаменует собой значительный прогресс в обучении с подкреплением и улучшении возможностей рассуждения больших языковых моделей.

ценовое преимуществоС точки зрения стоимости DeepSeek-R1 предлагает очень конкурентоспособную ценовую стратегию. Стоимость доступа к API составляет 0,14 доллара США (попадание в кэш) и 0,55 доллара США (промах в кэше) за миллион входных токенов и 2,19 доллара США за миллион выходных токенов. Эта ценовая стратегия более привлекательна, чем другие аналогичные продукты, и пользователи охарактеризовали ее как «меняющую правила игры». Официальный сайт и API теперь онлайн! Посетите https://chat.deepseek.com, чтобы познакомиться с DeepThink!

Выпуск DeepSeek-R1 вызвал бурные дискуссии в сообществе. Многие пользователи ценят открытый исходный код и ценовые преимущества этой модели, полагая, что она предоставляет разработчикам больше выбора и свободы. Однако некоторые пользователи задаются вопросом о размере контекстного окна модели и надеются, что будущие версии можно будет оптимизировать еще больше.

Команда DeepSeek заявила, что они продолжат работать над улучшением производительности и удобства использования модели и планируют запустить больше функций в будущем, включая расширенный анализ данных, чтобы оправдать ожидания пользователей в отношении AGI (общего искусственного интеллекта).

Запуск DeepSeek-R1 не только демонстрирует большой потенциал обучения с подкреплением в улучшении рассуждений больших языковых моделей, но также открывает новые направления и возможности для развития области искусственного интеллекта. Его функции с открытым исходным кодом и стратегия конкурентного ценообразования будут способствовать дальнейшему популяризации и применению технологии искусственного интеллекта.