Университет Чжэцзян и академия Alibaba Damo совместно запустили революционное исследование: использование обучающих видеороликов для создания высококачественного мультимодального набора данных из учебников. Целью этого исследования является решение проблем низкой плотности знаний и слабой корреляции изображения и текста в данных предварительного обучения существующих крупномасштабных языковых моделей (VLM), предоставление более качественных учебных материалов для VLM и инновационное использование образовательных ресурсов. Исследовательская группа собрала и обработала огромное количество обучающих видеороликов и, наконец, создала высококачественный набор данных, охватывающий несколько дисциплин, общей продолжительностью более 22 000 часов, что открывает новые возможности для применения искусственного интеллекта в сфере образования.

Недавно Чжэцзянский университет и Alibaba Damo Academy совместно опубликовали интересное исследование, направленное на создание высококачественных мультимодальных учебников с помощью обучающих видеороликов. Этот инновационный результат исследования не только дает новые идеи для обучения крупномасштабных языковых моделей (VLM), но также может изменить способ использования образовательных ресурсов.

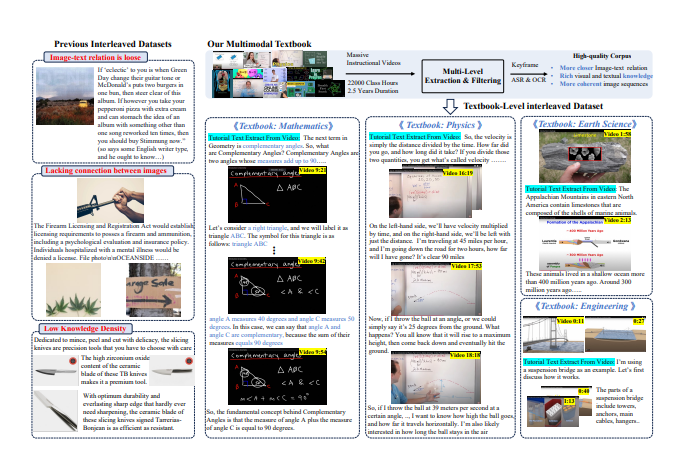

В связи с быстрым развитием технологий искусственного интеллекта корпус VLM для предварительного обучения в основном опирается на данные изображения-текста и переплетенный корпус изображения-текста. Однако большая часть текущих данных поступает с веб-страниц, корреляция между текстом и изображениями слабая, а плотность знаний относительно низкая, что не позволяет эффективно поддерживать сложные визуальные рассуждения.

Чтобы решить эту задачу, исследовательская группа решила извлечь высококачественный корпус знаний из большого количества обучающих видео в Интернете. Они собрали более 159 000 обучающих видеороликов и после тщательной фильтрации и обработки наконец сохранили 75 000 высококачественных видеороликов, охватывающих множество предметов, таких как математика, физика, химия и т. д., общей продолжительностью более 22 000 часов.

Исследователи разработали сложный конвейер обработки видео в учебнике. Сначала технология автоматического распознавания речи (ASR) используется для расшифровки поясняющего содержания видео в текст, а затем посредством анализа изображений и сопоставления текста отбираются клипы, которые имеют непосредственное отношение к знаниям. Наконец, эти обработанные ключевые кадры, текст OCR и расшифрованный текст чередуются и организуются, образуя мультимодальный учебник с богатым содержанием и строгой структурой.

Предварительные результаты этого исследования показывают, что по сравнению с предыдущими наборами данных, ориентированных на Интернет, новый набор данных из учебников значительно улучшил плотность знаний и корреляцию изображений, обеспечивая более прочную основу для изучения VLM. Кроме того, исследование привлекло широкое внимание академического сообщества, а соответствующие наборы данных быстро поднялись на вершину популярного списка на платформе Hugging Face: всего за две недели их скачали более 7000 раз.

С помощью этой инновационной попытки исследователи надеются не только способствовать развитию VLM, но и открыть новые возможности в интеграции и применении образовательных ресурсов.

Адрес статьи: https://arxiv.org/pdf/2501.00958.

Этот результат исследования не только имеет большое значение для области искусственного интеллекта, но и обеспечивает новое направление для будущей реформы модели образования, указывая на широкие перспективы применения технологий искусственного интеллекта в сфере образования. Открытый источник этого набора данных также предоставляет ценные ресурсы для исследователей по всему миру и способствует сотрудничеству и обменам в академическом сообществе.