В этой статье представлен метод LLM2Clip, разработанный Microsoft в сотрудничестве с Университетом Тонгджи, который направлен на улучшение производительности визуального энкодера модели клипа и решить его ограничения при обработке длинных и сложных текстовых описаний. LLM2Clip значительно повышает способность модели соответствовать изображениям и текстам, интегрируя модели крупных языков (LLMS) и внедряя технологию «Fine-Contrast» на титул. Экспериментальные результаты этого метода по нескольким наборам данных показывают, что в задачах поиска с изображением в тексте и текстовых поисках, особенно в задачах извлечения в течение длительного и короткого текста, они превосходят традиционные модели клипа и EVA и демонстрируют мощную кросс-обработку. способность.

В современной области науки и техники клип (контрастная предварительная тренировка языка) является важной мультимодальной базовой моделью. Он объединяет визуальные и текстовые сигналы в общее пространство функций, используя контрастные потери обучения на крупномасштабных парах текста изображения.

В качестве поисковика клип может поддерживать различные задачи, такие как классификация с нулевым выстрелом, обнаружение, сегментация и поиск текста изображения. Между тем, в качестве экстрактора функции, он доминирует почти во всех межмодальных задачах представления, таких как понимание изображений, понимание видео и генерация текста до изображения или генерация видео. Что мощно в клипе, так это его способность подключать изображения к естественному языку и захватывать человеческие знания благодаря его обучению к крупномасштабным сетевым данным, которые содержат подробные описания текста.

Тем не менее, CLIP имеет определенные ограничения в работе с длинными и сложными описаниями текста. Чтобы преодолеть эту проблему, исследователи из Университета Microsoft и Tongji предложили метод LLM2Clip, стремясь улучшить обучение визуальному представлению путем интеграции крупных языковых моделей (LLMS). Этот метод смело заменяет оригинальный текстовый энкодер с зажимами и использует богатые знания LLMS для улучшения визуального энкодера. Исследование показало, что непосредственная интеграция LLMS в клип приводит к снижению производительности, поэтому необходимо решить эту проблему.

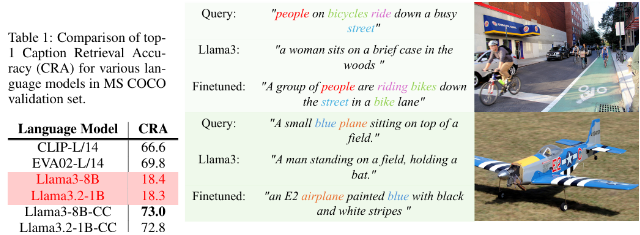

Метод LLM2Clip значительно улучшает способность LLM отделять названия изображений, внедряя технологию «Точная настройка контраста», тем самым достигая значительного улучшения производительности.

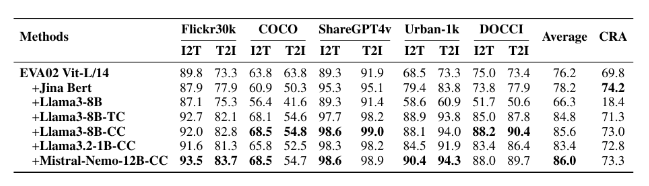

Исследователи использовали наборы данных разных размеров для экспериментов с тонкой настройкой, включая небольшие CC-3M, средний CC-3M и CC-12M, а также крупные CC-3M, CC-12M, YFCC-12M и Recaption-1B. Результаты показывают, что модель, обученная с использованием LLM2Clip, работает лучше, чем традиционные модели клипа и EVA в задачах поиска с изображением в тексте и текстовых изображения.

Сочетая мультимодальное обучение с такими моделями, как Llava 1.5, LLM2Clip выполнял хорошо практически во всех критериях, особенно при работе с длинными и короткими задачами поиска текста, что улучшило производительность предыдущей модели EVA02 на 16,5%. Этот инновационный подход не только преобразует клип из простой обработки английских данных в мощную модель поперечного языка, но и закладывает основу для будущих исследований обучения клипам.

Модель: https://huggingface.co/collections/microsoft/llm2clip-672323a266173cfa40b32d4c

Код: https://github.com/microsoft/llm2clip/

Бумага: https://arxiv.org/abs/2411.04997

Очки:

LLM2Clip - это инновационный подход, предложенный Университетом Microsoft и Tongji в сотрудничестве с Университетом Тонгджи, с целью повышения производительности своего визуального энкодера путем замены текстового энкодера Clip.

Этот метод значительно повышает способность модели соответствовать изображениям с текстом с помощью метода «Точная настройка» на заголовок, превосходя существующие современные модели.

Эксперименты LLM2Clip по нескольким наборам данных показывают, что он работает лучше, чем традиционные модели в длинных и коротких задачах извлечения текста, управляя разработкой моделей межязывания.

Короче говоря, метод LLM2Clip предоставляет новые идеи для улучшения модели клипа. Ссылки на связанные с ресурсами удобны для читателей для изучения и исследований.